Optimale VR-Brille: Meta nennt 10 Herausforderungen

Bis Virtual Reality ihr technisches Potenzial erreicht, gibt es viele Hürden zu nehmen. Metas Display-Chef sagt, was dazu nötig ist.

Douglas Lanman arbeitet seit acht Jahren bei Meta und leitet die Abteilung, die komplette Display-Systeme entwickelt.

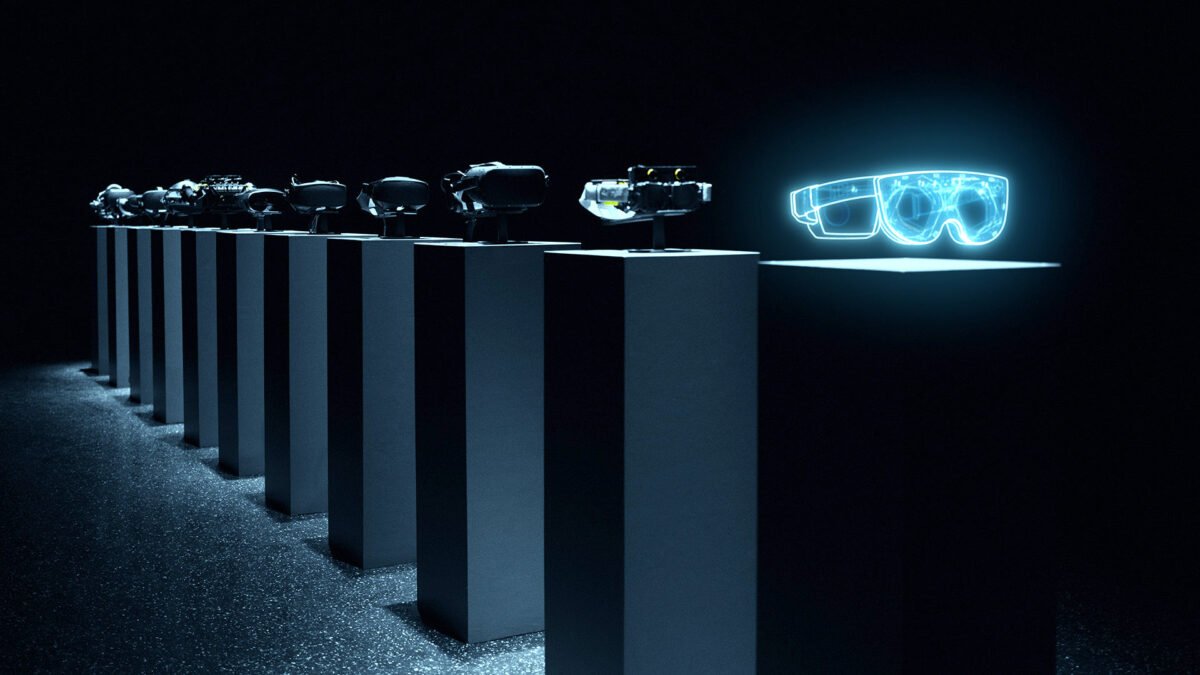

Im Juni stellte sein Team neue VR-Brillenprototypen vor, die unterschiedliche technische Herausforderungen wie Auflösung, Helligkeit und Formfaktor angehen. Das Ziel der Forscher:innen ist ein VR-Display, das die physische Realität visuell reproduzieren kann und zugleich in einem kompakten Headset Platz hat.

___STEADY_PAYWALL___Auf der diesjährigen Siggraph-Konferenz hielt Lanman einen Vortrag über diese Aufgabe und nannte zehn Hürden, die bei der Entwicklung einer solchen VR-Brille noch zu nehmen sind.

Es folgt eine Liste dieser Herausforderungen samt einer kurzen Erklärung und weiterführenden Links. Das Video von Lanmans Vortrag findet ihr am Ende des Artikels.

Interessant in diesem Kontext ist, dass Meta an einem Headset forscht, das Durchbrüche in vielen dieser Bereiche schaffen soll, darunter Ergonomie, variabler Fokus, adaptive Sehkorrektur, Eye-Tracking und Durchsicht. Das noch reine konzeptuelle Headset hört auf den Codenamen Mirror Lake.

Die zehn Herausforderungen

Inhalt

Höhere Auflösung

Aktuelle VR-Headsets kommen in puncto Auflösung nicht ans menschliche Sehvermögen heran. Damit virtuelle Welten so echt und scharf aussehen, als wären sie physischer Natur und Texte auch in mittlerer Entfernung gut lesbar sind, muss die Auflösung erheblich steigen.

Meta nennt als vorläufige Zielvorgabe 8K pro Auge und eine Pixeldichte von 60 PPD. Zum Vergleich: Die Meta Quest 2 kommt gerade mal auf 2K pro Auge und 20 PPD.

Je höher die Auflösung, desto schärfer das Bild. Oculus Rift, Meta Quest 2 und der Butterscotch-Prototyp im Sehtafelvergleich. | Bild: Meta

Mit dem Butterscotch-Prototyp entwickelte Meta ein experimentelles Headset, mit dem die Forscher:innen "Retina-Auflösung" erleben und deren immersiven Effekt studieren können.

Die Entwicklung und Herstellung hochauflösender Display ist nicht das größte Problem. Die Frage ist viel eher, woher die Rechenleistung kommen soll, die solche hochauflösenden Displays befeuert. Foveated Rendering und Cloud-Streaming könnten helfen, stellen selbst jedoch große technische Herausforderungen dar.

Weiteres Sichtfeld

Auch beim Sichtfeld muss sich noch viel tun. Das horizontale Sichtfeld des Menschen ist über 200 Grad weit. Handelsübliche VR-Brillen erreichen in der Regel etwa 100 Grad horizontales Sichtfeld. Aber auch beim vertikalen Sichtfeld gibt es noch Luft nach oben.

Ein weiteres Sichtfeld stellt Linsentechnik vor große Herausforderungen, die sich unter anderem in Bildverzerrungen an den Sichtfeldrändern äußern. Zudem müssen Linsen und Display so gebaut sein, dass sie den Formfaktor nicht vergrößern.

Auch bei dieser Herausforderung stellt sich die Frage nach der Rechenleistung: Je weiter das Sichtfeld ist, desto mehr Bildpunkte muss die VR-Brille darstellen. Dies resultiert wiederum in einem höheren Leistungsbedarf und mehr Abwärme.

Ergonomie

Aktuelle VR-Headsets sind schwer und wuchtig. Meta Quest 2 zum Beispiel wiegt mehr als 500 Gramm und ragt knapp 8 Zentimeter vom Gesicht weg. Eine VR-Brille muss idealerweise über längere Zeit bequem zu tragen und weitaus schmaler und leichter gebaut sein.

Das Bild zeigt einen VR-Brillenprototyp mit holografischem Display, der in eine Sonnenbrille passt. Transparent dargestellt ist eine Oculus Rift von 2016, um den Unterschied beim Formfaktor hervorzuheben. | Bild: Meta

Pancake-Linsen und holografische Linsen sollen Abhilfe schaffen. Metas voll funktionsfähiger Holocake-2-Prototyp zeigt, in welche Richtung sich der Formfaktor entwickeln könnte. Das Problem: Holocake 2 nutzt eigens gefertigte Laser als Lichtquelle, die noch nicht fertig entwickelt und in Massen herstellbar sind.

Display mit Sehkorrektur

Das perfekte VR-Headset sollte Sehschwächen der Nutzer:innen erkennen und ausgleichen können, um herkömmliche Brillen oder Kontaktlinsen unter der VR-Brille überflüssig zu machen.

Passt das Nasenfahrrad unter die VR-Brille, oder zerkratzt es womöglich die Linsen? Auch mit solchen Fragen sollten sich Nutzende in Zukunft nicht mehr auseinandersetzen müssen.

Das Problem ließe sich durch spezielle Linsenaufsätze lösen oder noch besser durch eine VR-Optik, die sich auf die eigene Sehstärke einstellen lässt. Die Herausforderung ist, eine Lösung zu finden, die wenig Platz- und Energiebedarf hat, günstig herzustellen ist und leicht genug ist.

Linsenaufsätze mit Sehstärkenkorrektur gibt es schon. Eine ideale Lösung sind sie nicht, da sie zusätzliche Kosten verursachen, die VR-Brille schwerer machen und ein simples Weiterreichen verhindern. | Bild: Meta

Variabler Fokus

Das menschliche Auge kann in Virtual Reality nicht so fokussieren wie in natürlichen Umgebungen. Dieses Problem entsteht primär im Nahbereich und kann nach einer längeren Verweildauer zu einer Übermüdung der Augen, Kopfschmerzen und Unwohlsein führen.

Die Ursache nennt man in der Fachsprache Vergenz-Akkommodation-Konflikt (Erklärung).

Um dieses Problem zu lösen, entwickelte Metas Forscher:innen ein Display, das Gleitsicht unterstützt. Es simuliert verschiedene Fokusebenen sowie Unschärfe und hilft dem Auge, die virtuelle Welt so zu sehen, als sei sie natürlich.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Metas Gleitsicht-Prototypen hören auf den Namen Half-Dome.

Eye-Tracking für alle

Die Blickerfassung ist eine Schlüsseltechnologie der Virtual Reality, weil sie Grundlage vieler anderer wichtiger VR-Technologien ist - etwa varifokale Displays (siehe Punkt 5), Foveated Rendering und Verzerrungskorrektur (siehe Punkt 7).

Ferner ermöglicht sie Blickkontakt in sozialen Erlebnissen sowie neue Interaktionsformen.

Die Form der Pupille unterscheidet sich von Mensch zu Mensch, kann sich bei Augenbewegungen verändern und durch Augenlider und Wimpern verdeckt werden. Das ist eine Herausforderung für Eye-Tracking-Systeme. | Bild: Meta

Das Problem beim Eye-Tracking ist, dass sie nicht für alle Menschen gleich gut funktioniert und anfällig für Aussetzer ist. Ein zuverlässiges Eye-Tracking mit breiter demografischer Abdeckung ist notwendig, damit die Technologie nicht frustriert.

Verzerrungskorrektur

Linsen bringen Bildverzerrungen mit sich, die durch Software korrigiert werden müssen.

Die feinsten Verzerrungen entstehen durch bloße Bewegung der Pupille. Sie beeinträchtigen den visuellen Realismus, gerade im Zusammenspiel mit anderen Technologien wie Gleitsicht-Displays.

Die große Herausforderung liegt in der Entwicklung der Korrekturalgorithmen: Die Display-Forscher:innen müssen Linsen und Headsets herstellen, um entsprechende Software in der Praxis testen und anpassen zu können. Ersteres kann Wochen oder sogar Monate dauern, was quälend langsame Iterationszeiten mit sich bringt.

Um die Entwicklung zu beschleunigen, entwickelten Meta-Forscher:innen einen Verzerrungsimulator (siehe Video oben). Mit ihm lassen sich verschiedene Linsen, Auflösungen und Sichtfeldweiten testen, ohne erst ein Test-Headset und spezielle Linsen zu bauen.

High Dynamic Range (HDR)

Physische Objekte und Umgebungen leuchten weitaus stärker als VR-Displays, selbst in geschlossenen Räumen mit künstlichem Licht.

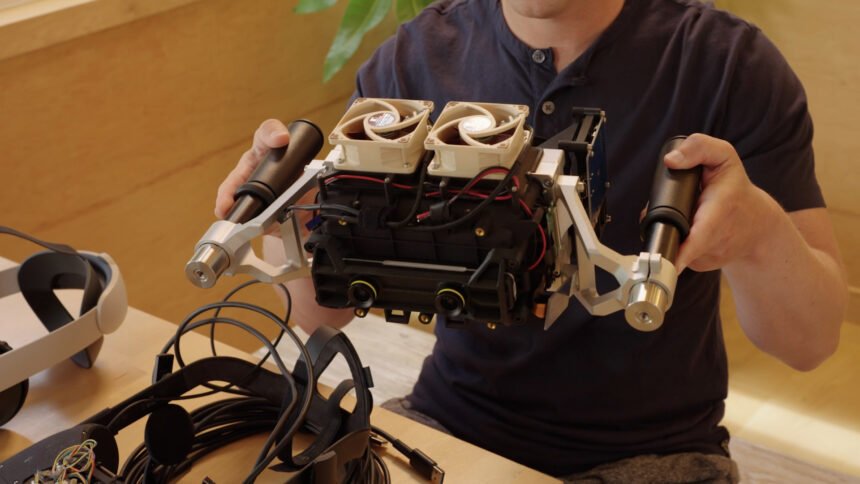

Meta baute mit Starburst einen VR-Prototyp, der in der Lage ist, bis zu 20.000 Nits darzustellen. Zum Vergleich: Ein guter HDR-Fernseher kommt auf mehrere tausende Nits, Meta Quest 2 auf gerade mal 100 Nits.

Mark Zuckerberg hält den Starburst-Prototyp. | Bild: Meta

Starburst kann Lichtbedingungen in geschlossenen Räumen und Nachtumgebungen realistisch simulieren. Das Ergebnis sind virtuelle Objekte und Welten, die solider und dreidimensionaler wirken, als es derzeitige VR-Brillen darstellen können.

Bei der technischen Umsetzbarkeit hapert es allerdings noch: Der aktuelle Prototyp ist so schwer, dass er an einer Vorrichtung von der Decke hängt – und er ist extrem energiehungrig.

Laut Meta trägt HDR mehr zum visuellen Realismus bei als etwa Auflösung und variabler Fokus und ist am weitesten von einer praktikablen Umsetzung entfernt.

Durchsicht

Die perfekte VR-Brille muss in beide Richtungen durchlässig sein: VR-Nutzer:innen sollten ebenso die Umgebung sehen können, wie die Umgebung die VR-Nutzer, unter anderem aus Gründen des Nutzungskomforts und sozialer Akzeptanz.

Im ersten Fall filmen Headset-Sensoren die Umgebung und stellen sie als Video-Abbild in Virtual Reality dar. Diese Passthrough genannte Technik existiert bereits in handelsüblichen VR-Headsets, allerdings in ziemlich schlechter Qualität. Meta Quest 2 etwa bietet einen Passthrough-Modus in körnigem Schwarzweiß. Meta Quest Pro soll diesen Darstellungsmodus durch eine höhere Auflösung und Farbe spürbar verbessern.

Links eine Oculus Rift, die den Blick auf die Augen des VR-Nutzers versperrt. Rechts Metas Reverse-Passthrough-Prototyp, der noch recht Furcht einflößend aussieht. | Bild: Meta

Eine perfekte Rekonstruktion der physischen Umgebung ist damit aber noch nicht erreicht. Eines der noch zu lösenden Probleme ist, dass die Passthrough-Technik eine von den Augen räumlich versetzte Perspektive auf die Welt einfängt, was bei längerer Nutzung den menschlichen Wahrnehmungsapparat irritieren kann. Meta forscht deswegen an einer KI-gestützten Blicksynthese, die perspektivisch korrekte Blickpunkte in Echtzeit und mit hoher visueller Wiedergabetreue erzeugt.

Im umgekehrten Fall, den Meta Reverse Passthrough nennt, sehen Außenstehende die Augen und das Gesicht der VR-Nutzer:innen und können so Augenkontakt herstellen oder den Gesichtsausdruck ablesen. Möglich machen könnten das nach innen gerichtete Sensoren und ein externes (Lichtfeld-)Display. Diese Technologie ist noch weit von der Marktreife entfernt.

Gesichtsrekonstruktion

Ko-Präsenz und Metaverse-Telefonie sind Metas Endziele. Das Unternehmen will, dass Menschen sich eines Tages in virtuellen Räumen treffen und sich dabei so fühlen, als wären sie im gleichen Raum anwesend. Zu diesem Zweck forscht Meta an fotorealistischen Codec-Avataren, deren Herstellung und Berechnung aber noch sehr aufwendig ist.

Die Quest Pro kann Mimik erkennen und in die VR übertragen. | Bild: Meta

Ein erster Schritt in diese Richtung sind VR-Brillen, die die Mimik von VR-Nutzer:innen in Echtzeit ablesen und in die Virtual Reality übertragen können. Quest Pro wird Metas erstes Headset, das Facetracking bietet.

Douglas Lanmans Siggraph-Vortrag

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.