So stellt sich Facebook die AR-Zukunft vor

Facebooks Vision der Computerzukunft nimmt langsam Gestalt an. Einem neuen Blogpost zufolge setzt das Unternehmen auf ein Trio von AR-Brille, neuralem Armband und haptische Handschuhe.

Facebook startete diese Woche mit einer neuen Blogpost-Reihe, die Einblick in die XR-Forschung des Unternehmens gibt und die Entwicklung zukünftiger Mensch-Computer-Interaktion beleuchtet. Facebook meint damit ein AR-Interface, das mittels Künstlicher Intelligenz Kontexte und Situationen begreift und den Nutzer proaktiv in seinem Alltag unterstützt.

Ein solches Interface soll in den nächsten zehn Jahren entstehen und Grundlage einer fortschrittlichen AR-Brille Marke Facebook werden, die das Smartphone komplett ersetzt.

___STEADY_PAYWALL___Ein neues Computerparadigma

Im kürzlich erschienenen ersten Blogpost geht es um diese weit in die Zukunft reichende Augmented-Reality-Vision, die ein neues Paradigma der Computerinteraktion mit sich bringt. Wenn sich AR-Brillen durchsetzen sollen, dann brauchen sie ein neues, maßgeschneidertes Interface. Maus und Tastatur oder Touch-Displays wären ungeeignet für ein Gerät, das mitten im Gesicht sitzt. Stattdessen wäre eine Kombination neuer, natürlicherer Arten der Interaktion gefragt: Man denke an Blick-, Gesten- und Sprachsteuerung.

Die Grundlagen heutiger Interfaces wie Maussteuerung und grafische 2D-Nutzeroberflächen wurden in den 60ern entwickelt und prägen die Mensch-Computer-Interaktion bis heute. Für Augmented Reality muss sie neu erfunden werden.

Die AR-Brillen der Zukunft sollten ähnlich arbeiten wie der menschliche Geist, schreibt Facebook. Um hilfreich zu sein, müssen sie Alltagssituationen verstehen und proaktiv und dynamisch auf sie reagieren können.

"Augmented Reality setzt eine reibungslos funktionierende, stets verfügbare Technologie voraus, die so intuitiv zu nutzen ist, dass sie zu einer Erweiterung des eigenen Körpers wird", sagt Michael Abrash, der Leiter von Facebook Reality Labs Research. "Wir müssen komplett neues Interfaces erfinden, eines, das den Menschen in den Mittelpunkt der Computerinteraktion rückt."

Ein Armband dient als neurales Interface

Das für die Entwicklung des neuen Interfaces verantwortliche Team besteht aus mehreren hundert interdisziplinären Fachkräften und wird von Sean Keller geleitet.

Keller führt Abrashs Gedanken eines nutzerzentrierten AR-Interfaces aus: "Wir stellen uns Input und Output für gewöhnlich aus der Perspektive des Computers vor. AR-Interaktion ist ein Sonderfall, weil wir von einem tragbaren Computer sprechen, der im Laufe des Tages gemeinsam mit dem Nutzer wahrnimmt, lernt und handelt."

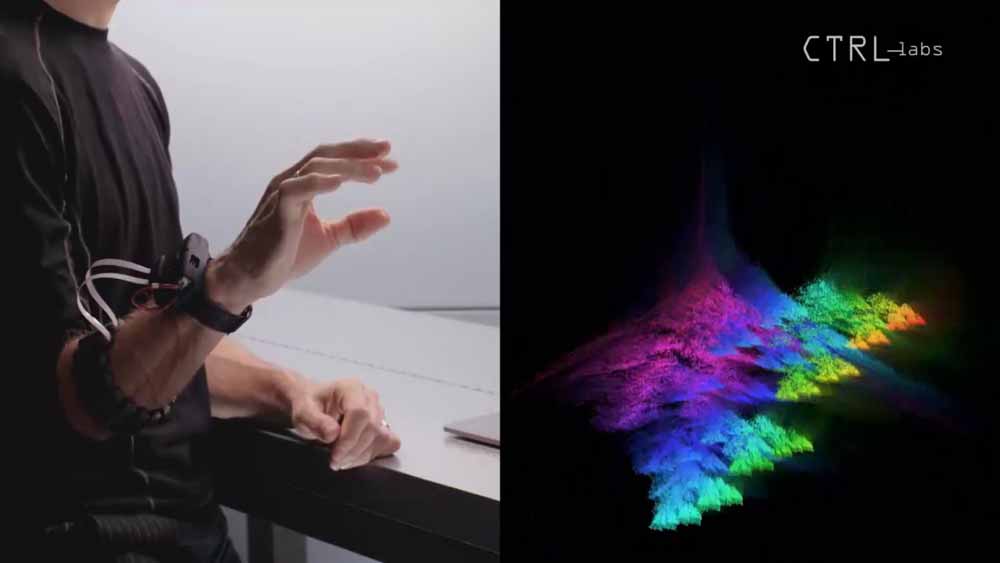

In 2019 kaufte Facebook das Startup CTRL-Labs, das ein neurales Interface fürs Handgelenk entwickelte. | Bild: CTRL-Labs

Facebook definiert im Blogpost zwei wichtige Grundlagen für das AR-Interface der Zukunft definiert. Die erste Grundlage besteht in einer möglichst einfachen Interaktion. Eingaben müssen kurz und intuitiv sein, egal, auf welche Weise sie erfolgen. Facebook forscht in verschiedenste Richtungen und arbeitet an Blick-, Gesten- und Sprachsteuerung.

Eine noch natürlichere Art der Interaktion bieten laut Facebook neurale Interfaces, die Muskelaktivitäten mittels KI analysieren und in Computerbefehle übersetzen. Als vielversprechendste Variante eines neuralen Interfaces habe sich ein Armband erwiesen. Die Signale am Handgelenk seien so klar, dass feinste Fingerbewegungen erkannt werden könnten. Eine Eingabe könnte so mühelos und praktisch unsichtbar erfolgen.

Um die Entwicklung handgelenksbasierter neuraler Interfaces voranzutreiben, kaufte Facebook in 2019 das Start-up CTRL-Labs, das an einem solchen Armband arbeitete. Einem Bericht zufolge könnte die Technologie bereits 2022 in einer Facebook-Smartwatch auftauchen.

Eine kontextsensitive KI

Als zweite Grundlage des AR-Interfaces der Zukunft nennt Facebook Künstliche Intelligenz, Kontext und Personalisierung. AR-Brillen müssen sich an ihre Nutzer anpassen und Kontexte erfassen können, um Nutzen zu stiften. So könnten sie zum Beispiel erkennen, wenn man das Haus verlässt und die Außentemperatur anzeigen oder den Kaloriengehalt eines Produkts darstellen, das man im Supermarkt in die Hand nimmt.

Um herauszufinden, welche Umgebungsdaten eine Künstliche Intelligenz braucht, um dieser Aufgabe gewachsen zu sein, rief Facebook Project Aria ins Leben. Für das Forschungsprojekt schickt Facebook ausgewählte Angestellte und Leiharbeiter mit einer Sensorbrille auf die Straße, die egozentrische Datensätze sammelt. Damit sind Informationen gemeint, die aus der menschlichen Perspektive registriert werden. Die Analyse dieser Daten soll in eine Brillen-KI fließen, die dynamisch auf alltägliche Situationen reagieren kann.

So sieht Facebooks Sensorbrille aus. Sie dient lediglich der Erfassung egozentrischer Daten und stellt keine Information dar. | Bild: Facebook

Das Armband liefert auch die Haptik

Nun ist ein intuitives und kontextsensitives Interface längst nicht alles, was eine fortschrittliche AR-Brille braucht. Haptik ist ebenso wichtig für den Menschen, schließlich ließen sich auch Maus und Tastatur sowie Touch-Display ohne Spürsinn kaum so effektiv bedienen.

Aus diesem Grund arbeitet Kellers Team an haptischer Elektronik, die von weicher Beschaffenheit ist und den ganzen Tag auf der Haut getragen werden kann - etwa in Form eines Armbands.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Keine Frage: Facebooks haptische Technologie wird in das gleiche Armband fließen, das Muskelaktivitäten misst und in Computerbefehle uminterpretiert. Das Unternehmen arbeitete schon vor der Übernahme von CTRL-Labs an einem Armband, das auf den Namen Tasbi hört und recht ausgefeilte haptische Effekte ermöglicht.

Nächste Woche sollen im zweiten Blogpost konkrete Forschungsergebnisse vorgestellt werden: Zu sehen sein dürften Facebooks Armband samt neuralem Interface sowie eine KI, die eingeschränkt auf den Nutzer und seine Umgebung reagieren kann.

Später in diesem Jahr werden im dritten Blogpost bequeme und den ganzen Tag tragbare Geräte präsentiert sowie ein Update zur Forschung im Bereich haptischer Handschuhe. Auch hierzu gab es in der Vergangenheit schon einiges zu sehen.

Facebook will nächste Woche mehr über seine Armband-Forschung erzählen und zeigt vorab das Bild eines Prototyps. | Bild. Facebook

Ein Cafébesuch im Jahre 2030

Facebook will all diese Elemente im Laufe der nächsten zehn Jahre zusammenführen und verwirklichen. Um sich diese abstrakt wirkende Technologie im Zusammenspiel bildlich vorstellen zu können, beschreibt sie Facebook mit folgendem Beispiel, das an dieser Stelle unverändert wiedergegeben werden soll:

"Angenommen, sie gehen zu Ihrem örtlichen Café, um zu arbeiten. Sie tragen eine AR-Brille und ein angenehmes Armband. Als Sie zur Tür hinausgehen, fragt Ihr Assistent, ob Sie die neueste Folge Ihres Lieblingspodcasts hören möchten. Mit einer kleinen Bewegung Ihres Fingers klicken Sie auf 'Abspielen'.

Als Sie das Café betreten, fragt der Assistent: "Soll ich einen Americano bestellen?" Nicht in der Stimmung für das Übliche, bewegen Sie erneut ihren Finger, um auf "Nein" zu klicken.

Sie gehen zu einem Tisch, aber anstatt einen Laptop herauszuziehen, nehmen Sie ein Paar weiche und leichte haptische Handschuhe heraus. Sobald Sie sie anlegen, erscheint ein virtueller Bildschirm und eine Tastatur vor Ihnen und Sie beginnen, ein Dokument zu bearbeiten. Das Tippen ist genauso intuitiv wie auf einer physischen Tastatur und Sie kommen gut voran, aber der Lärm aus dem Café macht es schwierig, sich zu konzentrieren.

Der Assistent erkennt, was Sie gerade tun, und bemerkt, dass die Umgebung laut ist. Der Assistent nutzt spezielle In-Ear-Mikrofone und aktives Noise Cancelling, um Hintergrundgeräusche zu minimieren. Jetzt ist es einfach, sich zu konzentrieren.

Ein Kellner, der an Ihrem Tisch vorbeikommt, fragt, ob er Café nachfüllen soll. Die Brille weiß, dass sie ihre eigene Stimme nicht herausfiltern muss und verstärkt Ihre Stimme proaktiv mithilfe von Beamforming. Sie beide führen ein normales Gespräch, während Ihr Kaffee nachgefüllt wird.

Ein Freund ruft an und Ihr Assistent leitet den Anruf automatisch an die Voicemail weiter, um Ihr aktuelles Gespräch nicht zu unterbrechen. Wenn es Zeit ist, die Kinder abzuholen, erhalten Sie eine visuelle Erinnerung, damit Sie aufgrund der aktuellen Verkehrsbedingungen nicht zu spät kommen."

Quelle: Tech@Facebook, Titelbild: Facebook (Konzept einer AR-Visorbrille)

Weiterlesen über Facebook-Forschung:

- Supergehör und Audio-Teleporter: Facebook zeigt neueste Forschung

- Facebooks erste Datenbrille erscheint 2021

- Oculus: Next-Gen-VR-Brille weiter in Entwicklung

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.