ARCore: Google verbessert Raumerkennung für realistischere AR

Im Rahmen der Google I/O stellt das Unternehmen zwei neue Schnittstellen für ARCore vor: Eine bietet bessere 3D-Erkennung, die andere ortsunabhängige AR.

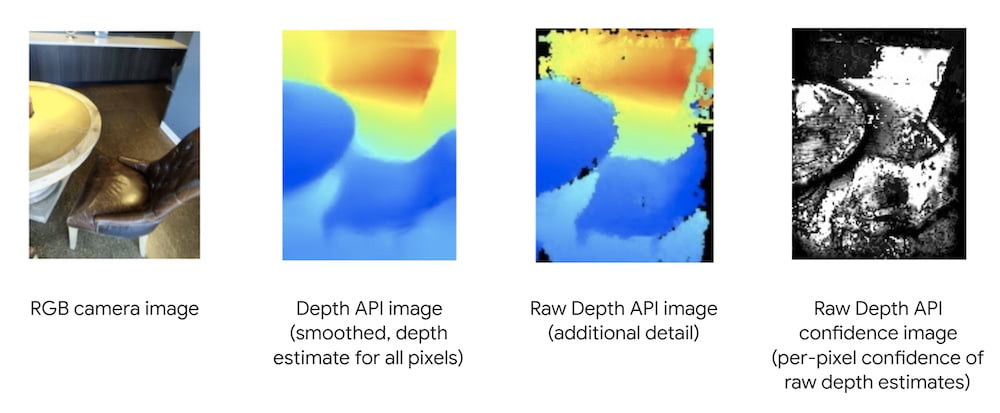

2020 führte Google die sogenannte Depth API ein. Mit dieser Schnittstelle können herkömmliche Smartphone-Kameras ohne speziellen 3D-Sensortechnik und in Echtzeit annähernd die Tiefenstruktur des umgebenden Raums schätzen. Die 3D-Erkennung erlaubt so zum Beispiel, dass eine digital eingeblendete Katze von einem Sofa verdeckt wird oder digitale Würfel auf physikalisch realistische Weise eine Treppe herunterfallen.

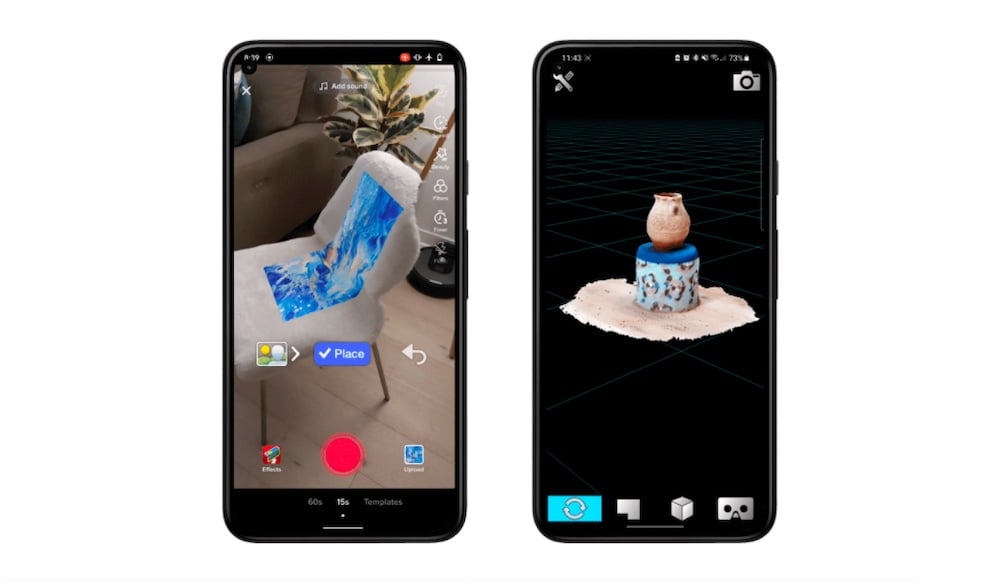

Mit der neuesten ARCore Version 1.24 führt Google die Raw Depth API ein, die detaillierte Tiefeninformationen aus der Umgebung gewinnen kann, indem zusätzliche "raue", das heißt unbereinigte Tiefenschätzungen in die Raumanalyse einbezogen werden. Google nennt eine Reihe von Apps, die bereits von der neuen Schnittstelle profitieren, darunter TikTok und die 3D-Scanning-App 3D Live Scanner.

___STEADY_PAYWALL___Die zweite neue Schnittstelle heißt Recording and Playback API und erlaubt schnellere Entwicklungszyklen für AR-Entwickler. Statt jedes Mal das Büro zu verlassen, um bestimmte, besonders geeignete Orte für das Testen von AR-Apps aufzusuchen, können Entwickler nun die spezifischen Gegebenheiten eines Testszenarios sensortechnisch in Gänze einfangen und bei Bedarf im Büro wiedergeben.

Die Schnittstelle erlaubt auch neue, ortsunabhängige Arten von AR-Apps, bei denen man Videos nachträglich AR-Objekte hinzufügen kann. Wer sein Wohnzimmer virtuell einrichten möchte, kann es einmal mit der Kamera einfangen und danach von überall aus um AR-Objekte erweitern, da Informationen der Bewegungssensoren sowie die räumliche Struktur ebenfalls gespeichert werden.

Google AR muss ohne 3D-Sensoren auskommen

Google betont, dass Raw Depth API wie schon die ältere Depth API keine speziellen 3D-Sensoren benötigt werden, auch wenn solche die Raumerkennung weiter verbessern. Google versuchte mit Project Tango vor Jahren, eine 3D-Sensorplattform für Android-Smartphones zu etablieren. Weil die Hardware zusätzliche Herstellungskosten und wenigem praktischen Mehrwert brachte, entschied sich die Mehrheit der Smartphone-Hersteller, auf die 3D-Sensortechnik zu verzichten. 2017 gab Google das Project Tango auf.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Die Raw Depth API zieht mehr ungefilterte Sensorinformation hinzu und kommt so zu einer präziseren Raumeinschätzung als die ältere Depth API. | Bild: Google

Als Apple mit ARKit im gleichen Jahr eine Schnittstelle für Raumerkennung mittels herkömmlicher RGB-Kameras vorstellte, verlegte sich Google ebenfalls auf AR ohne spezielle 3D-Sensoren und brachte im darauffolgenden Jahr ARCore heraus. 2020 führte Apple den Lidar-Scanner, einen auf Raumerkennung spezialisierten 3D-Sensor, im iPad Pro und den iPhone 12-Flaggschiffen ein, der unter anderem realistischere Augmented Reality ermöglicht.

Während der 3D-Sensor mit dem nächsten iPhone 13 zur Standardausstattung des Smartphones werden könnte, sieht es bei Android-Geräten anders aus. Samsung verzichtet für seine neuesten Geräte bewusst auf einen ToF-Sensor und Berichten zufolge könnte das auch für die nächste Generation Galaxy-Geräte gelten. Da Google anders als Apple nur die Smartphone-Software kontrolliert, bleibt dem Unternehmen vorerst nichts anderes übrig, als auf Tiefenerkennung mittels RGB-Kameras zu setzen.

Quelle und Titelbild: Google Blog

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.