Googles Hunderoboter lernt das Laufen durch Hundevideos

Wenn sich Roboter Bewegungen einfach in Videos abschauen könnten, würde das die Entwicklung deutlich vereinfachen. Google AI testet eine mögliche Methode für die Bewegungsübertragung am Beispiel eines Hunderoboters.

Boston Dynamics Hunderoboter Spot oder das humanoide Modell Atlas sind in den letzten Jahren viel beweglicher und mobiler geworden. Konnte beispielsweise Atlas am Anfang kaum einen Fuß vor den anderen setzen, springt er jetzt wie ein begabter Turner über Hindernisse hinweg.

So beeindruckend dieser Fortschritt ist, so aufwendig ist er auch: Boston Dynamics Software-Ingenieure mussten über Jahre hinweg viele Zeilen Code schreiben, löschen und neu schreiben, bis sie diesen Grad an maschineller Beweglichkeit erreicht hatten.

___STEADY_PAYWALL___Einfacher wäre es, der Roboter würde sich, ähnlich wie ein Mensch, Bewegungen abschauen, nachahmen und dann feinjustieren.

Googles Hunderoboter lernt von Hundevideos

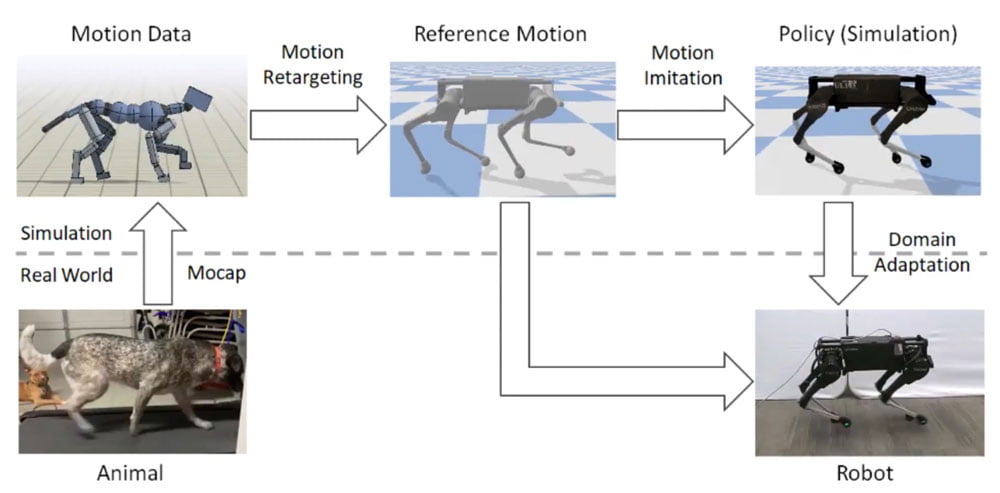

Gemeinsam mit der Universität Berkeley entwickelte Google AI einen automatisierten Ansatz, um Robotern realistische Bewegungen beizubringen: Die Bewegungsdaten aus Hundevideos übertrugen sie auf ein virtuelles Hundemodell, das dann an die Proportionen und Funktionen des Hunderoboters Laikago angepasst wurde. Nach einem Simulationstraining wanderte das Bewegungsschema auf den realen Roboter.

Reale Hundebewegungen werden auf ein digitales Modell übertragen und wandern nach dem KI-Training in einer Simulation auf den Hunderoboter. Der lernt so realistische Hundebewegungen. Bild: Google AI

Mit bestärkendem Lernen (Erklärung) werden die Bewegungsalgorithmen feinabgestimmt, um möglichst exakt die Agilität eines echten Hundes zu erreichen. Die Hunderobotersimulation testet dafür zufällige Bewegungen und wird digital belohnt, wenn sie sich einer Referenzbewegung nähert. Weicht sie davon ab, gibt es Punktabzug.

Beim Simulationstraining veränderten die Forscher Parameter wie Widerstand oder Latenz zufällig, um möglichst viele Echtwelt-Szenarien abzudecken und so die Robustheit des Bewegungssystems zu verbessern.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Dann übertrugen sie das Simulationsmodell auf den realen Roboter. Mit Erfolg: Der Roboter kann einige typische Hundebewegungen realistisch nachahmen. Manuell einprogrammierte Bewegungsabläufe können weiter ergänzt werden.

Die Agilität des Hunderoboters ist zwar insgesamt noch nicht auf dem Niveau der Modelle von Boston Dynamics, die auch Treppen oder über Hindernisse steigen können. Dafür wurde der menschliche Programmieraufwand reduziert. Laut der Google-Forscher lernte ihr Modell außerdem schnellere Gangarten im Vergleich zur Hersteller-Software.

Im folgenden Video erklären die Google-Forscher den Entwicklungsprozess im Detail. Eine Forschergruppe der ETH Zürich stellte Anfang 2019 einen ähnlichen Ansatz vor.

Weiterlesen über KI und Roboter:

- Was ein Roboterphilosoph über Maschinenmoral denkt

- Weshalb Roboter noch über Realitätslücken stolpern

- KI-Boom Hype oder Realität? Fakten zur Künstlichen Intelligenz

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.