Metas fotorealistische Avatare machen Fortschritte

Sich virtuell mit Menschen treffen, als wären sie im gleichen Raum: Das ist Metas großes Ziel. Die Codec-Avatare sollen das leisten.

Im Frühjahr 2019 präsentierte Meta zum ersten Mal Forschung an hochentwickelten Avataren, die eines Tages Videokonferenzen ablösen sollen.

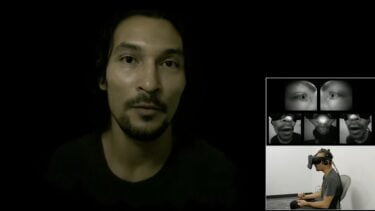

Die Nutzer:innen tragen eine prototypische VR-Brille, die die Augen- und Mundpartie mittels fünf Sensoren aufzeichnet. Mithilfe eines KI-Modells wird aus diesen Daten in Echtzeit ein beeindruckend realistischer Avatar generiert, samt Augenbewegungen und feinster Mimik.

___STEADY_PAYWALL___Zuvor müssen die Nutzer:innen sich in einem speziellen 3D-Studio einscannen lassen. Die Hoffnung des Forscherteams ist, dass man in Zukunft selbst einen hochwertigen 3D-Scan des Gesichts erstellen kann, zum Beispiel mit dem Smartphone.

Aktuell setzt Meta auf Avatare im Comic-Stil, ein Zugeständnis an die stark begrenzte Rechenleistung der Meta Quest 2.

Codec-Avatare 2.0 laufen auf Quest 2

In den letzten Jahren verbesserte Meta die Codec-Avatare schrittweise, indem das Team die KI-Algorithmen optimierte und den Avataren realistischere Augen verpasste.

Im Rahmen eines MIT-Workshops präsentierte Teamleiter Yaser Sheikh den aktuellen Stand der Forschung und zeigte ein kurzes Video, das die neueste Version der fotorealistischen Avatare, die "Codec-Avatare 2.0", demonstrieren soll.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

In einem wissenschaftlichen Paper aus dem letzten Jahr beschreiben die Forscher:innen jüngste KI-Fortschritte. Das künstliche neuronale Netz ist demnach in der Lage, nur die sichtbaren Pixel eines Avatars zu berechnen. Damit sei es möglich, bis zu fünf Codec-Avatare auf einer Quest 2 zu rendern bei 50 Bildern pro Sekunde, schreibt UploadVR.

Laut Sheikh lässt sich unmöglich vorhersagen, wann die Avatartechnik produktreif wird. Auf dem Workshop sagte Sheikh, dass sie zu Beginn des Projekts "zehn Wunder entfernt" war von einer Vermarktung. Heute seien es "nur" noch fünf Wunder.

Spezial-Chip beschleunigt Codec-Avatare

RoadtoVR berichtete ebenfalls über Codec-Avatare und fasst ein aktuelles Paper aus dem April 2022 zusammen.

Eine Gruppe von Forscher:innen haben demnach einen spezialisierten KI-Chip designt, der die Berechnung von Codec-Avataren auf autarken VR-Brillen beschleunigt. Der nur 1,6 Quadratmillimeter große Chip wurde für das Avatarsystem optimiert und ist spezialisiert auf die Verarbeitung der Sensordaten. Umgekehrt wurde auch das KI-Modell für die Architektur des Chips überarbeitet.

Das Ergebnis dieser Optimierungen: Zum einen wird die Enkodierung der Codec-Avatare beschleunigt, zum anderen der Energieverbrauch sowie die Wärmeentwicklung reduziert. Der XR2-Chip hat ebenfalls zu tun und ist für die Dekodierung und das eigentliche Rendering der Avatare verantwortlich.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.