Autonomes Fahren: Verzerrt Tesla absichtlich die Berichterstattung?

Tesla fördert laut eines Berichts die Veröffentlichung von YouTube-Videos, die sich auf erfolgreiche Fahrmanöver der FSD Beta-Software fokussieren. Weshalb ist das gefährlich?

Tesla-Fahrer:innen mit Zugriff auf das Early Access-Programm der Full Self-Driving Beta-Software werden durch enge Auswahlkriterien und Veröffentlichungsrichtlinien durch den Konzern beeinflusst. So sollen vor allem YouTuber hauptsächlich Videomaterial veröffentlichen, das Teslas Autopilot beim Meistern von besonderen Fahrmanövern zeigt. Das legt ein Report von Motherboard nahe, der Technik-Sparte des Vice Magazins.

Tesla: Early Access-Zugang nur gegen Geheimhaltungsvereinbarung

Laut Motherboard schaffe Tesla durch diverse Richtlinien und undurchsichtige Auswahlkriterien eine wohlwollende Kultur von Marken-loyalen Beta-Tester:innen. Die würden sich vorrangig auf das Positive konzentrieren und Fehler des Systems lieber ausblenden. Schließlich sei gerade für Tesla-YouTuber der Erfolg der Marke wichtig für das eigene Bestehen.

___STEADY_PAYWALL___Tesla gewährt nur einigen wenigen Kunden Zugang zur Full Self-Driving Beta-Software. Einem anonymen Beta-Tester zufolge müsse jedes Mitglied des Early-Access-Programms (EAP) eine Vertraulichkeitsvereinbarung unterzeichnen. Sie verbiete es den Mitgliedern ausdrücklich, mit den Medien zu sprechen oder deren Vertretern Testfahrten zu ermöglichen. Mit der Presse spricht Tesla generell nicht mehr.

Tesla: Journalisten und Kritiker müssen draußen bleiben

Motherboard zitiert aus der von mehreren Beta-Tester:innen bestätigten Geheimhaltungsvereinbarung: „Denken Sie daran, dass es eine Menge Leute gibt, die Tesla scheitern sehen wollen; lassen Sie nicht zu, dass sie Ihr Feedback und Ihre Beiträge in den Medien falsch darstellen.“

EAP-Mitglieder würden außerdem ermutigt, „in den sozialen Medien verantwortungsbewusst und selektiv zu teilen“ sowie in Erwägung zu ziehen, „weniger Videos zu teilen und nur diejenigen, die sie für interessant oder Wert halten, geteilt zu werden.“

Dass viele Menschen Tesla gerne scheitern sehen würden, ist unter fanatischen Tesla-Befürworter:innen ein längst gängiges Narrativ. Durch medienkritische Äußerungen von Tesla-CEO Elon Musk, der Schließung der eigenen Pressestelle und Teilnahmebedingungen wie den oben genannten befeuert das Unternehmen diese Haltung weiter.

Vor allem in den sozialen Medien kursieren viele Theorien: Tesla-Kritiker:innen würden Aktien der Konkurrenz besitzen, für Ölfirmen arbeiten oder andere finanziell motivierte Interessen an der Verbreitung von Tesla-Falschinformationen haben.

Markenloyalität als Auswahlkriterium für Beta-Tester?

Tesla stellt Pressevertretern oder anderen unabhängigen Expert:innen also keinen Zugang zur Full Self-Driving Beta-Software zur Verfügung. Nur wenige auserwählte Kunden werden mit Zugang zum Early Access-Programm bedacht. Wie das unternehmensinterne Auswahlverfahren konkret aussieht, ist nicht bekannt. Ein transparenter Bewerbungsprozess existiert nicht.

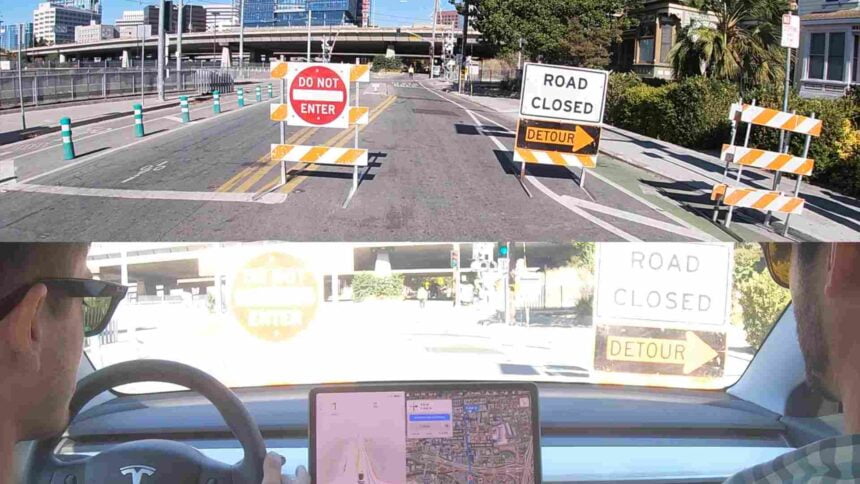

Diese Verkehrsschilder erkannte Teslas neue Full Self-Driving Beta 10 während der Fahrt eines Beta-Testers nicht. | Bild: AI Addict (YouTube)

Rafael Santoni, Beta-Tester und Betreiber des YouTube-Kanals „TesLatino“, gab in einem Interview an, die Hintergründe seiner Aufnahme in das Programm nicht genau zu kennen. Tesla sei auf ihn zugekommen. Er gehe davon aus, dass seine Aufnahme mit seinen Beziehungen zum Unternehmen und seiner Rolle als Tesla-Club-Präsident zu tun habe.

Laut Motherboard scheinen nahezu alle Beta-Tester in einer Form Interesse am Erfolg des Unternehmens zu haben. Sie seien Investoren, Affiliate-Partner, Fanclub-Vorsitzende oder hätten ihre Markentreue anderweitig öffentlichkeitswirksam unter Beweis gestellt.

Damit scheint Tesla selbst ein Ungleichgewicht in der Berichterstattung zu fördern. Kritische Stimmen der Medien werden aktiv verhindert, während positives Feedback von wohlwollenden Kunden belohnt wird.

Dass alle FSD-YouTuber ausschließlich positiv über Tesla berichten, ist dennoch fraglich. Unlängst zeigte ein YouTuber, wie unbeständig Teslas Full Self-Driving 10 Beta sein kann. In dem Video werden teils schwere Fahrfehler des Systems demonstriert.

Neues Auswahlsystem für Beta-Tester: Ein gefährliches Spiel um Punkte

Bislang scheint es keinerlei Kriterien im Hinblick auf die fachliche Eignung der Teilnehmer:innen zu geben. Seit dem 24. September wird zumindest das fahrerische Können miteinbezogen.

Um festzustellen, ob Fahrer:innen für die Testversion des Fahrassistenzsystems geeignet sind, werden persönliche Fahrdaten ausgewertet. Laut Tesla-Chef Musk sollen so künftig mehr Menschen Zugang zu den neuesten Updates der FSD-Beta-Version erhalten.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Wer für Full Self-Driving bezahlt hat, darf über den „Beta Request Button“ im Fahrzeug den Zugang beantragen. Anschließend wird für sieben Tage das persönliche Fahrverhalten aufgezeichnet. Wird der passende Safety Score innerhalb einer Skala von 0 bis 100 Punkten erreicht, erfolgt die Freischaltung.

Entscheidend für den Safety Score sind folgende fünf Kennzahlen:

- Warnungen vor Kollisionen pro 1000 Meilen (ca. 1.609 km)

- hartes Bremsen

- aggressives Abbiegen

- unsicheres Folgen

- Anzahl der Autopilot-Deaktivierungen wegen Nichtachtsamkeit

Es dauerte gerade einmal 48 Stunden, bis ein fragwürdiges Spiel um die Punkte entbrannte. Auf Twitter überbieten sich Menschen mit kreativen Ideen, wie sich der Score durch teils verantwortungslose Fahrmanöver maximieren ließe. Die geteilten Vorschläge reichen von harmlosen, ziellosen Fahrten um den Block bis zum Nicht-Bremsen für Radfahrer.

Careful out there, kids. There is a dangerous new game being played on our city streets. It's called: "Try to get the highest "Tesla Safety Score" without killing anyone." Don't forget to post your highest scores...$TSLA $TSLAQ pic.twitter.com/BvlOjiNwWH

— passthebeano (@passthebeano) September 26, 2021

Safety Score, Autopilot, Full Self-Driving: Irreführend und gefährlich

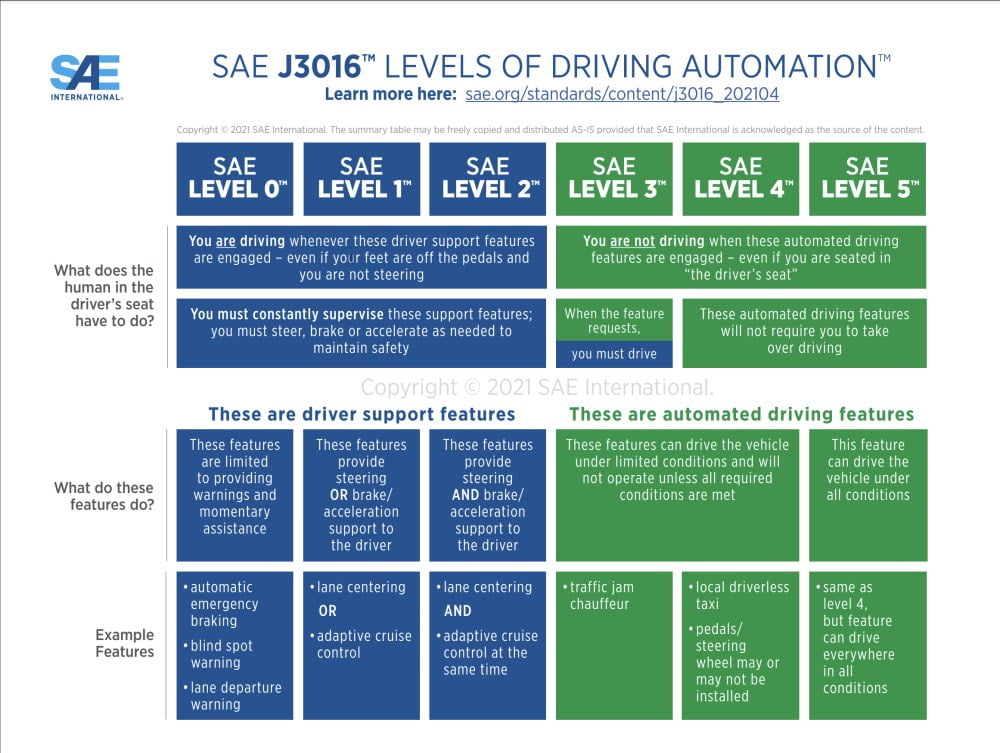

Tesla erntet schon für die irreführenden Namensgebungen „Autopilot“ und „Full Self-Driving“ von vielen Expert:innen Kritik. Beide Bezeichnungen suggerieren, dass ein entsprechend ausgestattetes Fahrzeug automatisch und ohne menschliches Zutun fahren kann.

Es gibt aktuell aber keinen Tesla, der tatsächlich selbstständig fährt. Autopilot ist lediglich ein Fahrassistenzsystem der Stufe 2 auf der SAE-Norm für autonomes Fahren. Menschen müssen stets die Hände am Lenkrad halten, den Blick auf die Straße richten und jederzeit eingreifen können.

Die neueste Fassung der SAE-Grafik zur Klassifizierung autonomer Fahrsysteme. | Bild: SAE International

Aktuell untersuchen US-Behörden über zwanzig Unfälle, die mit Teslas Autopilot und fahrlässiger Nutzung in Verbindung stehen. Einer davon war ein tödlicher Unfall, bei dem ein Tesla gegen einen Baum fuhr. Ersten Annahmen zufolge war zum Unfallzeitpunkt kein Fahrer hinter dem Lenkrad.

Mit dem Safety Score und der Rekrutierung von hauptsächlich loyalen Tester:innen tut sich das Unternehmen ein weiteres Mal keinen Gefallen. Während Googles Waymo, GMs Cruise, Amazons Zoox und andere Robo-Auto Start-ups großer Tech-Konzerne ausschließlich speziell ausgebildete Sicherheitsfahrer für ihre Testfahrten einsetzen, greift Tesla auf wohlwollende Laien zurück. Für Expert:innen ist das ein Sicherheitsrisiko.

NASA-Forscher: Menschen schätzen die Funktionsweise von autonomem Fahren falsch ein

Steve Casner, NASA-Forscher und Experte für die Interaktion zwischen Mensch und computergesteuerten Maschinen, sieht ein grundlegendes Defizit im Funktionsverständnis. Tesla und seine FSD-Tester sprechen häufig davon, dass Videos mit Fehlfahrten oft aus dem Kontext gerissen seien.

Gegenüber Motherboard erklärt Casner, dass Menschen anders über das computergestützte Autofahren denken müssten: KI-Systeme und Computer würden nicht wie Menschen „denken“ oder „lernen“. Casner mache deshalb die Art und Weise Sorgen, wie Tesla bei Fahrer:innen Vertrauen aufbaut.

Ein autonomes Fahrzeug sehe die Welt nicht wie der Mensch: „Wir Menschen verfügen über ein starkes und flexibles Verständnis der Welt mit unserem Verstand. Unsere Autos verfügen über nichts dergleichen. Sie kennen die Welt als Daten, die aus Videomaterial zusammengestellt wurden.“

Vor wenigen Monaten musterte Tesla das Radar aus und setzt seitdem ausschließlich auf Computer Vision. Laut Casner sei heutige Künstliche Intelligenz zwar in der Lage, die größten Schachmeister der Welt zu schlagen. Sie könne aber auch daran scheitern, ein blinkendes Feuerwehrauto zu sehen, das direkt vor ihr steht. Nur weil ein Tesla in manchen Situationen beeindruckende Fahrmanöver leiste, solle man dem System nicht blind vertrauen.

Weiterlesen über autonomes Fahren:

- Tesla, Nvidia, Waymo und Co. – wer dominiert autonomes Fahren?

- Autobahn der Zukunft: China baut Straße für autonomes Fahren

- Autonomes Fahren: Baidus Zukunftspläne für die Mobilität

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.