Deepfakes: KI-Forscher zeigen neue Möglichkeiten der Videomanipulation

Forscher der Carnegie Mellon University haben ein KI-Verfahren entwickelt, das die visuellen Eigenschaften eines Ursprungsvideos auf ein Zielvideo übertragen kann. Für Deepfaker tun sich damit ganz neue Möglichkeiten auf: Statt eines Gesichts könnten mit einem Klick ganze Bereiche eines Videos manipuliert werden.

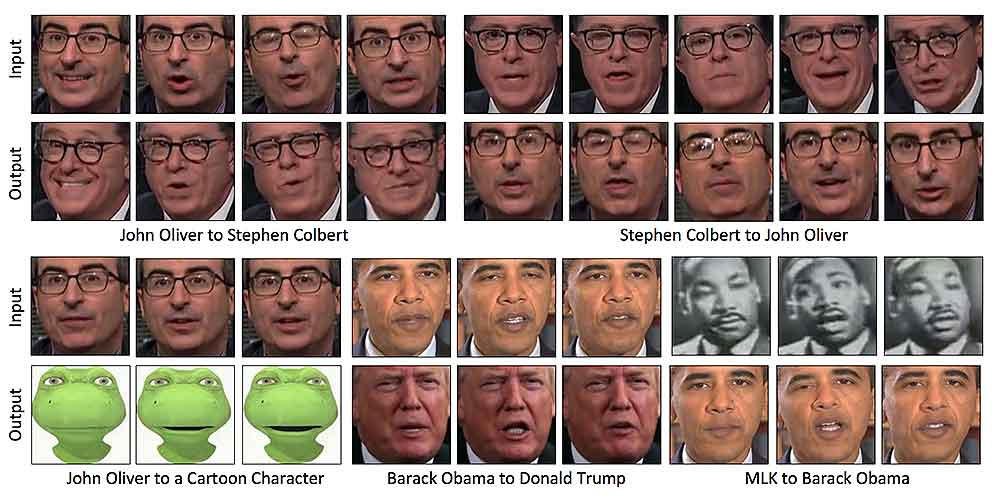

In einem Youtube-Video demonstrieren die Forscher, was die Software kann: In der linken Bildhälfte ist der US-Talkshow-Moderator John Oliver zu sehen, auf der rechten Seite sein Berufskollege Stephen Colbert.

Im rechten Video wurde die Mimik Olivers auf Colberts Mimik übertragen. Lächelt Oliver, so lächelt auch Colbert - auch wenn er in diesem Moment in Wirklichkeit gar nicht gelächelt hat.

___STEADY_PAYWALL___Mit dem gleichen Verfahren übertrugen die KI-Forscher Martin Luthers Mimik auf die von Barack Obama und die Mimik Barack Obamas auf die von Donald Trump. Die Methode ist nicht auf Gesichter beschränkt: Ein Hibiskus kann erblühen wie eine Narzisse, wenn man zwei passende Videos als Ausgangsmaterial nutzt.

Eine Abwandlung bestehender KI-Technik

Möglich wird diese KI-gestützte Videomanipulation durch ein GAN-Netzwerk (Generative Adversarial Network). Es besteht aus zwei konkurrierenden neuronalen Netzen: Eine Generator-KI übertragt die Eigenschaften eines Einzelbilds auf ein anderes, eine Diskriminator-KI bewertet das Ergebnis und verbessert so laufend die Leistung der Generator-KI.

Für die gezeigte Videomanipulation entwickelten die Forscher eine neue Art von GAN-Netzwerk, die neben Bildinformationen die zeitliche Achse berücksichtigt, also Veränderungen der Einzelbilder über einen bestimmten Zeitraum hinweg. Das Ergebnis nennen sie eine "Recycle-GAN".

Wer soll wie ausschauen? BILD: Bansal et al.

Videomanipulationen leicht gemacht

Die Technologie könnte den KI-Forscher zufolge in der Postproduktion von Filmen zum Einsatz kommen, um Bewegungen, Umgebungen oder Ausleuchtungen einer Szene unkompliziert auf eine andere zu übertragen.

Dass die Technologie für politische Zwecke missbraucht werden könnte, beispielsweise für Fake News Videos, ist den KI-Forschern bewusst: "Dass man solche Fakes produzieren und dass sie eine solche Wirkungen haben könnten, hat uns KI-Forschern die Augen geöffnet. Deshalb wird es wichtig sein, Verfahren zu entwickeln, die KI-Fakes aufspüren können", sagt Bansal gegenüber Techchrunch.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Bansal bezieht sich auf den Reddit-Nutzer Deepfakes, der die GAN-gestützte Videomanipulation Ende 2017 mit Fake-Pornos populär machte. Er nutzte die Technologie, um Gesichter von Pornodarstellerinnen durch jene berühmter Filmstars zu ersetzen.

Googles KI-Forscher Ian Goodfellow glaubt, dass mit den KI-Videomanipulationen eine neue mediale Ära anbricht, in der man Bildern und Videos grundsätzlich nicht mehr trauen kann. Waren glaubhafte Videofakes früher nur sehr schwer zu produzieren, ist die Erstellung mittels GAN-Netzwerken potenziell jedermann zugänglich: Mit spezialisierter Software reicht die Auswahl des Ausgangsmaterials und ein Mausklick.

Wer sich in die Funktionsweise der Recycle-GAN einlesen möchte, findet hier die wissenschaftliche Publikation.

Mehr lesen zum Thema:

- Deepfakes: Reddit löscht Fake-Pornos, doch der Zug ist abgefahren

- US-Firma will mit KI personalisierte Pornos verkaufen

- Neue Video-Manipulation lässt Deepfakes alt aussehen

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.