HyperReel: Meta zeigt Technologie für immersivere VR-Videos

Meta zeigt HyperReel, eine neue Methode, 6-DoF-Videos zu speichern und zu rendern. HyperReel könnte etwa in AR- und VR-Anwendungen zum Einsatz kommen.

180°- oder 360°-3D-Videos sind seit Jahren der bisherige Höhepunkt vieler Bemühungen, möglichst immersive Videos für die Virtuelle Realität zu produzieren. Zwar gibt es immer bessere Kameras und höhere Auflösungen.

Ein wichtiger Schritt ist aber noch nicht getan: Die Zukunft immersiver Videos liegt in sechs Freiheitsgraden (6-DoF), die es ermöglichen, neben der Blickrichtung auch die Kopfposition im Raum zu verändern.

___STEADY_PAYWALL___Erste Versuche, solche besonders immersiven Videos massentauglich zu machen, gab es bereits, etwa Googles Lightfields-Technologie oder Experimente mit volumetrischen Videos wie Sonys Joshua-Bell-Video.

In den vergangenen Jahren hat sich die Forschung verstärkt auf Methoden der "View Synthesis" konzentriert. Dabei handelt es sich um KI-Methoden, die neue Perspektiven in einer Umgebung rendern können. Neural Radiance Fields (NeRFs) sind ein Beispiel für eine solche Technik. Sie lernen 3D-Darstellungen von Objekten oder ganzen Szenen aus einem Video oder vielen Fotos.

6-DoF-Videos müssen schnell, qualitativ hochwertig und sparsam sein

Trotz zahlreicher Fortschritte gibt es bisher keine Methode, die qualitativ hochwertige Darstellungen ermöglicht, die gleichzeitig schnell gerendert werden und einen geringen Speicherbedarf haben. So kann auch mit aktuellen Methoden die Synthese eines einzigen Megapixel-Bildes nahezu eine Minute dauern.

Dynamische Szenen, die Beschränkungen der eigentlich sparsamen NeRF-Methoden umgehen, erfordern schnell Terabytes an Speicherplatz. Zusätzlich ist die Erfassung von Reflexionen und Lichtbrechungen eine große Herausforderung.

NeRFs repräsentieren 3D-Szenen in einem neuronalen Netz. Besonders herausfordernd sind dynamische Szenen, in denen sich etwa Menschen bewegen. | Bild: Song et al.

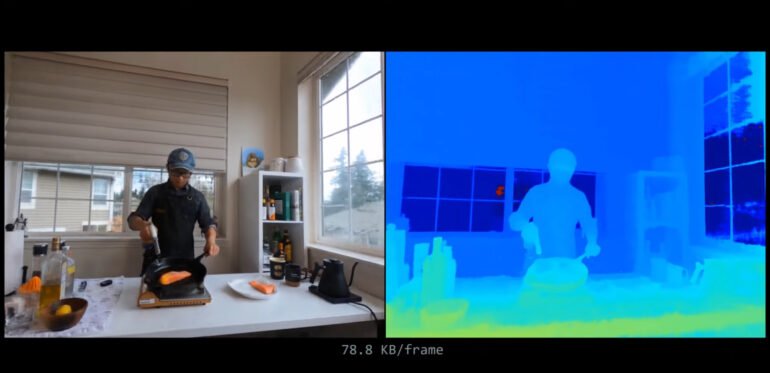

Forschende der Carnegie Mellon University, Reality Labs Research, Meta und der University of Maryland zeigen jetzt HyperReel, eine Methode, die speichereffizient ist und in Echtzeit mit hoher Auflösung gerendert werden kann.

Das Team setzt dafür auf ein neuronales Netz, das lernt, für jeden virtuellen Lichtstrahl aller möglichen Blickwinkel die Farbe vorherzusagen. Das Team setzt dabei auf die Vorhersage geometrischer Grundelemente in der Szene wie Ebenen oder Kugeln. Für HyperReel verwenden die Forschenden lediglich die Schnittpunkte der Strahlen mit diesen Grundelementen, statt der etwa in NeRFs üblichen hunderten Punkten auf dem Strahlenweg.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Zusätzlich verwendet das Team eine speichereffiziente Methode zur Darstellung dynamischer Szenen mit einer hohen Komprimierungsrate und eine Interpolation zwischen einzelnen Frames.

Metas HyperReel erreicht zwischen 6,5 und 29 Bildern pro Sekunde

Die Qualität der gezeigten dynamischen und statischen Szenen übertrifft die meisten anderen Ansätze. Das Team erreicht je nach Szene und Modellgröße zwischen 6,5 und 29 Bildern pro Sekunde auf einer Nvidia RTX 3090 GPU. Die 29 Bilder pro Sekunde sind aktuell jedoch nur mit dem Tiny-Modell möglich, das deutlich niedrigere Auflösungen rendert.

Video: Meta

Video: Meta

Anders als etwa NeRFPlayer taugt HyperReel jedoch nicht fürs Streaming. Laut Meta ist das kein Hindernis, da die Dateigröße gering ist: So benötigt NeRFPlayer etwa 17 Megabyte pro Bild, Googles Immersive Light Field Video 8,87 Megabyte pro Bild und HyperReel lediglich 1,2 Megabyte.

Für Echtzeit-Anwendungen in der virtuellen Realität, in der mindestens 72 Bilder pro Sekunde in Stereo gerendert werden müssen, ist HyperReel noch nicht geeignet. Da die Methode jedoch in PyTorch ohne weitere Optimierungen implementiert ist, könne in Zukunft mit technischem Mehraufwand eine erhebliche Geschwindigkeitssteigerung erzielt werden, so Meta.

Mehr Informationen, Beispiele und den Code gibt es auf GitHub.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.