So müssen VR-Hände sein: Entwickler zeigt glaubhafte Interaktionen

Ein Entwickler arbeitete zwei Jahre lang an einem Toolkit für Handinteraktionen. Das Ergebnis kann sich sehen lassen.

Handinteraktionen sind das A und O glaubhafter Virtual Reality. Was im echten Leben selbstverständlich erscheint, ist in der VR eine hochkomplexe Angelegenheit: Die virtuellen Hände müssen sich jedem Objekt anpassen und simulieren, wie und wo man virtuelle Gegenstände berührt, greift und aufhebt.

Ein solches System zu programmieren, ist eine Herkulesaufabe für sich. Weshalb Unity-Entwickler Earnest Robot sich daran machte, ein einsatzfertiges Toolkit für Entwickler:innen zu schaffen. Auf Reddit und Twitter zeigt er die Früchte seiner zweijährigen Bemühungen.

Auto Hand: Nutzerfreundlich und individualisierbar

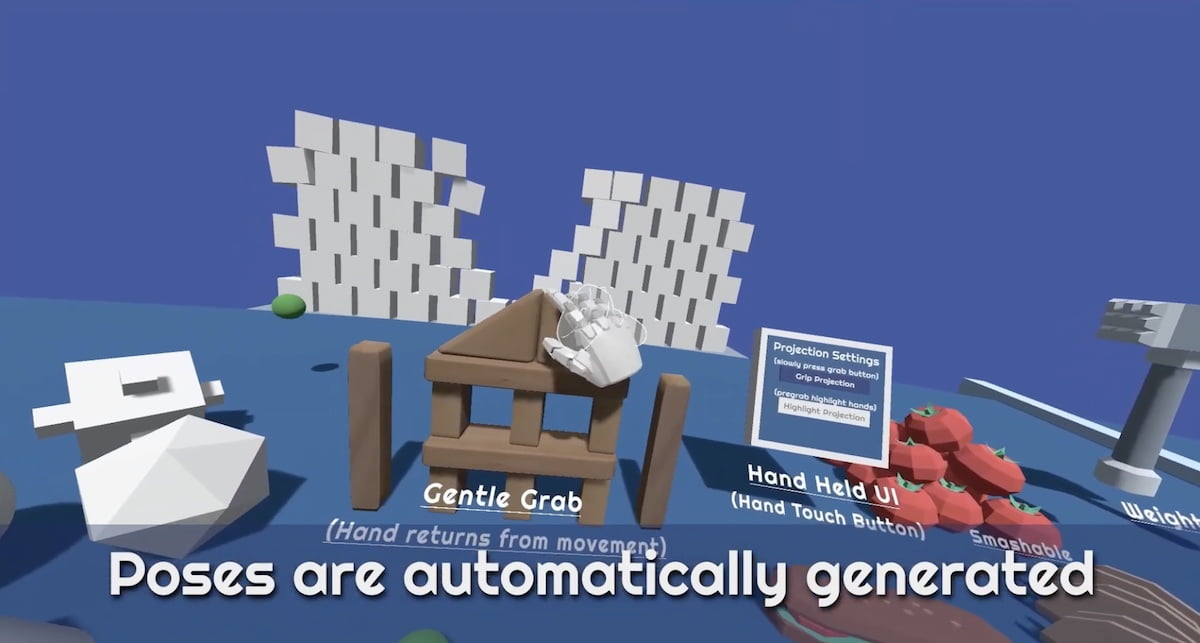

Auto Hand heißt das Unity-Toolkit, das automatisch Handposen generiert, je nachdem, wie und mit welchen Objekten man interagiert. Das Interaktionssystem simuliert Gewicht und Widerstand, zweihändiges Greifen, das Auseinanderziehen, Zerdrücken und Werfen von Objekten, Interaktionen mit Hebeln, Schiebereglern, Türen, Steuern und Knöpfen. Fortbewegung mittels Gesten ist ebenfalls inbegriffen.

Der Entwickler zeigt Handinteraktionen mit VR-Controllern, liefert jedoch eine Handtracking-Demo für Quest-Geräte mit. Entwickler:innen können das Interaktionssystem an ihre eigenen Bedürfnisse anpassen. Earnest Robot verspricht hohe und nutzerfreundliche Individualisierbarkeit bei geringem Leistungsbedarf.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Fortschritte bei Handinteraktionen

Glaubhafte Handinteraktionen dieser Art gab es schon. Besonders die VR-Spiele Lone Echo (2017) und Half-Life: Alyx (2020) setzten Maßstäbe, wurden aber von großen Teams entwickelt. Letzteres VR-Spiel habe ihn bei der Arbeit am Toolkit inspiriert, schreibt der Entwickler auf Reddit.

Im Bereich Handtracking machte der Schweizer Entwickler Dennys Kuhnert von sich reden. Seine VR-App Hand Physics Lab (Test) stellt die aktuelle Messlatte dar und funktioniert auch mit VR-Controllern. Mit seinem Start-up Holonautic gibt Kuhnert Handtracking-Kurse für XR-Industriegrößen.

Weil die Entwicklung manueller Interaktionen sehr zeitaufwendig ist, veröffentlichte Meta Anfang Februar ein ähnliches Toolkit, das sogenannte Interaction SDK, das Hände glaubhaft animiert, mit oder ohne VR-Controller. Earnest Robots Lösung wird dadurch nicht überflüssig: Zum einen können Entwickler:innen bei Bedarf Interaktionen beider Toolkits kombinieren, zum anderen ist Earnests Software nicht an Metas Ökosystem gebunden.

Auto Hand findet ihr im Unity Asset Store. Dort gibt es auch einen Link zu einer Demo. Eine Veröffentlichung im App Lab für Meta Quest (2) steht auf der To-Do-Liste des Entwicklers.

Weiterlesen über VR-Technik:

- Meta Quest 2: Neues PC-VR-Feature – Was es bringt & wie ihr es aktiviert

- Playstation VR 2: Sony patentiert mächtige Rendertechnik

- Microsoft Flight Simulator: Toolkit für Eye-Tracking entlastet die Grafikkarte

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.