NeRF-Player streamt dynamische volumetrische Szenen - auch für VR

NeRFs repräsentieren 3D-Szenen in einem neuronalen Netz. Eine neue Arbeit öffnet die KI-Technologie für dynamische Szenen.

Neural Radiance Fields (NeRFs) lernen aus Bildern 3D-Repräsentationen und können anschließend 3D-Szenen zum Beispiel aus vorher ungesehenen Blickwinkeln rendern. Das ermöglicht etwa eine 360-Grad-Kamerafahrt um ein Objekt, eine Tour per Drohnenaufnahme oder der Flug durch die Innenräume eines Restaurants. Die Technologie kann zudem genutzt werden, um fotorealistische 3D-Objekte zu generieren.

In nahezu allen Fällen handelt es sich jedoch um statische Szenen oder Objekte, da mit Bewegungen eine zeitliche Dimension in den Trainingsprozess einfließt, die bisher schwer zu lösen ist.

___STEADY_PAYWALL___NeRFs für dynamische Szenen

In einer neuen Forschungsarbeit zeigt ein Team der University at Buffalo, der ETH Zürich, InnoPeak Technology und der Universtiät Tübingen nun, wie NeRFs dynamische Szenen repräsentieren können und so eine 4D-Repräsentation lernen.

Als Input dienen RGB-Bilder verschiedener Kameras oder einer einzigen, sich bewegenden Kamera. In den Aufnahmen sind etwa sich bewegende Menschen zu sehen oder jemand schüttet Kaffee in ein Glas.

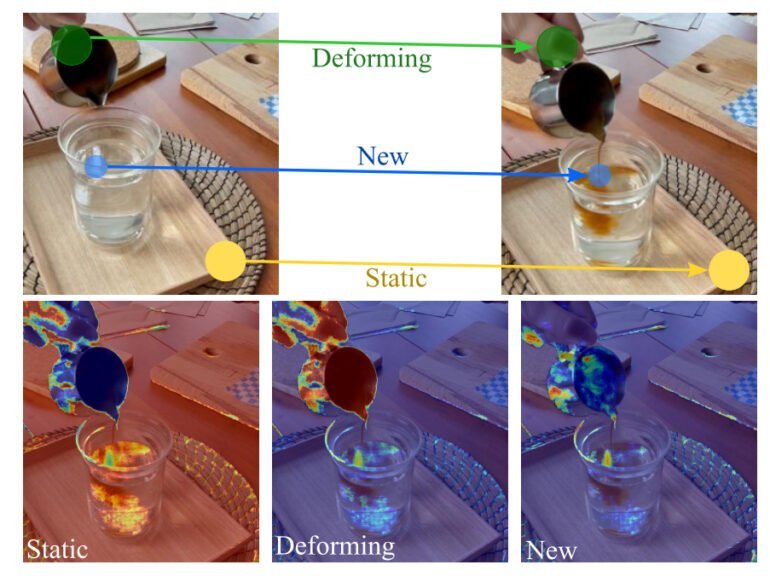

NeRFs können dynamische Szenen lernen. Dafür teilt ein sogenanntes Dekompositionsfeld die Szene in verschiedene Bereiche auf. | Bild: Song et al.

Um die Szene lernbar zu machen, teilt das Team dynamische Szenen in drei temporale Muster auf: statische, deformierende und neue Bereiche.

Im Falle des Kaffees bleibt etwa das Holzbrett statisch, auf dem das Glas steht. Der Inhalt des Glases erscheint neu und die sichtbare Hand deformiert sich. Ein Dekompositionsfeld übernimmt die Aufteilung der Szene in die drei Kategorien. Jeder Bereich wird von einem eigenen Neural Field repräsentiert.

Die Forschenden entkoppeln in ihrem Ansatz zudem temporale und räumliche Dimensionen, um die Repräsentation zu verbessern.

NeRFPlayer ermöglicht NeRF-Streaming

Die dekompositionale Repräsentation der dynamischen Szene reduziert visuelle Artefakte im Vergleich zu anderen Ansätzen deutlich. Das Team zeigt zudem mit NeRFPlayer eine Möglichkeit, die gelernten Repräsentationen mit begrenzten Bitraten in Echtzeit zu streamen.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Durch Nvidias Framework InstantNGP, mit dem ein neuronales Netz innerhalb von Sekunden Repräsentationen von Gigapixel-Bildern, 3D-Objekten und NeRFs lernen kann, ist die vorgestellte Methode zudem schnell.

Wir stellen einen Rahmen für die Darstellung dynamischer Szenen aus Bildern vor, die sowohl mit mehreren Kameras als auch mit einer Kamera aufgenommen wurden. Die wichtigsten Komponenten unseres Systems sind das Dekompositionsmodul und das Feature-Streaming-Modul. Das Dekompositionsmodul zerlegt die Szene in statische, deformierende und neue Bereiche. Anschließend wird eine hybride Darstellung entwickelt, um die zerlegten neuronalen Felder effizient zu modellieren. Experimente mit Multi- und Einzelkameradatensätzen validieren die Effizienz und Effektivität unserer Methode.

Auszug aus dem Paper

In der Arbeit bezeichnet das Team die visuelle Erkundung einer "realen 4D räumlich-zeitlichen Umgebung" für Virtual Reality als Vision und sieht die eigene Arbeit als Beitrag zu diesem Ziel.

"Die visuelle Erkundung eines realen 4D-Raums frei in VR ist eine langjährige Aufgabe. Die Aufgabe ist besonders reizvoll, wenn nur wenige oder sogar nur eine einzige RGB-Kamera für die Erfassung der dynamischen Szene verwendet wird", heißt es im Papier.

Die NeRF-Demonstrationen haben ihren Ursprung in einer Google-Forschungsarbeit aus 2020 zu räumlich gefilmten Lichtfeldvideos.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.