Magic-Leap-Analyse: Was verrät das Entwicklerkit über die AR-Brille?

Jetzt hat jeder Entwickler einen Einblick ins Magic-Leap-System. Gibt es etwas Neues zu entdecken? Augmented-Reality-Entwickler Tobias Kammann hat das SDK für VRODO auseinandergenommen.

Mit dem „Lumin“ getauften Software Developer Kit (SDK) können sich Entwickler endlich über Magic Leap aufschlauen, leider nur mit Brillen-Emulator statt echter AR-Brille. Entwickler können sich direkt mit Magic Leaps Betriebssystem Lumin OS verbinden oder aber komfortabler über gängige Game-Engines Anwendungen entwickeln.

Hier bietet Magic Leap Unterstützung für die Unreal Engine von Epic und Unity3D für Windows und MacOS. Hinzukommen Visual Studio-Plugins, verschiedene Optimierungs- und Kommandozeilenwerkzeuge wie ein Profiler und natürlich der Emulator, der sich zum Beispiel direkt mit einer neuen Magic Leap-Spezialversion von Unity austauscht und so das Testen erleichtert.

___STEADY_PAYWALL___Um unterschiedliche (reale) Umgebungen zu simulieren, legt Magic Leap noch einen VirtualRoomGenerator bei. Die Online-Dokumentation der Schnittstelle (API) scheint recht vollständig für den aktuellen Stand. Tutorials und Richtlinien sind noch schwer im Aufbau und unvollständig. Nach ein paar Stunden hat man alles verdaut und es bleibt nur noch, sich im Forum auszutauschen.

Bietet Magic Leap mehr als die Konkurrenz?

Ähnlich wie Microsofts Hololens bietet Magic Leaps Brille ein AR-Komplettpaket: Der Brillenträger braucht keine externen Kameras, keinen PC, ist kabellos unterwegs und kann die Welt um 3D-Elemente anreichern, die reale Welt vermessen und über Gesten mit dem System interagieren. Hinzu kommen Raumklang und natürlich WiFi.

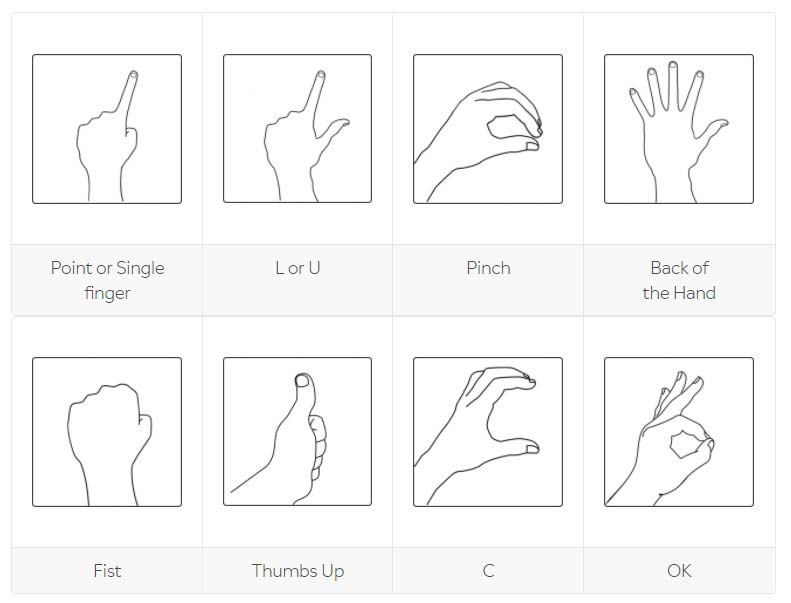

Magic Leap bietet laut Dokumentation für die Steuerung acht verschiedene Gesten (siehe Titelbild) für beide Hände. Dabei werden sogenannte „Keypoints“ der aktuellen Geste in Position und Orientierung (6 DOF) übermittelt. Die Hände müssen im Sichtfeld der Brille sein. Mit einer Geste hinter dem Rücken kann man das Gerät demnach nicht bedienen.

Zusätzlich werden Bitmapmasken für die Hände erstellt: Vermutlich lassen sich so Verdeckungen zwischen realen und virtuellen Objekten realisieren - die Beschreibung ist hier aber noch rudimentär. Von Sprachsteuerung wie mit Cortana auf der Hololens liest man leider nichts.

Bis zu vier Meter Projektionsfläche

Neue technische Spezifikationen sucht man in der Entwicklungsumgebung weitgehend vergeblich. Immerhin erfährt man etwas über den Minimalabstand eines digitalen Objekts zum Brillenträger: Es darf nicht näherkommen als 30 Zentimeter und nicht weiter entfernt sein als vier Meter, damit die glaubhafte Platzierung im Raum noch ordentlich klappt. Die maximale Projektionsentfernung liegt bei zehn Metern.

Wie groß das Sichtfeld sein wird, ist nicht dokumentiert. Bestätigt wird hingegen, dass sich das Lichtfeld-Display additiv verhält: Es wird nur Licht hinzugefügt. Die Farbe schwarz ist für virtuelle Objekte daher nicht möglich.

Zu so entscheidenden Themen wie dem natürlichen Fokuswechsel im Lichtfeld oder via Eye-Tracking erfährt man nichts. Es gibt lediglich ein Attribut namens „float focus distance“, das die aktuelle Fokusdistanz meinen könnte. Vielleicht ist nicht mehr dokumentiert, weil die komplette Abwicklung des Renderings mit Schärfe und Unschärfe automatisch passieren wird?

Das Eye-Tracking jedenfalls ist in der Schnittstelle definiert und man kann neben Blickrichtung und Augenposition sogar Blinzler beider Augen getrennt abfragen. Dadurch wird ein digitales Augenzwinkern möglich.

Tracking wie bei Hololens

Das Tracking funktioniert ähnlich wie bei den Konkurrenzbrillen Meta 2 und Hololens und setzt stark auf einen Datenmix der verbauten Kameras und Infrarotsensoren. Bei zu geringem Umgebungslicht oder Kontrast wechselt die Brille in einen 3-DOF-Fallback-Modus und erlaubt nur Kopfdrehungen, keine Bewegungen in die Tiefe des Raumes.

Das Scannen der realen Welt mit den verbauten Sensoren generiert wie bei Hololens ein Drahtgittermodell. Entwickler verwenden das für Kollisionen, Objektplatzierungen und Verdeckungen zwischen digitaler und realer Welt.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Magic Leap weist darauf hin, dass Updates dieses 3D-Modells „einige Sekunden“ dauern können und dass „mehrere Perspektiven“ benötigt werden. Ähnlich wie bei Googles ARCore und Apples ARKit werden flache Oberflächen schneller erkannt, beispielsweise eine Wand oder ein Fußboden.

Laut Magic Leap sollte die Umgebung für ein gutes Trackingergebnis möglichst statisch sein. Am gut besuchten Bahnhof oder ähnlich belebten Umgebungen dürfte die Brille demnach nicht verlässlich funktionieren.

Immerhin spendieren die Entwickler eine 2D-Bilderkennung, sodass man wie bei „klassischer“ Augmented Reality Fotos und Grafiken als Referenzmarker für Objektpositionierungen nutzen kann. Das reale Umgebungslicht lässt sich ebenfalls in Helligkeit und Farbtemperatur abfragen. Das soll helfen, die virtuellen Objekte visuell glaubhafter in die Umgebung einzubetten.

Leider enden die Tutorials direkt nach einem „Hallo Welt“-Beispiel, bei dem man einen Würfel in einem simulierten Wohnzimmer platziert. Somit erfährt man im Grunde sehr wenig über Magic Leap, was möglich sein wird oder wie man sich Magic Leap als Entwickler oder Content-Ersteller nähern sollte.

Der Emulator ist recht unhandlich, auch wenn man anscheinend alle Sensoreingabedaten der Brille simulieren kann. Der VirtualRoomGenerator zum Erstellen von Testräumen ist leider ebenfalls sehr rudimentär. Nicht einmal der Import eigener 3D-Modelle ist möglich.

Fazit

Da die Brille fehlt, kann man aus der Entwicklungsumgebung keine Aussagen über die AR-Qualität des finalen Produkts ableiten. Das SDK und die API-Dokumentation ermöglichen einen ersten Einblick für interessierte Entwickler, die sich schon mal einarbeiten möchten.

Beim aktuellen Stand würde die Brille etwas mehr bieten als die Konkurrenz - mehr Gesten mit Handmaskierung, eine 2D-Bilderkennung und Informationen zum Umgebungslicht - aber andere erhoffte Funktionen auslassen, wie eine Sprachsteuerung oder ein Objekttracking. Zu Lichtfeldern und verschiedenen Fokusebenen erfährt man nichts. Das ist alles noch recht unspektakulär.

Immerhin wird ein Kommandozeilenbefehl zur Verbindung zur Cloud gelistet („mldb cloudlogin“) - vielleicht ein erstes Anzeichen für eine angedachte Augmented-Reality-Cloud?

Anfang April sollen weitere Tutorials folgen und ich bin gespannt, wie Magic Leap mit der Community gemeinsam den Weg zum Spatial Computing beschreiten wird. Das Unternehmen spricht explizit davon, dass wir „alle gemeinsam noch lernen müssen, wie die Zukunft der Computer aussehen wird“.

Fragen beantworte ich gerne in den Kommentaren.

Über den Autor:

Tobias Kammann ist AR-Fan seit dem ersten AR-Toolkit und arbeitet seit mehr als zehn Jahren in der Industrie, um die Mixed Reality Wirklichkeit werden zu lassen. Zur Zeit bastelt er im Metaverso an seiner Vision, betreibt den Augmented-Blog und möchte am liebsten morgen schon alle Handys und Bildschirme aus dem Fenster werfen und durch eine AR-Brille ersetzen.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.