Wie die New York Times AR im Journalismus einsetzt

Mit diesen fünf Experimenten erforscht das Research & Development Team der New York Times immersives Storytelling.

2018 veröffentlichte die Times erstmalig Storys in Augmented Reality für mobile Endgeräte: Leser:innen konnten David Bowie’s einzigartigen Kleidungsstil in den eigenen vier Wänden bewundern oder die Mission von Apollo 11 in der Egoperspektive nacherleben.

Der Hardwaremarkt entwickelt sicher heute immer mehr auf Headsets hin, die sowohl Virtual Reality als auch eine Form von Augmented Reality beherrschen, etwa die Quest Pro. Daraus ergeben sich neue Möglichkeiten, Mixed Reality in den Alltag zu integrieren und sie etwa als regulären Teil von Journalismus zu begreifen.

Das Research & Development-Team der New York Times befasst sich schon seit einiger Zeit mit "Spatial Journalism", also räumlichem Journalismus. Wie kann eine Story in 3D räumlich skaliert werden? Kann eine Story in Echtzeit mit Nutzer:innen interagieren? Welche Mittel benötigen Journalist:innen, um diese Erfahrungen gut an die Leser:innen zu bringen?

Die New York Times will mit solchen Forschungen informative AR-Erfahrungen schaffen. Hierfür testete das R&D-Team bereits diverse Headsets auf deren Möglichkeiten in Bezug auf immersiven Journalismus, darunter Quest 2, HoloLens 2, Magic Leap 2 und Nreal Light.

Augmented Reality hilft, komplexe Themen zu erklären

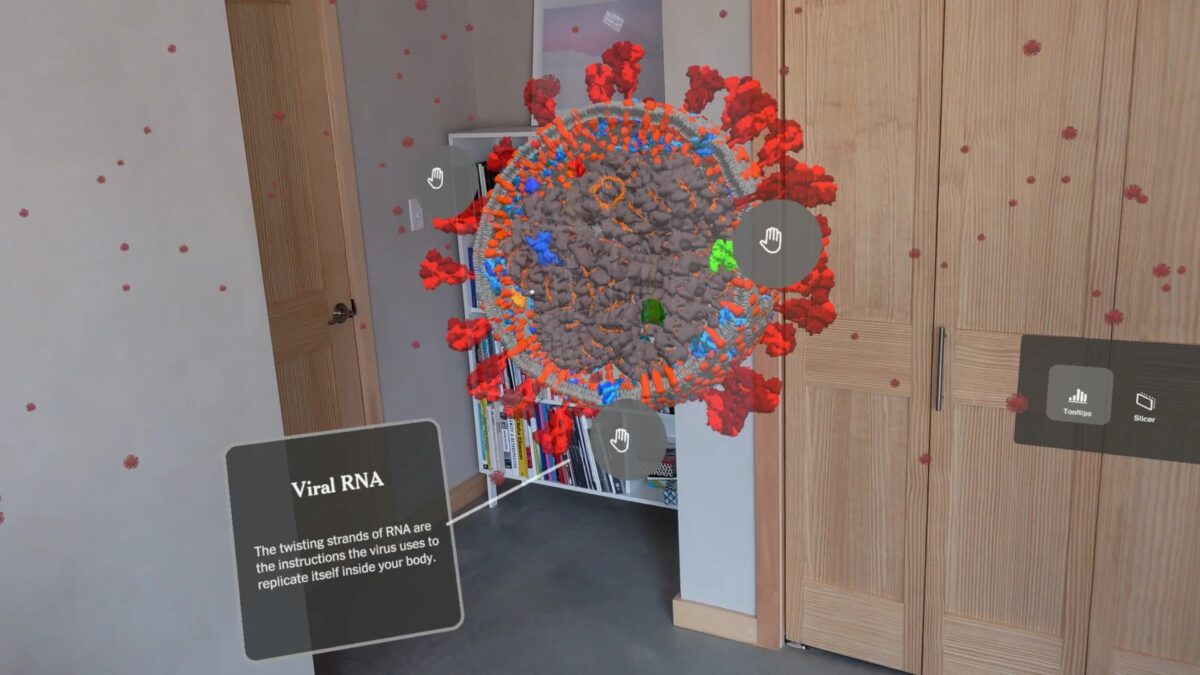

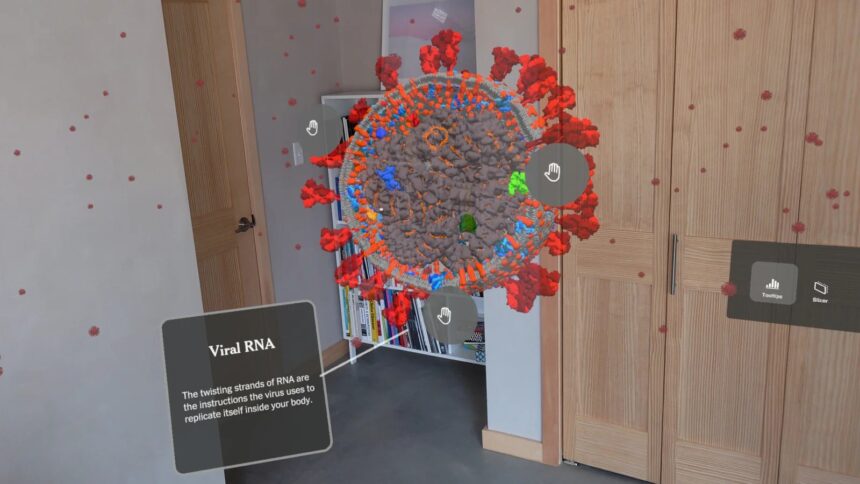

Im ersten Experiment können Leser:innen das 3D Modell eines Covid-19 Partikels vergrößern und verkleinern, sowie in Sektionen unterteilen. Eine Virenzelle in der Hand zu halten und sie skalieren zu können, verbessert das Verständnis für ein so kleines Teilchen. Textboxen erklären die Details.

Objekte in 3D untersuchen zu können, verbessert durch räumliche Nähe und Interaktion das Verständnis. | Bild: New York Times, Tim Clark

Das zweite Experiment demonstriert den Prozess eines Covid-19 PCR-Tests in fünf Schritten. Modelliert in Blender und animiert mit Unity wird ein solch komplexer Vorgang zu einem anschaulichen, greifbaren Prozess, der sich besser verstehen lässt. Hierbei kann das 3D-Modell beliebig im Raum verschoben und skaliert werden.

Im dritten Experiment wertet ein Algorithmus die Anzahl der Menschen im Blickfeld der Nutzer:innen in Echtzeit aus. In Relation zu dieser Zahl wird im Sichtfeld dargestellt, wie viele Pflegekräfte des Fachkräftemangels zu Coronazeiten verfügbar wären. Die individuelle Position und das direkte Umfeld der Leser:innen werden so in die Erfahrung eingebunden und zu einem interaktiven Erlebnis, ganz anders als es bei einem Zeitungsartikel der Fall wäre.

Druckwellen und Atempartikel-Verteilung im Raum

Das vierte Experiment demonstriert die Folgen des Tonga-Ausbruchs in zwei Varianten: Nutzende wechseln zwischen einer zweidimensionalen Karte und einem 3D-Globus und beobachten, wie sich die atmosphärische Druckwelle als rote Welle über die Kontinente ausbreitet. Hier erweist sich die Flexibilität von AR-Objekten als Vorteil: Die Visualisierung lässt sich nahtlos zwischen Weltkugel oder 2D-Karte wechseln.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Der Effekt des Tonga-Ausbruchs in AR: Die atmosphärische Druckwelle in der Visualisierung zeigt, wie massiv das Ereignis war. | Bild: New York Times, Alexandre Devaux

Das letzte Experiment ist ein interaktiver Artikel zum Thema Social Distance. Die Nutzer:innen werden im Zentrum einer Mini-Map positioniert, zusammen mit 3D-Modellen von Personen, die unterschiedliche Abstände zu den Nutzenden haben, um Social Distance zu visualisieren.

Wenn die Nutzer:innen „Cough“ (deutsch: „Husten“) sagen, werden die Partikel als kleine Punkte dargestellt, die sich physikalisch korrekt in der Luft verteilen. Nutzer:innen können sich im Raum bewegen, um die Partikelverteilung in Echtzeit zu verfolgen und zu sehen, wie weit sie sich ausbreiten.

Chance für den Journalismus: Zusammenhänge durch AR besser verstehen

Komplexe Zusammenhänge sind nicht immer leicht zu erklären - schon gar nicht schriftlich. Deshalb setzen Journalist:innen oft auf Erklärvideos, animierte Grafiken und ähnliche Medien. Augmented Reality hat das Potenzial, diese Zusammenhänge ins direkte Lebensumfeld der Nutzenden zu bringen und durch clevere räumliche Darstellung sowie Interaktion erfahrbar und damit besser vermittelbar zu machen.

Die Darstellung der Verbreitung von Partikeln aus der Atemluft etwa ermöglicht es Rezipient:innen, eine unmittelbare und räumliche Vorstellung davon zu haben, was passiert, wenn man im öffentlichen Raum ohne die Befolgung von Hygieneregeln hustet.

Allerdings ist die Beschäftigung mit neuen Technologien in vielen Zeitungsverlagen derzeit kaum bis gar nicht vorhanden. Die digitale Transformation geht vielfach nur langsam voran und wenige große Redaktionen experimentieren mit immersiven Medien oder verstehen das große Potenzial. Nur 46 Prozent der befragten Verlage aus einer aktuellen Ergebung geben an, "innovative Technologien wie Big Data, Cloud, Künstliche Intelligenz und Virtual Reality" strategisch zu nutzen oder nutzen zu wollen.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.