Virtual Reality: Adobe-Software macht aus herkömmlichen 360-Videos Raumvideos

Mit einem neuen Algorithmus möchte Adobe im Nachhinein sechs Freiheitsgrade in 360-Videos rendern. Damit das Verfahren greift, muss die 360-Kamera im Raum bewegt werden.

Der größte Nachteil von 360-Videos ist die fehlende Bewegung im Raum. Das Bild klebt wie eine Fototapete an der Innenseite der Brille, allein die Kopfdrehung ist möglich. Zahlreiche Unternehmen haben diesen Missstand erkannt und entwickeln Kameras, die neben flachen Bildern auch räumliche Informationen aufzeichnen können.

Adobe wählt den umgekehrten Weg und forscht an einer Lösung, die die Raumdaten im Nachhinein in flache 360-Videos rendert. Eine teure und technologisch aufwendige Spezialkamera wäre dann nicht mehr nötig. Selbst Laien könnten 360-Videos drehen, in denen der Zuschauer die Perspektive frei wählen kann. Für das Format wäre das ein großer Schritt.

Adobes Leiter der Forschungsabteilung Gavin Miller geht davon aus, dass zukünftig keine speziellen Kameras für volumetrische Videos benötigt werden. Fortschrittliche Algorithmen aus der Computer Vision sollen die Berechnungen nachträglich vornehmen können. "Wenn es eine Spezialkamera gibt, ist das nett - wenn nicht, ist es nicht das Ende der Welt", sagt Miller der Webseite Variety.

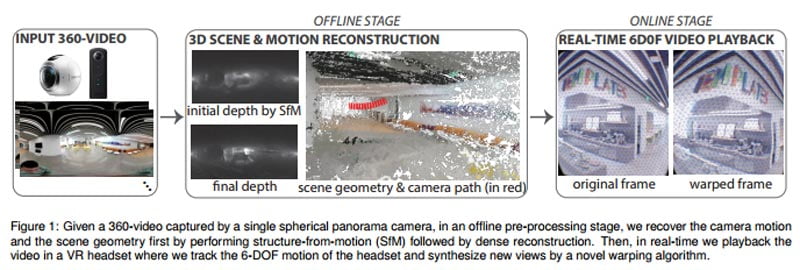

Die Infografik beschreibt das Verfahren. Bild: Adobe

Durchbruch dank Mathe

Wissenschaftler bei Adobe beschreiben, dass sie das aus der Photogrammetrie bekannte "Structure from Motion"-Verfahren ("Mehrbild-Photogrammetrie") für 360-Videos adaptieren konnten.

Auf Basis einer Serie von Einzelbildern können einem Video nachträglich Tiefeninformationen hinzugefügt werden. Ein Algorithmus erkennt wiederkehrende Merkmale in einer Szene und rekonstruiert anhand der perspektivischen Verschiebung dieser Merkmale von einem Bild zum nächsten den 3D-Raum in Form einer Punktewolke. Kombiniert man die Daten mit den herkömmlichen Bildaufnahmen, entsteht ein volumetrisches Video.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Die Adobe-Lösung hat einen Haken: Das Verfahren erfordert, dass die Kamera im Raum bewegt und die gleiche Szene aus mehreren Perspektiven gefilmt wird. Sonst fehlt der Software die Basis für Berechnungen.

Sind diese einmal erfolgt, können - so suggeriert es die Demo im Video unten - räumliche Standbilder berechnet werden. Das würde verhindern, dass dem VR-Brillenträger aufgrund der Kamerabewegung übel wird.

Völlig frei im Raum kann man sich jedoch nicht bewegen, dafür müsste die 360-Kamera sämtliche Objekte gleichzeitig aus allen Blickrichtungen erfassen und nicht nur frontal. Ohnehin dürfte das Verfahren schnell an Grenzen stoßen, wenn sich echte Menschen um die Kamera herumbewegen.

Die wissenschaftliche Publikation zum Forschungsprojekt ist hier einsehbar.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.