Google I/O 2018: ARCore 1.2, AR-Navigation in Google Maps und Objekterkennung

Auf der Keynote der I/O-Entwicklerkonferenz 2018 schwieg Google zu Virtual Reality. Dafür gab es Neuigkeiten zu ARCore, AR-Navigation in Google Maps und Objekterkennung mittels Google Lens.

Google stellte im Rahmen der I/O-Entwicklerkonferenz eine neue Version von ARCore vor: Mit ARCore 1.2 können mehrere Smartphone-Nutzer AR-Objekte im gleichen physischen Raum verankern, um beispielsweise eine Runde Luft-Tic-Tac-Toe zu spielen. Google nennt diese neue Funktion "Cloud Anchors".

Googles AR-App Just a Line, mit der Nutzer Striche in die Luft zeichnen können, wird in den kommenden Wochen Cloud Anchors unterstützen. Die Funktion soll mit iOS-Geräten kompatibel sein, sodass Android- und iOS-Nutzer an der gleichen AR-Erfahrung teilhaben können.

___STEADY_PAYWALL___Das neue ARCore erkennt jetzt außerdem vertikale Flächen, sodass zum Beispiel AR-Objekte an Wänden platziert werden können. Apples ARKit unterstützt diese Funktion seit Ende März. Auch bei der Bilderkennung zieht Google nach: Mit "Augmented Images" erkennt das Android-Gerät Bilder und ersetzt sie beispielsweise durch eine 3D-Animation (siehe Video unten).

Google vereinfacht außerdem die Entwicklung von AR-Inhalten. Entwickler können dank des neuen Sceneform-SDKs AR-Apps mit 3D-Objekten entwickeln, ohne sich mit Schnittstellen wie OpenGL auskennen zu müssen. Die neuen Funktionen stehen Entwicklern ab sofort zur Verfügung.

Visuelle Navigation für Google Maps

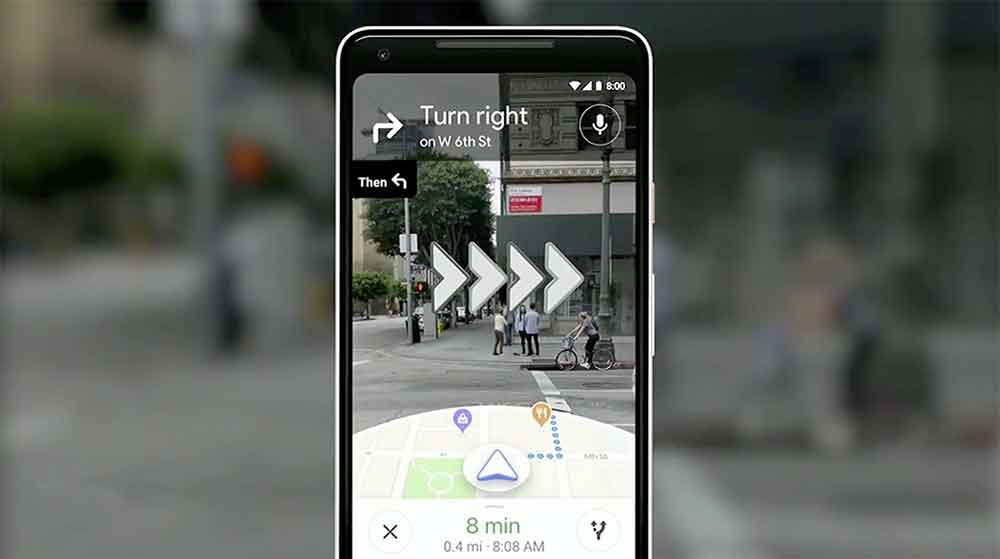

Auf der Keynote kündigte Googles VR-/AR-Produktmanagerin Aparna Chennapragada neue Funktionen für Google Maps an, die die visuelle Navigation mittels digitaler Einblendungen erleichtern sollen (siehe Video unten).

Um die Wegfindung zu verbessern, schaltet Google die Smartphone-Kamera hinzu. Nutzer sehen im unteren Drittel des Smartphone-Bildschirms die Karte und darüber einen um digitale Elemente erweiterten Bildausschnitt der realen Umgebung, der zum Beispiel anzeigt, wo Nutzer abbiegen müssen.

In der Nähe befindliche Lokale werden ebenfalls mittels digitaler Einblendungen hervorgehoben. Google experimentiert außerdem mit einem animierten Fuchs, der als 3D-Modell in den realen Raum projiziert wird und Nutzern den Weg zeigt.

Für die präzise Verortung des Nutzers im realen Raum greift Google auf das eigens entwickelte Navigationssystems VPS (Visual Positioning System) zurück, das Häuserfassaden analysiert und daraus die ungefähre Position und Orientierung des Nutzers errechnet. VPS wurde bereits auf der letztjährigen I/O-Konferenz vorgestellt, damals jedoch als hochpräzise In-Door-Alternative zu GPS vorgestellt, die Tango-Smartphones voraussetzt.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Google Lens: Neue Funktion für Objekterkennung

Chennapragada kündigte außerdem drei neue Funktionen für Googles Objekterkennungssoftware an, die in den kommenden Wochen ausgerollt werden (im Video unten ab 2:17:10).

Mit Smart Text Selection können Nutzer die Smartphone-Kamera auf Texte richten und diese markieren. Google Lens extrahiert und digitalisiert daraufhin den ausgewählten Text, sodass er abgespeichert oder geteilt werden kann. Die Software kann zudem Objekte wie Tischlampen und Kleidung analysieren und optische ähnliche Artikel vorschlagen.

Sometimes your question isn’t “what’s that exact thing?” but instead, “where can I see more like it?” So we’re rolling out style match, a new Lens feature that will help you look up visually similar clothing and furniture styles. #io18 pic.twitter.com/h4f9Qo6P5t

— Clay Bavor (@claybavor) 8. Mai 2018

Mit dem kommenden Lens-Update kommt außerdem Echtzeit-Objekterkennung. Mittels maschinellem Lernen erkennt die Software alle möglichen Objekte in Echtzeit und reichert sie mit Kontext aus dem Internet an.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.