Apple Vision Pro: Große Chancen für Innovationsprozesse

Die Chance von Apple Vision Pro liege nicht in der Hardware, sondern in der Integration in das Apple-Ökosystem, findet unser Gastautor.

Von Fabian Kreuzer

Für die Produktentwicklung ist schnelles Testen entscheidend für eine fundierte Bewertung. Besonders herausfordernd wird dies für Konzepte, deren Validierung in einer realen Umgebung oder im 3D-Bereich besser erfolgen kann. Im Produktdesign werden Konzepte bereits mithilfe von Virtual Reality (VR) beurteilt, doch dies ist oft mit erheblichem Mehraufwand verbunden.

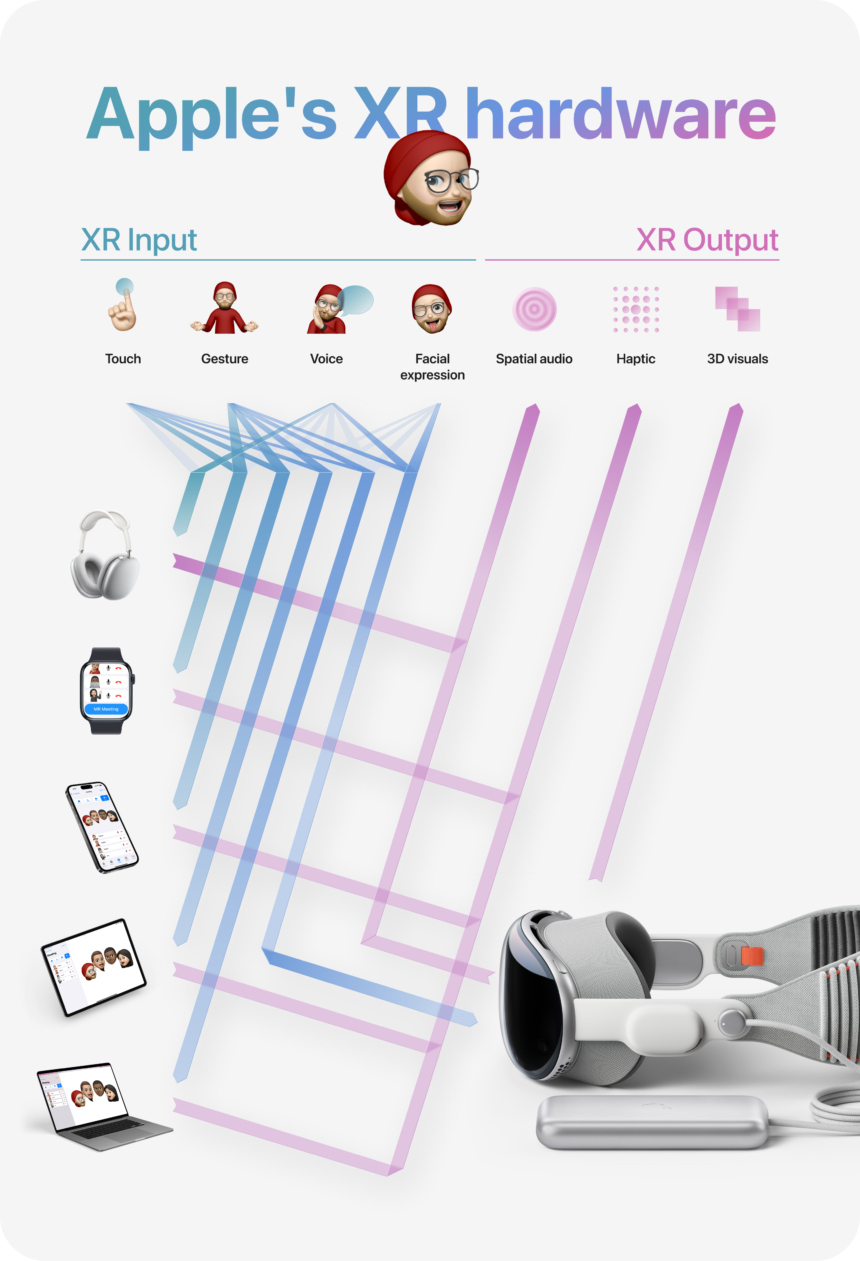

Die herausragende Chance von Apple Vision Pro liegt nicht in der erstklassigen Hardware, sondern vor allem in der nahtlosen Integration in das bestehende Apple-Ökosystem. Dadurch würde kein zusätzlicher Arbeitsaufwand beim Wechsel zu Spatial Computing entstehen, sondern der bestehende Arbeitsprozess würde lediglich um einige wenige Klicks erweitert.

Effizientes Testen von Embedded Interfaces mit Figma und Apple Vision Pro

Aktuell erfordert das Testen der Konzepte von Hardwareinterfaces im Produktkontext einen erheblichen Kosten- und Zeitaufwand. Bei der Entwicklung eines Touchinterfaces für eine Kaffeemaschine beispielsweise müssen das richtige Display, Elektronik und die Programmierung in den Prototypen integriert werden, um ein realistisches Setup für Nutzertests zu schaffen.

Diese Zusammenarbeit zwischen verschiedenen Disziplinen wie Modellbau, Elektronik, Programmierung und Design macht den Konzepttest zeitaufwendig und kostspielig.

Bild: Fabian Kreuzer

Durch das Zusammenspiel von macOS und visionOS könnte nun eine effiziente Möglichkeit entstehen, Figma- oder ProtoPie-Prototypen ohne zusätzlichen Aufwand am Produkt zu platzieren und zu testen. Dies würde den Innovationsprozess erheblich beschleunigen.

Interaktionskonzepte und Visualisierungen könnten in jeder Phase gemeinsam mit der Hardware entwickelt und getestet werden. Nutzertests könnten sowohl an Schaumstoffmodellen, 3D-gedruckten Prototypen als auch an seriennahen Produkten durchgeführt werden. Jegliche Displaygrößen und -formen könnten ohne zusätzlichen Aufwand getestet werden. Die Bestellung, Implementierung und Programmierung möglicher Displayvarianten würden bis nach der Evaluation aller Optionen entfallen. Dadurch würde sich ein erhebliches Innovationspotenzial für Branchen wie die Automobilindustrie, der Medizintechnik, der Unterhaltungselektronik sowie Haushaltsgeräte eröffnen, um Ideen schnell und kostengünstig zu validieren.

Bild: Fabian Kreuzer

Anhand dieses konkreten Beispiels wird deutlich, dass der Erfolg der Apple Vision Pro wahrscheinlich nicht durch eine neue App entstünde, sondern vielmehr durch die sinnvolle Erweiterung bereits existierender Produkte und Anwendungen mithilfe von Spatial Computing.

Durch die Symbiose von Vision Pro mit Produkten wie MacBook, iPad, Apple Pencil, iPhone & Apple Watch könnten sich bisherige Anwendungen wahrscheinlich sinnvoll erweitern lassen.

Mac

Bild: Fabian Kreuzer

Die Arbeitseffizienz würde mit Mac Virtual Display weder im Homeoffice, auf Businesstrips oder während Workation durch die geringe Größe des Bildschirms begrenzt sein. Es könnten zum Beispiel bestehende Applikationen frei um den Mac platziert werden, und zusätzlich könnte das Potenzial der dreidimensionalen Visualisierung voll ausgeschöpft werden. Per CAD Software könnten Produkte wie gewohnt konstruiert und gleichzeitig dreidimensional visualisiert und diskutiert werden.

Auch die Kombination bei der Produktentwicklung von Hardware- und Softwareprototypen würde neue und effiziente Möglichkeiten bieten, Konzepte zu testen. Interfaces könnten beispielsweise mit Figma gestaltet werden, und die Interaktion könnte direkt an Hardwareprototypen getestet werden.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

iPad

Bild: Fabian Kreuzer

Die Arbeit mit dem iPad in Mixed Reality würde ähnliche Vorteile bieten wie mit einem MacBook.

Zusätzlich würde das iPad eine größere Mobilität bieten, die Einbindung des Gyrosensors und weitere Interaktionsmöglichkeiten wie die Integration des Touchscreens oder des Apple Pencil.

iPhone

Bild: Fabian Kreuzer

Ein großer Vorteil beim Integrieren des iPhones in XR würde in der bereits erlernten, schnellen und einfachen iPhone-Interaktion liegen, und der Fakt, dass das iPhone der naheliegendste Zugang zu persönlichen Inhalten wäre, ohne neue Interaktionslogiken zu erlernen. Das iPhone-Interface würde den Funktionsumfang um XR-Funktionalitäten erweitern, sobald es durch die Vision Pro betrachtet würde.

Natürlich würden sich auch neue Möglichkeiten ergeben, indem das iPhone mit den vorhandenen Sensoren z.B. in Gaming-Anwendungen integriert werden würde.

Apple Watch

Bild: Fabian Kreuzer

Die Integration von Apple Watch in XR-Anwendungen würde vor allem die Möglichkeiten bieten, physische Belastungen und Bewegungen zu analysieren und die XR-Experience darauf anzupassen, um z. B. personalisierte Trainingsinhalte zu generieren.

AirPods

Bild: Fabian Kreuzer

Optimale XR-Anwendungen würden eine realistische Klangkulisse mit 3D-Audio benötigen. Daher läge es nah, die bestehenden Audiogeräte in die XR-Experience zu integrieren.

Über den Autor: Fabian Kreuzer ist freiberuflicher Interaction Designer und Experte für holistische, markenprägende und multisensorische User-Experience. Als Competence Lead Interaction Innovation und Design Lead hat er zahlreiche UX- und UI-Projekte für internationale Designagenturen und Kunden realisiert.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.