KI-Zauber: Meta generiert aus einzelnen Bildern 3D-VR-Umgebungen

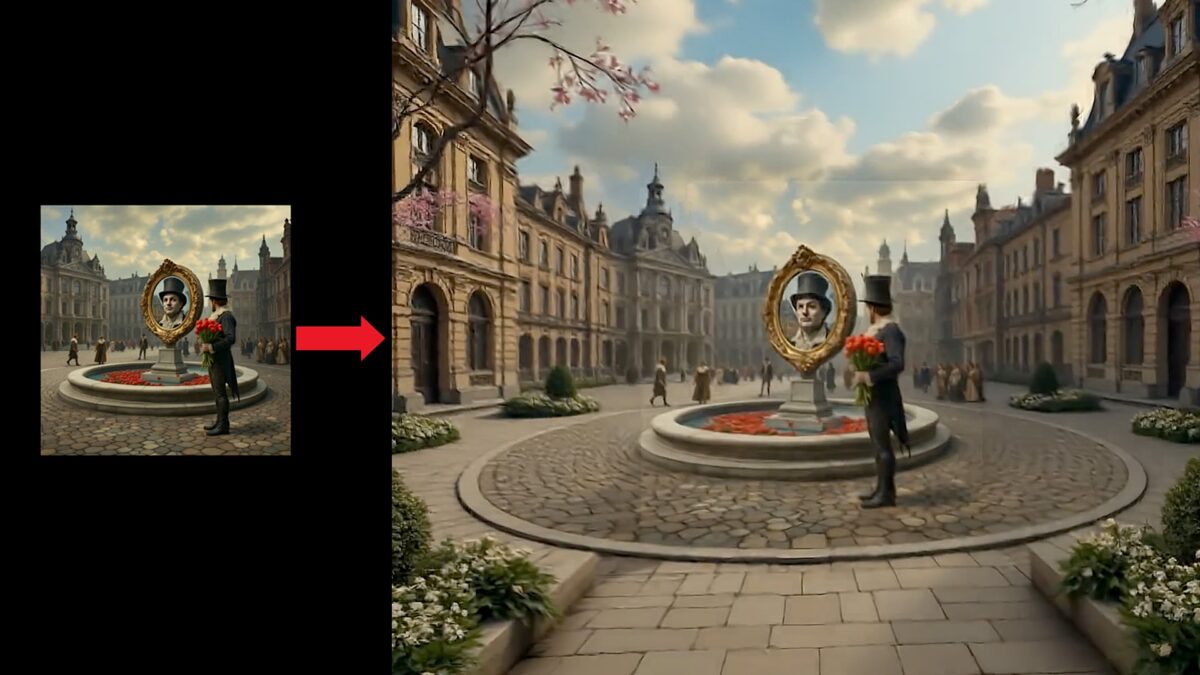

Ein KI-Modell erzeugt aus einem einzigen Bild lebensechte 3D-Umgebungen für VR-Brillen. Ein Meta-Forschungsteam zeigt beeindruckende Beispiele.

Stellt euch vor, ihr könnt am Beispiel eines einzigen Bilds eine 3D-Umgebung erstellen lassen und diese dann mit Meta Quest erkunden oder als Startumgebung nutzen.

Ein Forschungsteam der Meta Reality Labs in Zürich möchte diese Vision Wirklichkeit werden lassen und präsentiert einen neuen Ansatz zur KI-Generierung solcher Inhalte.

Bestehende Methoden können zwar Videos aus einem einzelnen Bild erstellen, hätten aber Schwierigkeiten, vollimmersve Szenen zu erzeugen, heißt es in dem vergangene Woche veröffentlichten Forschungspapier.

Die von den Forscher:innen entwickelte Pipeline soll die modernsten, auf Videosynthese basierenden Methoden in mehreren Qualitätsmerkmalen übertreffen, dabei nur minimales Training erfordern und auf Basis existierender generativer Modelle laufen.

"Unsere wichtigste Erkenntnis ist, dass die von Natur aus komplexe und mehrdeutige Aufgabe, eine 3D-Umgebung aus einem einzigen Bild zu generieren, in eine Reihe von besser handhabbaren Teilproblemen zerlegt werden kann, von denen jedes mit bestehenden Techniken gelöst werden kann", schreibt das Forschungsteam bestehend aus Katja Schwarz, Denis Rozumny, Samuel Rota Bulo, Lorenzo Porzi und Peter Kontschieder.

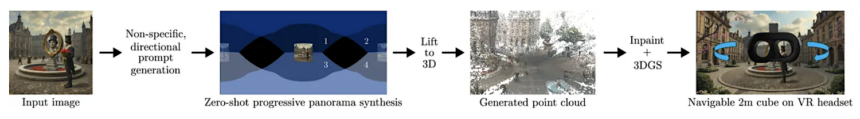

Aus einem Bild werden 6-DoF-VR-Umgebungen

Das Verfahren besteht aus mehreren Schritten. Zunächst werden mithilfe eines zuvor trainierten Diffusion-Modells kohärente 360-Grad-Panoramen generiert. Diese werden anschließend mithilfe eines metrischen Tiefenschätzers in 3D übertragen. In einem nächsten Schritt wird aus den 3D-Daten eine Point Cloud generiert. Ein sogenanntes Inpainting-Modell füllt anschließende fehlende Bereiche mit Informationen aus diesen Punktwolken auf und gewährleistet so Konsistenz.

Die einzelnen Schritte im Überblick. | Bild: Meta Reality Labs

Das Ergebnis ist eine mittels Gaussian Splatting dargestellte 3D-Umgebung, die innerhalb eines Würfels mit einer Seitenlänge von 2 Metern in VR erkundet werden kann.

Die Methode funktioniert sowohl mit künstlichem Bildmaterial als auch mit Fotografien. Selbst Textbeschreibungen einer Szene eignet sich als Input und erzeugen hochwertige 3D-Umgebungen, die sich für VR-Brillen eignen.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

In dem Forschungspaper werden auch einige Einschränkungen und Herausforderungen genannt. So sei es schwierig, den navigierbaren Bereich auf über zwei Meter auszuweiten, da die Komplexität der Aufgabe dadurch stark steige. Die Pipeline unterstützt zudem noch keine Echtzeit-Szenensynthese. Sobald jedoch die Gaussian-Splats-Umgebung erstellt ist, kann sie in Echtzeit auf einem VR-Gerät angezeigt werden, schreibt das Forschungsteam.

Wann die Technologie in Quest-Produkte einfließen könnte, ist nicht bekannt. Eine Vermarktung scheint jedoch nicht allzu fern. Weitere Videobeispiele findet ihr auf dieser Seite.

Was haltet ihr von diesen neuen Möglichkeiten? Diskutiert mit uns auf Instagram oder Facebook oder teilt eure Meinung in den Kommentaren.

Für Feedback, Themenvorschläge oder andere Ideen schickt uns bitte eine E-Mail an hallo@mixed.de oder hüpft auf unseren Discord-Server.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.