Dreamfusion: Google KI erstellt 3D-Modelle aus Text

Dreamfusion kombiniert Googles großes KI-Bildmodell Imagen mit den 3D-Fähigkeiten von NeRFs.

Dreamfusion ist die Weiterentwicklung von Dream Fields, einem generativen 3D-KI-System, das Google Ende 2021 vorstellte. Für Dream Fields kombinierte Google OpenAIs Bildanalyse-Modell CLIP mit der „Neural Radiance Fields (NeRF)“-Methode, mit der ein neuronales Netzwerk 3D-Modelle speichern kann.

Dream Fields nutzt die Fähigkeit von NeRF, 3D-Ansichten zu generieren und kombiniert sie mit CLIPs Fähigkeit, Inhalte von Bildern zu bewerten. Dreamfusion entwickelt diesen Ansatz weiter.

Imagen liefert Bildvorlagen für 3D-NeRFs

Dreamfusion basiert auf Googles vortrainiertem 2D-Text-Bild-Diffusionsmodell Imagen und ermöglicht die 3D-Synthese von Text. Für Dreamfusion ersetzt Google OpenAIs CLIP, das auch für die 3D-Erzeugung verwendet werden kann, durch ein auf der Grundlage von Imagen neu entwickeltes Bewertungsmodell. Es kann laut Google "viele neue Anwendungen für vortrainierte Diffusionsmodelle ermöglichen."

Für die 3D-Generierung ist daher kein Training mit 3D-Daten notwendig, die nicht im benötigten Umfang vorhanden wären. Stattdessen lernt Dreamfusion die 3D-Darstellung anhand von mit Imagen generierten 2D-Bildern eines Objekts aus verschiedenen Perspektiven. Das Forschungsteam verwendete dafür blickabhängige Prompts, die etwa "Vorderseite" oder "Rückseite" beinhalten. Der Prozess läuft automatisch ab.

Video: Google

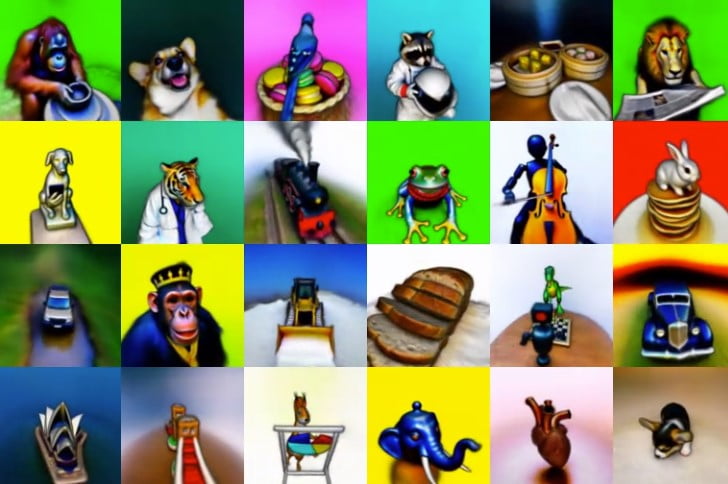

Im Vergleich zu Dream Fields generiert Dreamfusion aus einer Textaufforderung wiederbeleuchtbare 3D-Objekte in höherer Qualität, Tiefe und Normalen. Mehrere mit Dreamfusion generierten 3D-Modelle können zudem zu einer Szene vernäht werden.

MIXED.de ohne Werbebanner

Zugriff auf mehr als 9.000 Artikel

Kündigung jederzeit online möglich

Video: Google

"Unser Ansatz erfordert keine 3D-Trainingsdaten und keine Änderungen am Bilddiffusionsmodell, was die Effektivität von vortrainierten Bilddiffusionsmodellen als Priors demonstriert", schreibt Googles Forschungsteam.

Export in 3D-Tools möglich

Die generierten NeRF-Modelle können mit dem Marching-Cubes-Algorithmus in Meshes exportiert werden und dann in gängige 3D-Renderer oder Modellierungssoftware integriert werden.

"Wir freuen uns darauf, unsere Methoden mit Open-Source-Modellen zu verknüpfen und eine neue Zukunft für die 3D-Generierung zu ermöglichen", schreibt der beteiligte Google-Brain-Forscher Ben Poole bei Twitter.

Eine Übersicht mit generierten 3D-Modellen ist hier verfügbar.

Hinweis: Links auf Online-Shops in Artikeln können sogenannte Affiliate-Links sein. Wenn ihr über diesen Link einkauft, erhält MIXED.de vom Anbieter eine Provision. Für euch verändert sich der Preis nicht.