Eine mit Videos aus der Ich-Perspektive trainierte Künstliche Intelligenz könnte unsere Welt besser verstehen. Bei Meta kreuzt sich hier AR- und KI-Entwicklung.

Meta veröffentlicht im Vorfeld der Computer-Vision-Fachkonferenz CVPR 2022 das "Project Aria Pilot Dataset" mit mehr als sieben Stunden aus der Ich-Perspektive gefilmten Videos verteilt über 159 Sequenzen an fünf verschiedenen Orten in den USA. Sie zeigen Szenen aus dem Alltag - beim Abwasch, beim Öffnen einer Tür, beim Kochen, am Smartphone im Wohnzimmer.

KI-Training für den Alltag

KI-Forschende sollen mit diesen Daten Künstliche Intelligenz trainieren, die ein besseres Verständnis für den Alltag hat. Praktisch könnte so ein KI-System insbesondere visuelle Assistenzsysteme in einer AR-Brille aufwerten. Die KI erkennt mehr Elemente in der Umgebung und kann etwa beim Kochen Tipps geben.

Szenen aus dem Datensatz. | Video: Meta

Meta kündigte das Sammelprojekt für Videos aus der Ich-Perspektive im Oktober 2021 an und veröffentlichte damals bereits den Ego4D Datensatz mit mehr als 2200 Stunden Videomaterial aus der Ich-Perspektive.

„Stellen sie sich einen KI-Assistenten vor, der ihnen hilft, sich zu erinnern, wo sie ihre Schlüssel liegen gelassen haben, oder der ihnen das Gitarrespielen beibringt“, sagte der damalige Meta-CTO Mike Schroepfer bei der Vorstellung des Ego4D Datensatzes.

Project Aria liefert besonders umfangreiche Ego-Daten

Der aktuelle Datensatz, man erkennt es am Namen, wurde mit dem AR-Brillenprototyp "Project Aria" gesammelt. Das Gerät ist ein Sensor-Prototyp für zukünftige Highend-AR-Brillen, hat allerdings kein Display integriert.

Meta will mit Aria vornehmlich Daten für die Software-Entwicklung für hochwertige, zukünftige AR-Anwendungen sammeln und generell lernen, wie sich die Sensoren in der Brille im Alltag verhalten. Meta stellte Aria erstmals vor rund zwei Jahren vor.

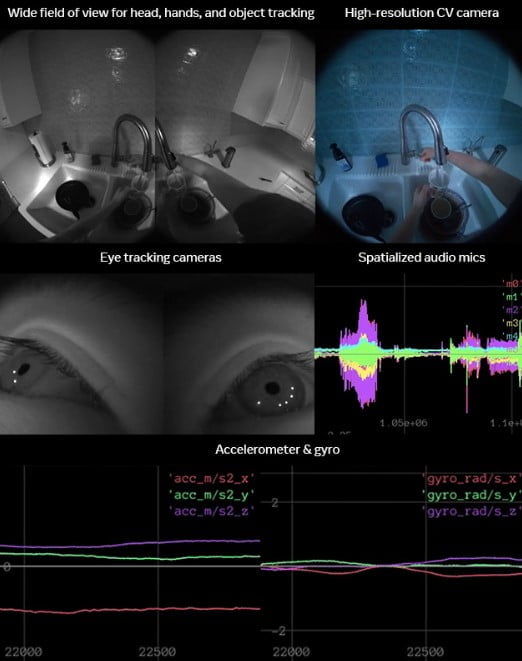

Aria sammelt neben den Videoaufnahmen zahlreiche weitere Daten, die den neuen Datensatz aufwerten: Neben einer Farb- und zwei Schwarzweißkameras hat die Brille Eye-Tracking, ein Barometer, ein Magnetometer, Raumklangmikrofone und GPS integriert.

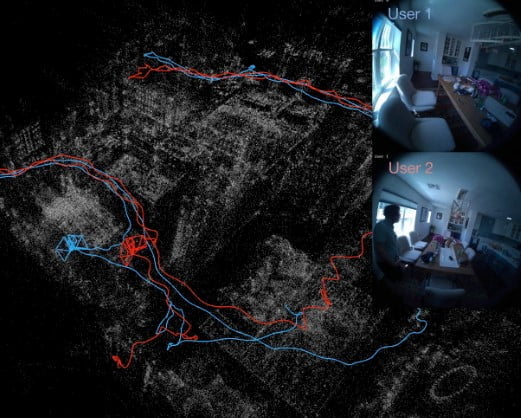

Meta liefert neben diesen Daten ergänzende Informationen über die Umgebung, etwa wie mehrere Brillenträger im gleichen Haushalt miteinander interagieren. Per Sprache-zu-Text-Protokollierung werden zudem Gespräche und Äußerungen der Brillenträger im Kontext visueller Ausdrücke auswertbar.

"Wir glauben, dass dieser Datensatz eine Grundlage für externe Forscher darstellt, um reproduzierbare Forschung zu egozentrischen Computer Vision und AI/ML Algorithmen für die Wahrnehmung, Rekonstruktion und das Verstehen von Szenen zu betreiben und zu fördern", schreibt Meta.

Zusätzlich zu den "Everyday Activities" ergänzt Meta den Datensatz mit "Desktop Activities": Die Firma installierte hier an einer Arbeitsplatte ergänzend ein Motion-Capture-System, um alltägliche Tätigkeiten wie Kochen noch genauer und aus verschiedenen Perspektiven aufzuzeichnen.

Weitere Informationen und eine Zugangsanfrage gibt es auf der offiziellen Webseite zum Aria Datensatz.