Forscher der Universität Oregon entwickeln eine Methode, die Entscheidungen von Deep-Learning-KIs transparenter machen könnte. Eine Aufmerksamkeitsanalyse gibt Hinweise auf deren Strategie.

Mit Deep Learning trainierte KIs erzielen im Vergleich zu herkömmlichen Statistikverfahren teils erstaunliche Ergebnisse, zum Beispiel bei der Bildanalyse oder maschinellen Übersetzungen.

Leider verrät so eine KI nicht, wie ihre Entscheidung zustande kommt. Bei einer Übersetzung ist das womöglich nicht so relevant, sofern das Ergebnis passt.

Doch wenn es zum Beispiel um automatisierte Kreditvergabe oder autonomes Fahren geht, sollten die Algorithmen ihren Entscheidungsprozess transparent machen. Sonst könnten Menschen den Eindruck gewinnen, dass sie einer maschinellen Willkür ausgeliefert sind.

Die Nachvollziehbarkeit ist wichtig für die ethische oder juristische Bewertung einer KI-Entscheidung. Außerdem könnte die KI-Weiterentwicklung schneller voranschreiten, wenn Forscher ihre Aussetzer besser verstehen.

Aufmerksamkeitsanalyse gibt Hinweis auf KI-Strategie

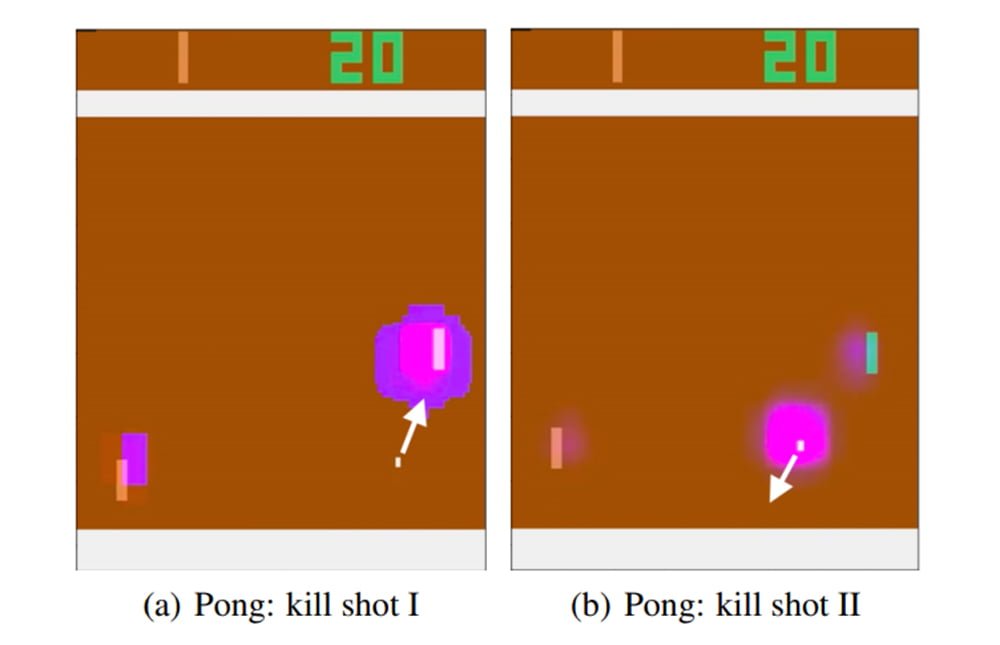

Forscher der Universität Oregon untersuchten nun, wie eine Künstliche Intelligenz während eines Entscheidungsprozesses ihre Aufmerksamkeit verteilt. Sie trainierten eine KI für verschiedene Spiele auf der Klassikkonsole Atari 2600.

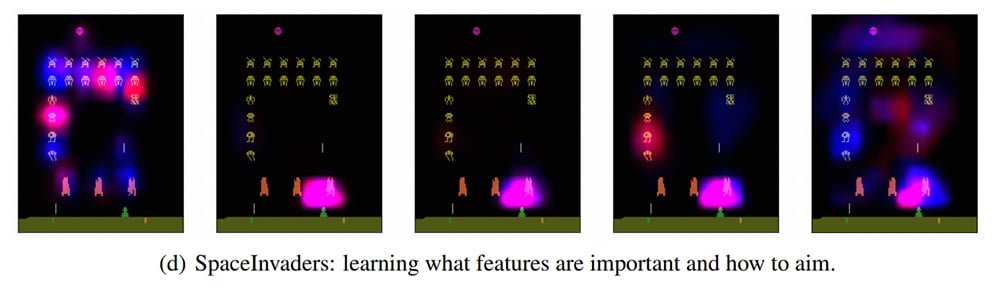

Während die KI die Spiele spielte, prüften die Forscher, auf welchen Pixelbereich sie ihre Aufmerksamkeit richtet. So konnten sie erkennen, wo die KI während des Spiels „hinschaut“ - und daraus ihre mögliche Strategie ableiten. Die Strategie wiederum ist die Grundlage für Entscheidungen.

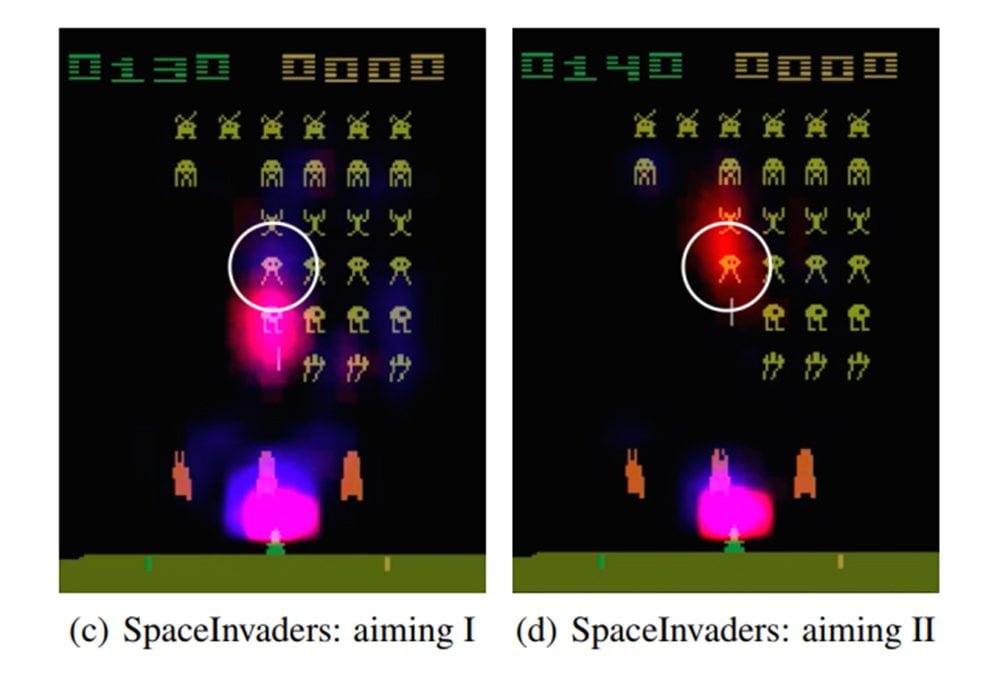

Im Klassikspiel „Space Invaders“ war beispielsweise unklar, ob die KI auf einzelne Gegner oder ganze Gegnergruppen feuert. Die Aufmerksamkeitsvisualisierung zeigt: Die KI zielt tatsächlich auf einzelne Gegner und hält dabei immer die Zone über dem eigenen Schiff im Auge – vermutlich, um sich gegen gegnerische Attacken schützen.

Die Visualisierungsmethode eignet sich für alte Atari-Spiele. Doch was ist mit anderen, komplexeren Szenarien?

Die Forscher schlagen vor, dass ihr Aufmerksamkeitsansatz mit anderen verfügbaren und zukünftigen Methoden kombiniert wird, um KI-Transparenz im größeren Maßstab zu realisieren.