In einem neuen Wettbewerb treten KIs in Minecraft gegeneinander an. Ihr Ziel: Diamanten. Doch die bekommen sie nicht einfach so.

In Videospielen testen KI-Forscher den Fortschritt ihrer cleveren Software: Atari-Klassiker sind schon lange Spielfeld für KIs und in den letzten Monaten beweisen sie sich auch in modernen Strategiespielen wie Dota und Starcraft.

Nun gibt es mit dem KI-Wettbewerb "MineRL" eine neue Herausforderung: KIs sollen in Minecraft einen Diamanten ausgraben - und zwar möglichst effizient.

Teilnehmer des Wettbewerbs sollen auf eine Kombination aus bestärkendem und imitierendem Lernen setzen. Bestärkendes Lernen steht hinter einer ganzen Reihe von KI-Meilensteinen wie Deepminds Alpha Zero oder Alphastar. Die KI bekommt eine Aufgabe und wird belohnt (bestärkt), wenn eine Aktion näher an die Lösung führt.

Doch diese KIs wurden mit enorm hohem Rechenaufwand trainiert. Ein Beispiel: Alphastar spielte etwa 200 virtuelle Jahre Starcraft, OpenAIs Dota-KI Five sogar 45.000 virtuelle Jahre in zehn realen Monaten.

Bestärkendes Lernen allein reicht nicht aus

Die Macher des MineRL-Wettbewerbs sehen diesen enormen Trainingsaufwand kritisch. Denn nur ein kleiner Teil KI-Forscher habe entsprechende Rechenkapazitäten zur Verfügung.

Hinzu käme, dass Fortschritte in vielen Echtweltanwendungen wie dem autonomen Fahren durch den hohen Bedarf an unzähligen – und möglicherweise nutzlosen – Trainingsstunden behindert würden.

Die Forscher setzen daher auf eine Kombination aus bestärkendem und imitierendem Lernen: Die KI nimmt sich ein Kind als Vorbild, das von seinen Eltern lernt.

Für alle Teilnehmer des Wettbewerbs stellen die Forscher dafür eine umfassende Sammlung Gameplay-Videos menschlicher Minecraft-Spieler bereit. Von diesen soll die KI lernen.

Hierarchien und Geklöppel

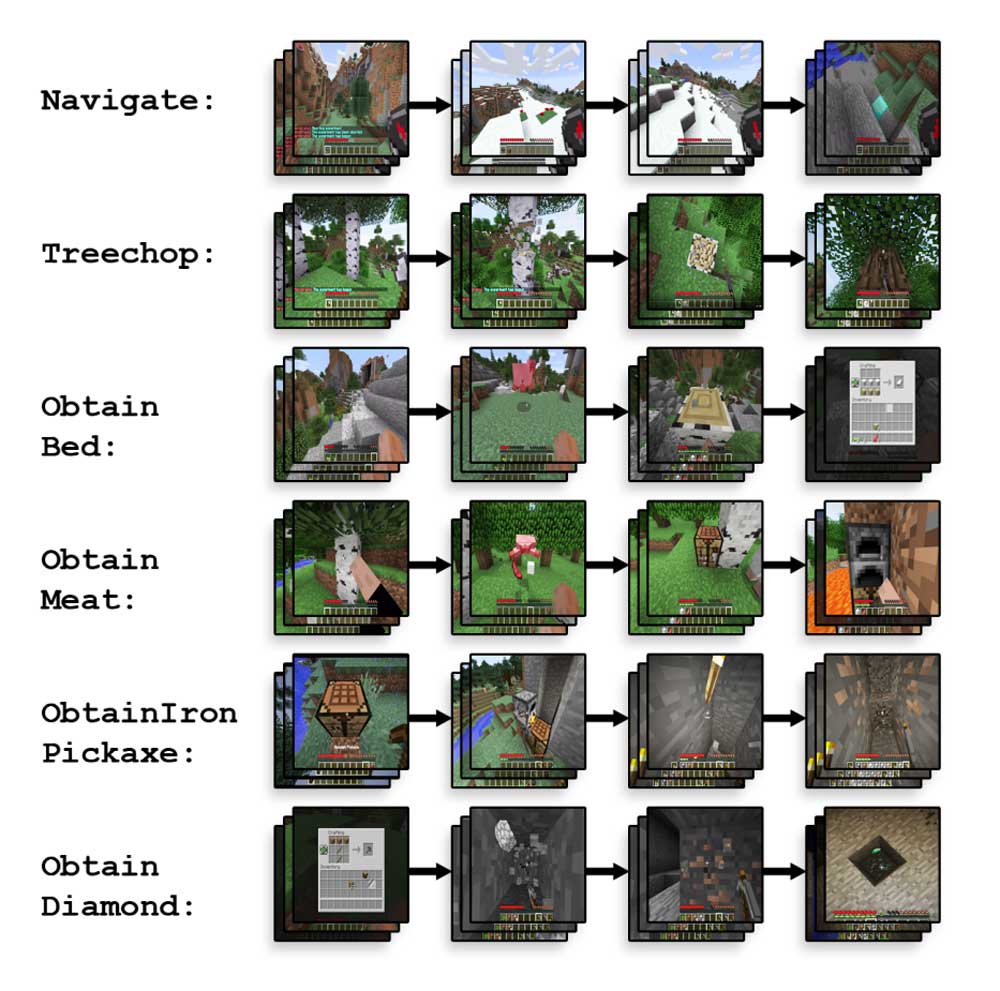

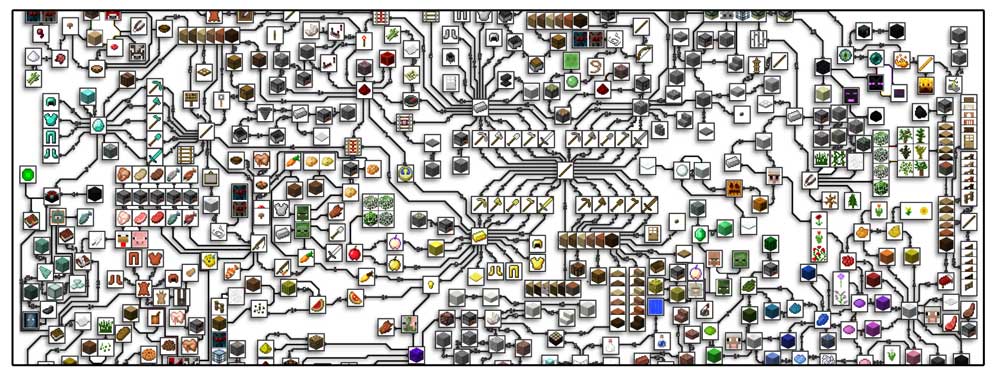

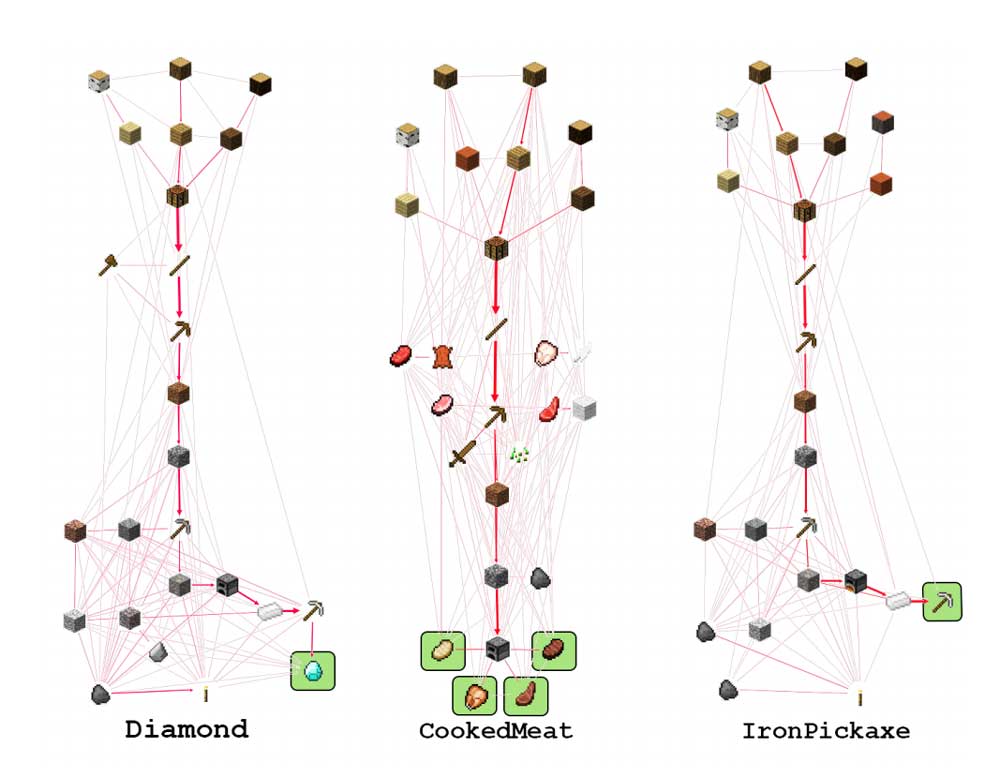

Im Spiel muss die KI sechs Aufgaben lösen: navigieren, sich Holz, Bett, Fleisch und Spitzhacke besorgen und am Ende einen Diamanten ausbuddeln. Diese Aufgaben bauen aufeinander auf: ohne Holz keine Spitzhacke, ohne Hacke kein Diamant.

Das Ziel ist eine KI, die mit wenig Rechenaufwand anhand eines menschlichen Vorbilds komplexe Aufgaben lösen kann (imitierendes Lernen), ohne auf permanente Belohnung für kleine Zwischenschritte angewiesen zu sein (bestärkendes Lernen).

Der MineRL-Wettbewerb startet am 01. Juni. Ende Oktober soll ein Gewinner feststehen.

Titelbild: Guss et al., Quelle: Arxiv