OpenAIs multimodales KI-Modell CLIP zeigt in einem Experiment, dass es rund und eckig ähnlich "hört" wie Menschen. Was hat es mit dem Bouba/Kiki-Effekt auf sich?

Die Lautsymbolik oder auch Phonosemantik untersucht das Verhältnis zwischen Geräuschen und Bedeutung der menschlichen Sprache. Es vertritt, vereinfacht beschrieben, die Theorie, dass der Klang von Wörtern und ihre Bedeutung verknüpft sind. Die Idee taucht schon in Schriften der antiken Griechen auf und wird noch heute in der Sprach- und Neurowissenschaft untersucht.

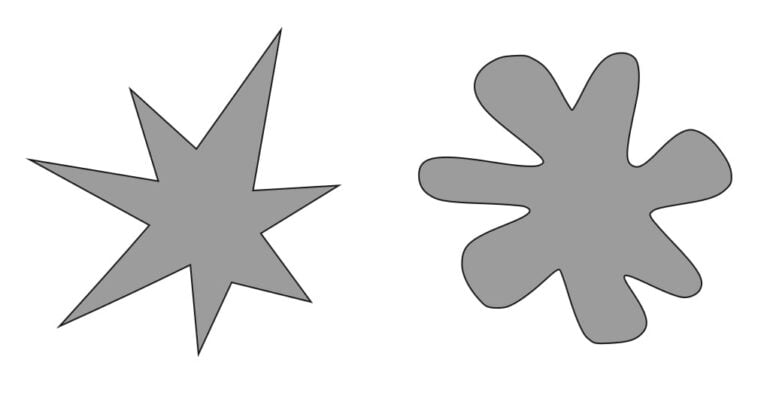

So konnten Forscher etwa zeigen, dass Menschen für bestimmte Formen bestimmte Ausdrücke bevorzugen. Prominentes Beispiel dafür ist der sogenannte Bouba/Kiki-Effekt: Versuchspersonen müssen dabei einem Objekt mit Zacken und einem Objekt mit abgerundeten Ecken einen Namen zuordnen – „Bouba“ und „Kiki“.

In einigen Fällen wählen bis zu 90 Prozent der Versuchspersonen Kiki für das eckige Objekt und Bouba für das runde.

OpenAIs CLIP repräsentiert abstrakte Konzepte

Anfang Januar veröffentlichte OpenAI das mit Texten und Bildern trainierte mulitmodale CLIP-Modell. Eine Untersuchung von OpenAI zeigte im März, dass CLIP zahlreiche abstrakte Konzepte repräsentiert.

CLIP wird seitdem vermehrt in Kombination mit anderen KI-Systemen für die Bildgenerierung genutzt. Ein KI-Forscher generierte damit ein surreales Musikvideo über Wiesel, ein anderes Team nutzt es für Bildgenerierung ohne zusätzliche Trainingsdaten, ich erzeugte mit CLIP surreale Motive von Gaming-Helden allein per Texteingabe.

Ein Twitter-Nutzer hat nun gezeigt, dass sich die Lautsymbolik wohl auch in großen KI-Modellen wie OpenAIs CLIP findet. NearCyan befasst sich schon länger mit KI-Experimenten, er betreibt seit Anfang 2021 die Webseite „This Anime Does Not Exist“.

Er vermutete, dass sich in CLIP der Bouba/Kiki-Effekt zeigen lässt, da das Modell Wörter häufig in kleineren Bruchstücken verarbeitet und so die lautsymbolischen Eigenschaften der englischen Sprache repräsentieren könnte.

Bouba/Kiki-Effekt lässt sich in CLIP reproduzieren

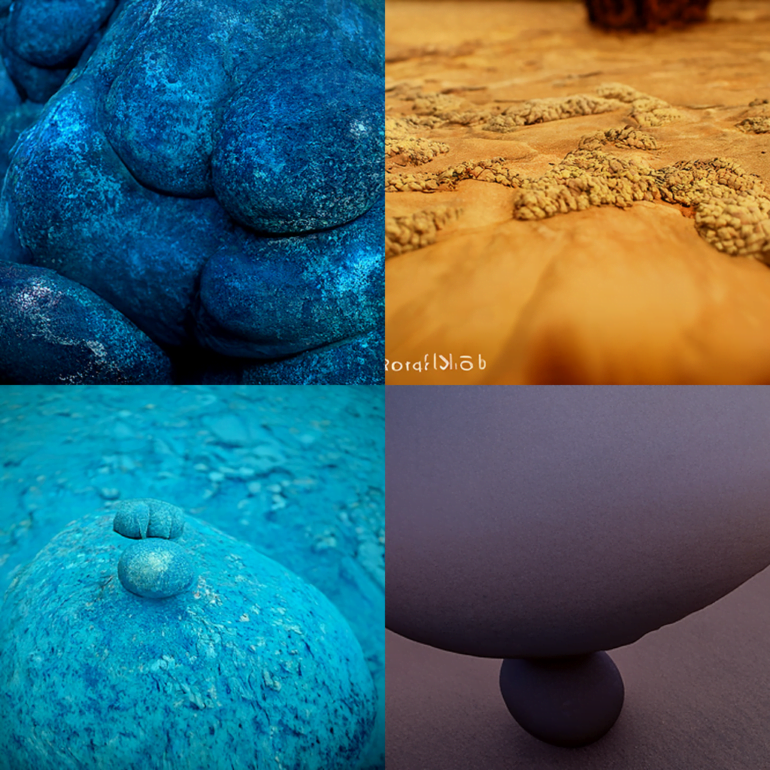

NearCyan nutzte zwei verbreitete Methoden für die KI-Bildgenerierung: CLIP+VQGAN und CLIP-guided diffusion. Mit dem Textbefehl „an image of“ ließ er die Modelle Bilder für die Laute Bouba und Kiki generieren. Der Anhang „| trending on artstation | unreal engine“ erzeugt qualitativ bessere Bilder.

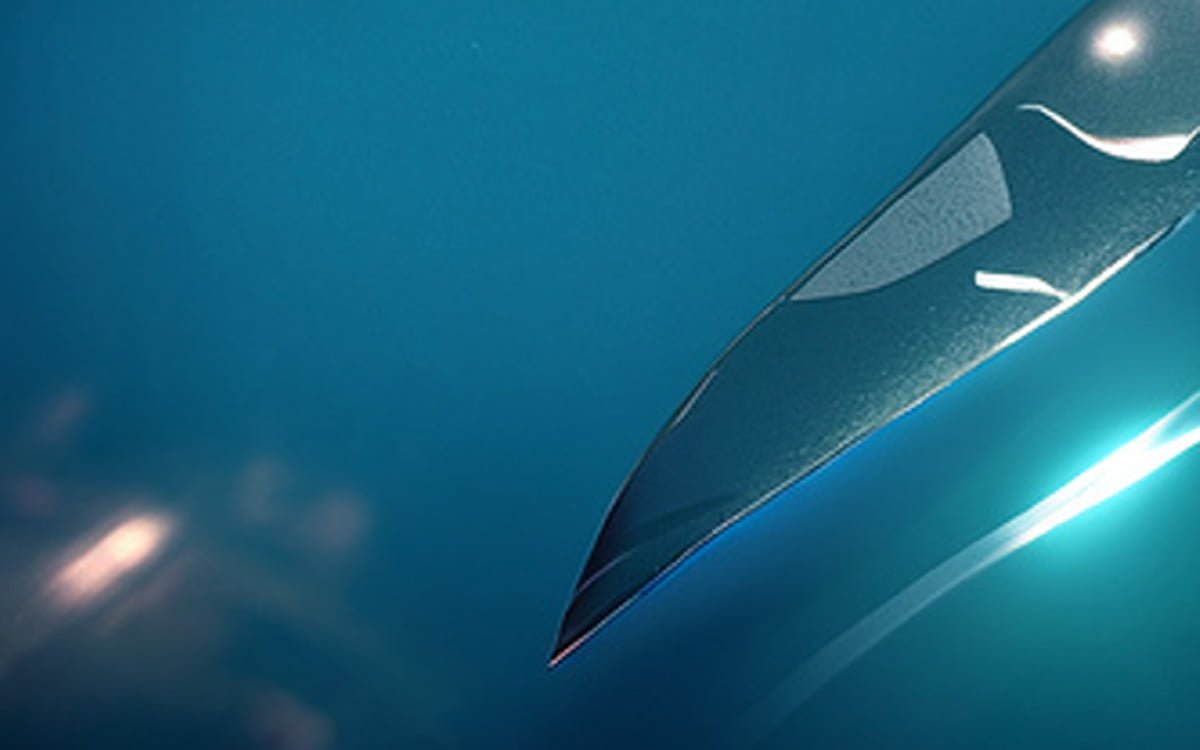

Die generierten Motive zeigen deutlich, dass CLIPs von Menschen geprägte Vorstellung von „Bouba“ ebenfalls eher rund und bei „Kiki“ eher scharf ist.

NearCyan versuchte in einem zweiten Schritt, den lautsprachlichen Effekt auf die Spitze zu treiben: Er forderte CLIP auf, ein zum Wort „kikitakekikitakek“ passendes Motiv zu generieren. CLIP erzeugte daraufhin ein dolchartiges Objekt, das mit scharfer Kante in die Bildmitte ragt. NearCyan will nun die Lautsymbolik in CLIP in weiteren Experimenten untersuchen.

Die Erkundung sprachlicher Phänomene in großen KI-Modellen wird wohl auch in Zukunft eine größere Rolle in anderen Wissenschaften spielen. Beispiele wie der Bouba/Kiki-Effekt oder GPT-3s einfache mathematische Fähigkeiten zeigen generell, dass sich in den riesigen Modellen Konzepte verbergen können, die von ihren Entwickler:innen nicht explizit vorgesehen waren und die nach dem KI-Training erst entdeckt werden müssen.