Mit GPT-3 schuf OpenAI die bis dato beste Text-KI. OpenAIs neue KI DALL-E generiert jetzt die passenden Bilder zum Text - und erstaunt dabei mindestens so sehr wie das Text-System.

Bei DALL-E, der Name mischt den Künstler Dali mit dem Roboter Wall-E, führt OpenAI die Textgenerierungsfähigkeit von GPT-3 mit der Bildgenerierungsfähigkeit von i-GPT zusammen.

Das Ergebnis: DALL-E kann zu einer Texteingabe passende Bilder generieren - und das teilweise ziemlich eindrucksvoll. Die folgenden Bilder beispielsweise generierte die KI zur Texteingabe: "Eine Illustration eines Baby-Rettichs in einem Tutu, der mit einem Hund spazieren geht." Die Illustration verändert sich passend zur Eingabe.

Die Fähigkeiten von DALL-E greifen bei realen und fiktiven Motiven: Die KI kann realistische Bilder erstellen oder solche, die an Werke berühmter Künstler erinnern. Auch das Spiel mit Perspektiven ist möglich: So kann die KI beispielsweise eine Walnuss in ihrer Gesamtheit oder als Makro-Fotografie zeigen.

Abhängig von der Eingabe kann die Bild-KI die Anzahl von Objekten in einem Bild variieren, also beispielsweise einen Block oder mehrere gestapelte Blöcke zeichnen. DALL-E kann darüber hinaus bestehende Bilder passend zu einer Texteingabe verändern. Das folgende Beispiel zeigt viereckige Uhren, die DALL-E nach einer entsprechenden Texteingabe in dreieckige Uhren umwandelt.

Wie GPT-3 nutzt DALL-E den maschinellen Aufmerksamkeitsmechanismus Transformer, der einem KI-System erlaubt, mehr Kontextdaten zu verarbeiten. Wir erklären Transformer in unserem aktuellen KI-Podcast im Detail.

DALL-E generiert Bilder zahlen-, orts- und zeitspezifisch

OpenAI untersucht bei DALL-E außerdem, wie die KI die Bedeutung von Begriffen in verschiedenen Kontexten zeigt: Die KI kann Bilder spezifisch für ein Land generieren, zum Beispiel Straßenzüge oder Essen, oder den technologischen Stand einer ausgewählten Dekade zeigen wie TVs aus den 50er Jahren.

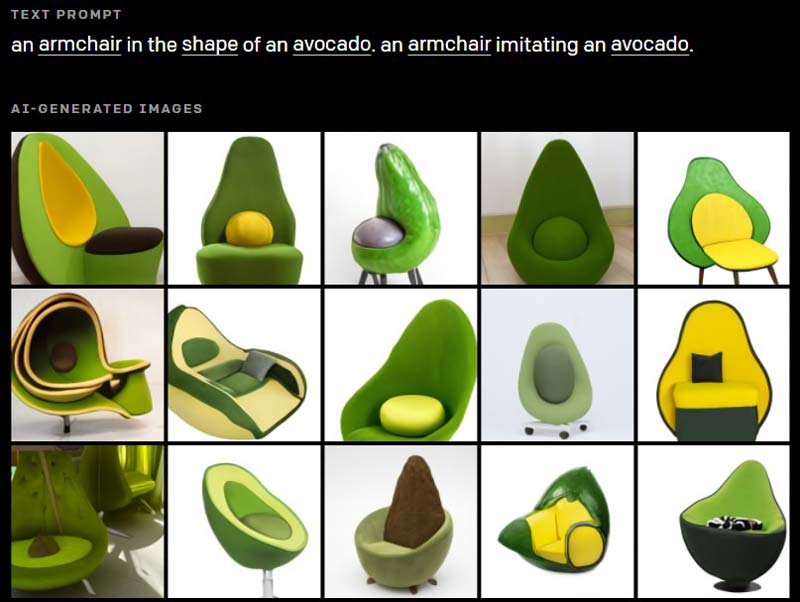

DALL-E kann außerdem Bilder zu Texteingaben trainieren, die nicht Teil des KI-Trainings waren, und Konzepte zusammenführen, die in der Realität typischerweise nicht miteinander verknüpft sind. Das zeigen etwa diese Sessel in Avocado-Form.

Ähnlich wie bei GPT-3 ist nicht immer klar, ob DALL-E Bilder von Grund auf neu erschafft oder nur Trainingsdaten wiedergibt. Außerdem kommt das System aus dem Tritt, wenn in der Bildunterschrift zu viele Objekte erwähnt werden, während alternative Formulierungen für das gleiche Motiv sehr unterschiedliche Resultate zur Folge haben können.

Diese in Details mangelnde Robustheit sollte der Bedeutung von DALL-E - ähnlich wie bei GPT-3 - keinen Abbruch tun. KI-Forscher und OpenAI-Chef Ilya Sutskever sieht in DALL-E einen Schritt hin zu KI-Systemen, die sowohl Text als auch Bilder und damit unsere "visuelle Welt" besser verstehen. "KI wird in der Lage sein, Sprache besser zu verstehen, weil sie erkennen kann, was Wörter und Sätze bedeuten", sagt Sutskever zu Technology Review.

Zu einer möglichen Veröffentlichung oder einem Verkauf von DALL-E äußert sich OpenAI nicht: Zunächst sollen mögliche Auswirkungen auf Wirtschaft und Arbeit untersucht werden sowie das Risiko von Verzerrungen in den Resultaten und "ethische Herausforderungen".

Technische Details zu DALL-E will OpenAI in einem kommenden Forschungspapier veröffentlichen. Viele Beispiele zu DALL-E-Bildern könnt ihr auf der Webseite von OpenAI ansehen.

CLIP: DALL-E kommt mit einem eigenen Bewertungssystem

Da KI-Generatoren wie GPT-3 oder DALL-E sowohl eindrucksvolle als auch sinnlose Daten ausgeben können, entwickelte OpenAI zusammen mit DALL-E das neuronale Netz CLIP (Contrastive Language-Image Pre-training): Es ist auf die Bilderkennung spezialisiert und wurde nach dem Vorbild von GPT-3 mit Internetdaten trainiert.

Eben das ist neu: Anstatt wie üblich auf vorgefertigte beschriftete Trainingsdatensets zurückzugreifen, verwendete OpenAI für das KI-Training von CLIP 400 Millionen Bilder mit Bildbeschreibung aus dem Internet. Die Bildbeschreibungen gaben der KI mehr Kontext zu einem Motiv, als es bei herkömmlichen Trainingsdatensets üblich ist.

Während des KI-Trainings hatte CLIP die Aufgabe, für ein Bild die korrekte Bildunterschrift aus einer Datenbank von 32,768 Textauszügen zu finden. Dafür lernte CLIP eine große Bandbreite visueller Konzepte und ihre passenden Namen.

Das Ergebnis ist eine robuste Bilderkennungs-KI, die besser generalisieren kann als vorhandene Systeme, die allerdings in einigen Bildaufgaben, wie beim Zählen von Objekten oder der genauen Unterscheidung von Pflanzenarten, schlechter abschneidet als spezifisch trainierte Systeme.

Da CLIP gut erkennen kann, ob Bild und Bildunterschrift zusammenpassen, kann die KI die Ergebnisse von DALL-E kategorisieren und nach Qualität sortieren. Die DALL-E-Bilder wurden laut OpenAI von CLIP statt wie üblich händisch ausgewählt. Das "Rosinenpicken", das OpenAI für Textbeispiele von GPT-3 noch vorgeworfen wurde, ist somit auch KI-automatisiert.