Nvidia arbeitet an KIs, die Bilder und Videos verändern und erstellen können. Jetzt hat das Unternehmen gemeinsam mit dem Massachusetts Institute of Technology (MIT) weitere Forschungsergebnisse als Open Source veröffentlicht.

Nvidia und das MIT veröffentlichen ein neues Video-zu-Video-Synthesemodell als Open-Source-Software. Der Algorithmus analysiert die Inhalte einzelner Bilder und erstellt sogenannte Segmente und Klassifizierungen.

So können etwa Menschen von Fahrzeugen unterschieden werden. Die erkannten Objekte können dann von einem entsprechend trainierten Algorithmus durch ähnliche Objekte ausgetauscht werden.

Beispiele für dieses Verfahren sind das Übersetzen einer Karikatur in ein fotorealistisches Bild, das Verwandeln von Tag- in Nachtaufnahmen oder das bekannte Deepfakes-Programm.

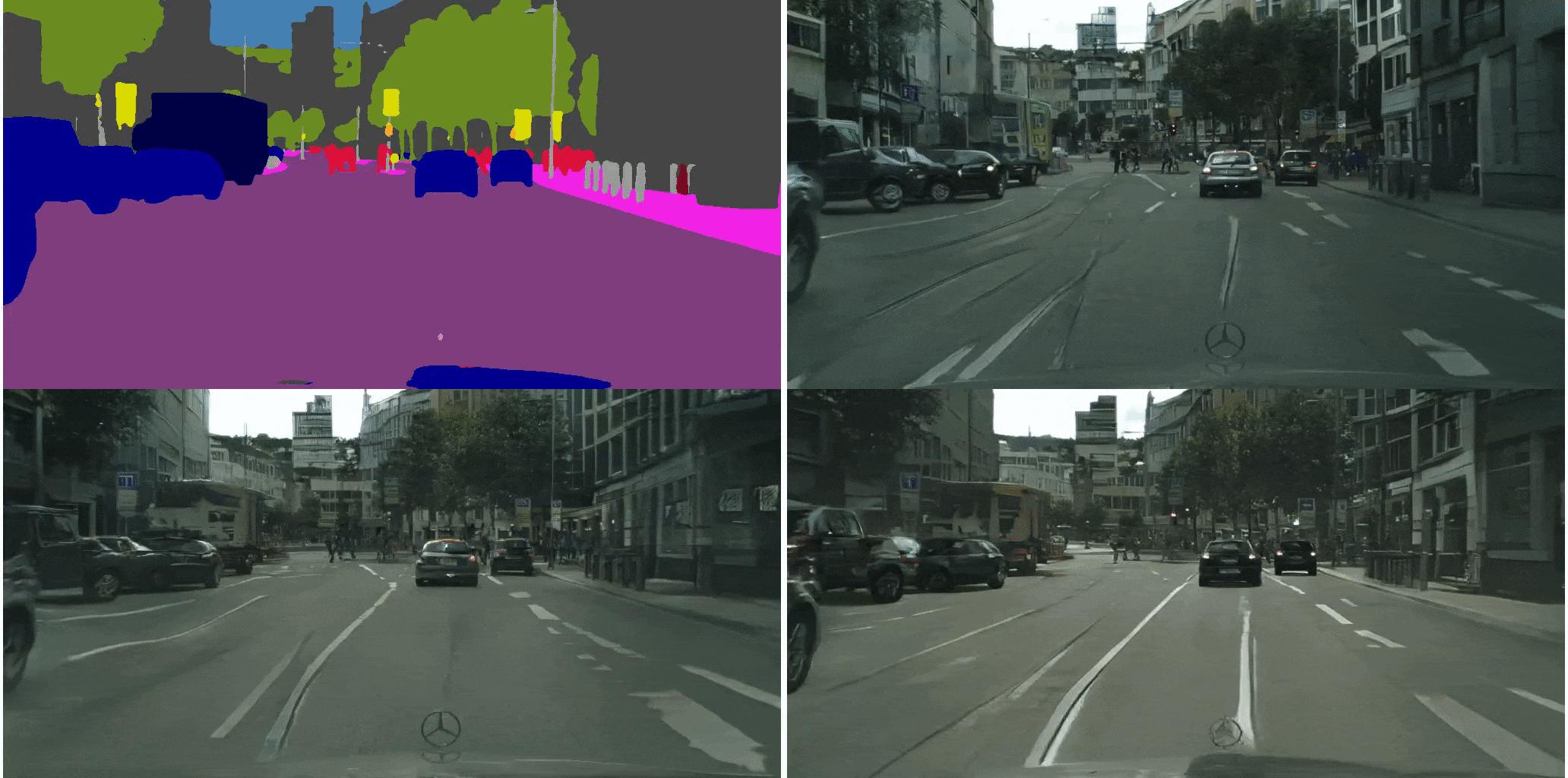

Oben links ist der segmentierte und klassifizierte Video-Input zu sehen, unten rechts der Output des Nvidia-Algorithmus.

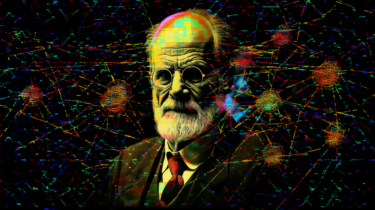

Ein Sketch-zu-Gesicht-Video des Nvidia Algorithmus.

Der Algorithmus kann außerdem die Bewegungsdaten eines Tänzers aus einem Video extrahieren und auf eine andere Person übertragen. Eine ähnliche Technologie stellten kürzlich Forscher der Universität Berkeley vor.

Pose-zu-Tanz-Video des Nvidia Algorithmus. Die Tänzerin wurde durch die KI animiert.

Bereits im letzten Jahr zeigte Nvidia eine Aufnahme eines fahrenden Autos in mehreren Varianten. Aus derselben Ausgangsaufnahme wurde ein Tag-, Nacht-, Sommer- und Wintervideo erstellt.

Videoblick in die Zukunft

Die Forscher entwickelten zusätzlich einen Prognosealgorithmus, der wenige Bilder pro Sekunde in die Zukunft schaut: der räumliche und zeitliche Verlauf des Originalvideos wird anhand der ersten Anfangsbilder reproduziert – ohne dass der Algorithmus jemals das vollständige Video gesehen hätte.

Oben links ist das Originalvideo zu sehen, unten rechts die Vorhersage des Nvidia-Algorithmus. Die Aufnahmen dazwischen zeigen Zwischenschritte der KI-Bildberechnung.

Wer genau hinschaut, sieht auf dem Originalvideo auf der Gegenspur ein helles Auto auftauchen. Seine Vorhersage trifft der Nvidia-Algorithmus allerdings aus den Informationen, die er den Anfangsbildern des Originalvideos entnimmt. Da dort das helle Auto noch nicht zu sehen ist, fehlt es in der Vorhersage des Nvidia-Algorithmus.

Außerdem fallen geometrische Artefakte auf: Der Reifen des silbernen Autos am rechten Rand wirkt unnatürlich.

Die Forscher berichten von weiteren Fehlern: Ein Auto ändert im Verlauf des Videos seine Farbe oder Artefakte werden sichtbar, wenn Gebäude durch Bäume ersetzt werden. Zukünftig wollen sie diese Fehler beheben.

Die Anwendungsgebiete solcher Bild- und Video-Synthese-Verfahren sind vielfältig: TVs können für eine flüssigere Darstellung Zwischenbilder berechnen, Mediziner können die Qualität und Informationsdichte von MRT-Bildern verbessern und Google erstellt mit ihnen anhand von Satellitenbildern die Straßenkarten für Google Maps.