Forscher von Google erklären, wie sie ihre Schlafdiagnose-Algorithmen auf dem Google Nest Hub 2 optimieren, um die verschiedenen Schlafphasen eines Menschen zu identifizieren.

Mit dem neuesten Update für das Nest Hub 2 liefert Google eine verbesserte Version seines Schlafanalyse-Tools. Die verschiedenen Schlafstadien sollen besser verstanden und Geräuschquellen genauer verortet werden.

In einem Blog-Post erklären Google-Forscher, wie Transfer-Learning-Techniken für KI-Systeme bei der Schätzung von Schlafstadien helfen und Sensorfusion von Radar- und Mikrofonsignalen die Verortung von Geräuschen ermöglicht.

Google Soli: eine Comeback-Story

Anfang des Jahres veröffentlichte Google das Smart Display Nest Hub 2 und brachte damit eine fast vergessene Innovation zurück: Soli, das zuletzt in Googles Smartphone Pixel 4 enttäuschte, weil es eigentlich so viel mehr können sollte. Googles Miniradar arbeitet submillimetergenau, wiegt Objekte, identifiziert und sortiert sie sogar.

Umgetauft in „Motion Sense“ wurde Soli auf dem Pixel zu einer wenig intuitiven Gestensteuerung am Smartphone. Per Wischbewegung vor dem Bildschirm bediente man die Musikwiedergabe. Der Sensor hatte allerdings häufig Probleme zu erkennen, ob sich die Hand vor dem Bildschirm oder das Smartphone vor der Hand bewegt und arbeitete deshalb eher holprig.

Soli kehrt zurück und misst euren Schlaf

Im stationären Nest Hub 2 (Test) hingegen funktioniert die Gestensteuerung mit Soli tadellos. Sein Haupteinsatzzweck ist dort allerdings die Schlafdiagnose. Auch hier wieder als Motion Sense beworben, misst der Miniradar nächtliche Bewegungen im Brustbereich vom Nachttisch aus und stellt dadurch etwaige Unregelmäßigkeiten bei der Atmung fest.

Diese Daten legt das Nest Hub 2 mit den Ergebnissen einer nächtlichen Licht- und Geräuschmessung zusammen. Anschließend analysieren Googles Schlaf-Algorithmen damit die Schlafqualität von Nutzer:innen. Ein Pulsmesser, eine Smartwatch am Handgelenk oder das Smartphone neben dem Kopfkissen, wie bei anderen Schlafanalysesystemen, werden nicht benötigt.

So wurde die Geräuscherkennung im Nest Hub 2 optimiert

Auf dem Google AI-Blog erklären Software-Ingenieur Michael Dixon und Google Health Product Manager Singal Lee, wie diese Algorithmen auf die Unterscheidung der verschiedenen Schlafphasen Leicht-, Tief- und REM-Schlaf programmiert wurden und wie die Geräuschverortung funktioniert.

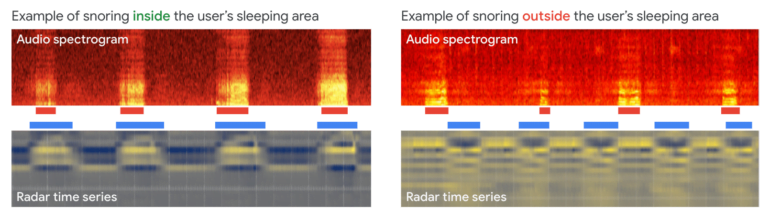

Bisher nutzte das Nest Hub zur Geräuscherkennung einen CNN-basierten Detektor. Damit wurde das Mikrofonsignal verarbeitet und Husten oder Schnarchen erkannt. Das Nest Hub wusste aber nicht, von wo oder wem ein Geräusch kam. Um die Signale richtig zu verorten und nicht das Schnarchen des Hundes dem Nutzer zuzuschreiben, werden künftig Audiosignale mit den Bewegungssignalen von Soli abgeglichen.

Schnarcht der Nutzer, muss das Geräusch den Atmungsbewegungen entsprechen, die Soli im benutzerdefinierten Schlafbereich erfasst. Erkennt das Nest Hub Husten- oder Schnarchlaute, stellt aber keine ausreichende Korrelation zwischen Audiosignalen und Bewegungsmustern fest, vermerkt es diese unter „andere Geräusche“. Etwas komplizierter wird es bei der Klassifizierung der Schlafstadien.

Training und Evaluierung von Googles Schlafstadien-Klassifizierungsmodell

Das neue Modell wurde auf die Vorhersage von Schlafstadien trainiert, während die ursprüngliche Version lediglich den Schlaf-Wach-Status erkannte. Dieser Trainingsprozess ist den Google-Forschern zufolge deutlich komplexer. Um einen reichhaltigen und vielfältigen Datensatz für das Training der KI-Modelle zu erhalten, nutzte das Nest-Hub-Team bestehende Nicht-Radar-Datensätze und setzte Transferlernen ein.

Der Goldstandard für die Identifizierung von Schlafstadien ist die Polysomnographie (PSG): Bei diesem Verfahren setzen Schlafwissenschaftler:innen eine Reihe von am Körper getragenen Sensoren ein, um Körperfunktionen während des Schlafs zu überwachen. Dazu zählen Gehirnaktivität, Herzschlag, Atmung, Augen- und Körperbewegungen. Aus diesen Signalen interpretieren Spezialisten anschließend die Schlafstadien.

KI-Training für Soli mit über 10.000 Schlafanalysedaten

Die Google-Ingenieure nutzten für die Entwicklung ihres Modells öffentlich zugängliche Daten aus der Sleep Heart Health Study (SHHS) und der Mulitethnic Study of Atherosclerosis (MESA) mit mehr als 10.000 PSG-Rohdaten. Die darin enthaltenen Sensordaten wurden durch eine thorakale Ateminduktionsplethysmographie (RIP) erfasst, einer nicht-invasiven Methode zur Überwachung der Atmung, bei der ein Brustgurt die Bewegung während der Atmung misst.

Sowohl Radar- als auch RIP-Signale eignen sich zur Charakterisierung von Atmung und Bewegung. Ihre Ähnlichkeit machten sich die Google-Forschenden zunutze. Sie berechneten die Spektogramme aus den RIP-Zeitseriensignalen und nutzen sie als Merkmale, um ein Convolutional Neural Network auf die Vorhersage der richtigen Schlafstadien zu trainieren.

Das benutzerdefinierte ML-Modell verarbeitet effizient einen kontinuierlichen Strom von 3D-Radar-Tensoren (wie im Spektrogramm oben in der Abbildung dargestellt), um automatisch Wahrscheinlichkeiten für jede Schlafphase – REM, leicht und tief – zu berechnen oder zu erkennen, ob der Benutzer wach oder unruhig ist. | Bild: Google | Video: Google AI

Das Modell lernte, die für die Unterscheidung von Schlafstadien nötigen Atem- und Bewegungsmuster im RIP-Signal zu erkennen. Daraus schlossen die Forscher, dass dies auch bei der Verwendung von radarbasierten Signalen möglich sein sollte. Um die Allgemeingültigkeit ihres Modells zu testen, ersetzten Lee und Dixon ähnliche Spektogramm-Merkmale, die vom Soli-Sensor aus dem Nest Hub berechnet wurden.

Laut den Forschern war das Modell, das für die Vorhersage von Schlafphasen aus einem Plethysmografiesensor trainiert wurde, viel weniger genau, wenn stattdessen Radarsensordaten verwendet wurden. Dennoch schnitt das Modell deutlich besser ab als Zufall. Das zeige, dass es Merkmale gelernt habe, die für beide Bereiche relevant sind.

Zur Verbesserung kam ein sekundärer Datensatz von Radarsensordaten mit PSG-basierten Groundtruth-Labeln zum Einsatz. Durch diese kleinere Menge an Trainingsdaten konnte das Modell die ursprünglichen Merkmale, die es aus der plethysmographiebasierten Schlafeinteilung gelernt hatte, anpassen und sie erfolgreich verallgemeinern. Das fein abgestimmte Modell lieferte schließlich vergleichbare Ergebnisse bei der Schlaferkennung wie herkömmliche Schlaftracker.