AEyes Lidar für autonomes Fahren erreicht Sichtweiten von bis zu 1000 Metern. Mit namhaften Partnern soll die Technologie schon bald produktionsreif werden.

Vor knapp vier Monaten vermeldete das kalifornische Start-up AEye einen Durchbruch in der Lidar-Forschung: Der 4 Sight M-Sensor sei leistungsstärker und preiswerter als alle anderen Lidar-Sensoren am Markt und könne Objekte in einer Entfernung von bis zu 1.000 Metern erkennen. Der damalige Standard lag bei etwa 200 Metern. Nun gibt AEye eine Reihe von namhaften neuen Partnern bekannt.

4 Sight M-Sensor: 1.000 Meter Reichweite und Scan-Raten von 200 Hertz

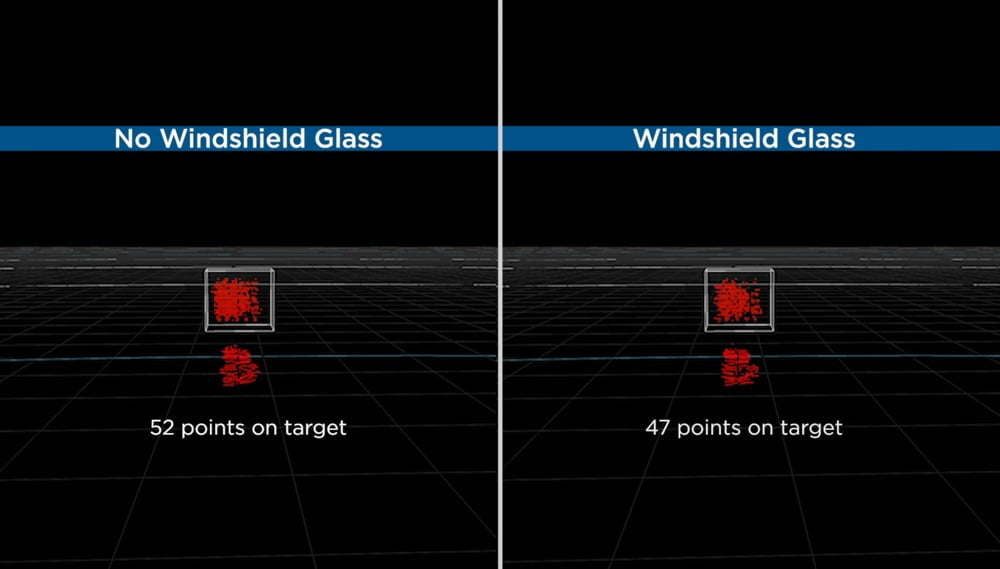

AEyes Langstrecken-Lidar soll nach eigenen Angaben mit einer Abtastrate von zehn Bildern pro Sekunde arbeiten. Das ermögliche die vierfache Reichweite und fünffache Anzahl von Erkennungen im Vergleich zu Konkurrenzprodukten. Der kompakte Solid-State-Sensor könne hinter Oberflächen wie der Windschutzscheibe platziert werden und dabei weniger als zehn Prozent an Leistung einbüßen.

Im März stellte AEye seinen Lidar-Sensor mit enormer Reichweite vor. Seine Leistung ließ das Start-up von einer unabhängigen Forschungseinrichtung bestätigen. VSI Labs überwachte eine Testreihe und verifizierte unter anderem die Sichtweite.

Zwei Fahrzeuge identifizierte der Lidar in Beisein der Organisation auf über 1.000 Meter Entfernung eindeutig. Auch die Scan-Raten von mehr als 200 Hz und die geringen Leistungseinbußen bei einer Platzierung des Sensors hinter der Windschutzscheibe bestätigt die VSI.

Continental setzt AEyes-Lidar in eigenen Fahrsystemen ein

Mittlerweile arbeitet AEye an der Kommerzialisierung seines Langstrecken-Lidars. In der vergangenen Woche gab das Start-up eine Reihe von neuen Partnerschaften bekannt. Einer davon ist die Continental AG. Der deutsche Automobilzulieferer zählt seit etwa zehn Monaten zu den Investoren AEyes und will den 4 Sight M-Sensor künftig in seine Automated Driving Plattform integrieren.

Continental setzt den Lidar zusammen mit Kameras, Radar- und Ultraschall-Sensoren in Fahrassistenzsystemen und autonomen Fahrsystemen von Passagier- und Nutzfahrzeugen ein. Diese sollen Level 2 bis 4 auf der kürzlich durch SAE und ISO überarbeiteten Norm für autonomes Fahren erreichen. Sowohl ein Komplettsystem als auch ein Standalone-Lidar auf AEye-Basis sollen ab 2024 bei Continental in Produktion gehen. Derzeit stellt das Unternehmen erste Testmuster für die Weiterentwicklung der Sensoren im Werk Ingolstadt her.

Autonomes Fahren bei Trucks nur mit hohen Sichtweiten möglich

Erst vor Kurzem zeigte das amerikanisch-asiatische Start-up TuSimple die Vorteile autonomen Fahrens bei der Auslieferung von Frischwaren. Gemeinsam mit dem Handelsnetzwerk The Giumarra Companies schickte TuSimple einen Robo-Truck 1.000 Meilen durch die USA. Im Vergleich zu einem herkömmlichen Lkw mit menschlichem Fahrer lieferte der autonom fahrende Semi-Truck die Waren zehn Stunden früher ab.

TuSimple arbeitet unter anderem mit VWs TRATON-Gruppe an einem kommerziell nutzbaren autonomen Fahrsystem für Schwerlast-Lkws. Aufgrund der extremen Langstreckenleistung und den beeindruckenden Wettereigenschaften von AEyes Lidar habe sich das Unternehmen zu einer Entwicklungspartnerschaft entschlossen.

Laut TuSimples Chief Product Officer Chuck Price ergänze AEyes Lidar mit seiner extrem großen Reichweite das bestehende System ideal. Hohe Sichtweiten sind vor allem bei autonom fahrenden Trucks unabdingbar. Nur so kann eine sichere Objekterfassung und -vermeidung bei Autobahngeschwindigkeiten erreicht werden.

AEyes Lidar kompatibel mit Nvidia Drive

Ab sofort wird AEyes Lidar-Technologie auch mit Nvidia Drive kompatibel sein. Somit haben Entwickler von autonomen Fahrsystemen, die auf Nvidias Plattform basieren, künftig die Möglichkeit, auf AEyes SDK und Visualizer zuzugreifen. Damit können beispielsweise Sensor- und Sichtpunktwolken konfiguriert werden.

Für Nvidia sind die adaptiven und intelligenten Erkennungsfunktionen von AEye eine willkommene Ergänzung. KI-gesteuerte Sensorik und Wahrnehmung seien laut Glenn Schuster, Nvidias Senior Director of Sensor Ecosystems, entscheidend für die Lösung anspruchsvoller Herausforderungen im autonomen Fahren.

Mit Nvidias Drive-Plattform sind theoretisch autonome Fahrsysteme bis hin zu Stufe 5 möglich. Das entspricht vollständig automatisiertem Fahren, bei dem der Mensch zu keiner Zeit mehr eingreifen muss.

Noch ist diese Technologie nicht erreicht: Führende Hersteller wie Waymo oder Cruise arbeiten derzeit an Level-4-Systemen, die unter bestimmten Bedingungen und auf festgelegten Gebieten ohne menschliches Eingreifen agieren können. In Kalifornien sind aktuell acht Start-ups fahrerlos unterwegs.

Die unterschiedlichen technologischen Ansätze der derzeit führenden Unternehmen im autonomen Fahren besprechen wir in unserem MIXEDCAST Folge 255.

Titelbild & Quelle: AEye