In Kommentarspalten und Online-Foren fühlen wir uns alle so frei, dem Gesprächspartner mal so richtig die Meinung zu sagen. Solche Streitgespräche eskalieren flott und sind dann für alle Beteiligten - aktiv und passiv - irgendwann unangenehm. Eine Künstliche Intelligenz könnte zukünftig bei der präventiven Moderation unterstützen.

Aktuelle KI-Systeme können Online-Texte mittels Musterabgleich gut auf Fakten und eindeutige Sachverhalte untersuchen, beispielsweise um Antworten auf klar formulierte Fragen zu geben - das kann eine KI mittlerweile sogar besser als der Mensch. So etwas wie Verständnis für den Inhalt und damit einhergehend ein Gefühl für die Intention eines Autors hat die Maschine jedoch nicht.

Forscher der Cornell Universität in New York kooperieren mit Wikimedia und Googles Technologie-Inkubator Jigsaw, um einer KI dieses Sprachgefühl anzutrainieren. Sie entwickelten ein Rahmengerüst, mit dem eine Künstliche Intelligenz vorhersehen lernen soll, ob ein Gespräch im Streit endet. Das System wird auf den Kommentarseiten von Wikipedia-Artikeln erprobt, auf denen mitunter hitzig über inhaltliche Änderungen diskutiert wird.

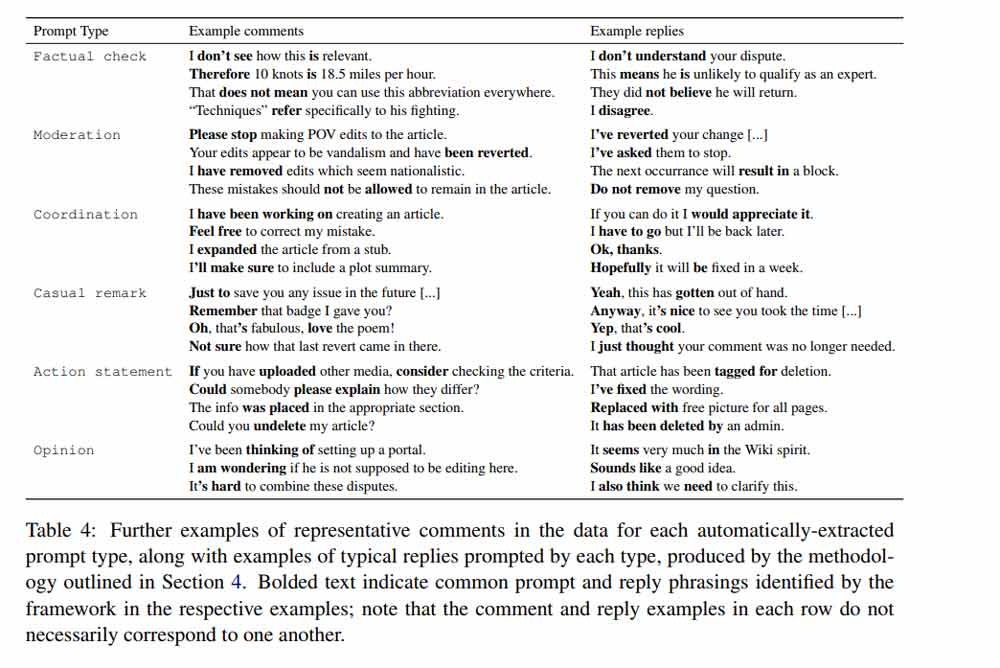

Das KI-System soll in diesen Konversationen Formulierungen entdecken, die auf Dankbarkeit und Verbundenheit oder Streit und Provokation hindeuten. Positive Signalwörter sind beispielsweise "Danke", "Ich denke, dass ..." oder "bitte".

Kritisch wird es hingegen bei direkten Fragen wie "Warum hast Du das nicht beachtet?" und wenn der Adressat am Satzanfang direkt persönlich angesprochen wird: "Deine Meinung zählt nicht." Die Forscher ergänzen das eigene Rahmengerüst mit einer Google-KI, die die generelle Tonalität in Online-Konversationen in "freundlich", "neutral" oder "aggressiv" einteilt.

Ergebnis: Nicht verlässlich, aber fast so gut wie der Mensch

Das Forschungsergebnis zeigt, dass KI-gestützte Sprachanalyse noch am Anfang steht: Nach der Trainingsphase konnte die KI bei Vorlage von zwei Gesprächsverläufen mit einer Genauigkeit von knapp 65 Prozent vorhersagen, wann ein Streit entsteht und wann nicht.

Damit schneidet die Maschine zwar nicht viel besser ab als Zufall, ist aber immerhin fast so gut wie menschliche Tester. Die konnten den Gesprächsverlauf bei 72 Prozent der untersuchten Diskussionen korrekt vorausahnen. Im Gegensatz zum Menschen kann die KI allerdings keine kausalen Zusammenhänge beschreiben.

Die Forscher jedenfalls werten ihr Studienergebnis als Beweis ein, dass sich ein Computer menschliche Intuition aneignen kann. Sie räumen allerdings auch ein, dass sie bei ihrer Untersuchung gelernt hätten, wie unberechenbar und dynamisch menschliche Konversationen seien.

Facebook und Co. jedenfalls dürften sich die Finger nach solchen Systemen lecken, die persönliche Attacken und Belästigungen möglichst früh entdecken, am besten noch bevor sie passieren. Soziale Netze sind laut den Forschern auch die potenzielle Zielgruppe für den Einsatz ihrer Technologie.