Reddits KI-Faker haben ein neues Opfer gefunden: Nicolas Cage. Dank Künstlicher Intelligenz taucht der bekannte US-Schauspieler plötzlich in Filmen auf, in denen er nie mitgespielt hat.

Im Dezember berichtete ich erstmals über mit Künstlicher Intelligenz erstellte Fake-Pornos (Deepfake), in denen die Köpfe bekannter US-Frauen jene von Pornodarstellerinnen ersetzen. Seitdem wächst die Sexfälscher-Gemeinschaft und verselbstständigt sich zunehmend.

Gerade eben erst beendete der der Chat-Service Discord einen Deepfake-Kanal, in dem die Nutzer gefälschte Pornographie tauschten. Sexuelle Darstellungen sind bei Discord zwar nicht grundlegend untersagt, aber der Betreiber wertet die Fake-Pornos als Vergewaltigungen.

Besonders kritisch: In der Gruppe wurden Fake-Pornos mit Ex-Freundinnen oder Klassenkameradinnen in der Hauptrolle geteilt. Für diese müssen die betroffenen Frauen nicht einmal im echten Leben fotografiert oder gefilmt werden: Eine größere Anzahl öffentlich zugänglicher Fotos bei Instagram oder Facebook kann ausreichen, um die Fälschung zu erzeugen. Je mehr Aufnahmen die KI vorab analysieren kann, desto glaubwürdiger wird die anschließende Fälschung.

Die Mitglieder der Discord-Gruppe wurden permanent gesperrt. Bei Reddit nimmt die Anzahl an Fake-Pornos derweil rasant zu: Beinahe stündlich erscheinen neue Videos, die zunehmend schwieriger als Fälschung zu entlarven sind.

Nicolas Cage muss als PR-Beispiel herhalten

In der Reddit-Gruppe wird offen diskutiert, wie mehr Aufmerksamkeit auf das kollektive Pornoprojekt gelenkt werden kann. Die Nutzer wissen, dass ihre Pornovideos gerade von den US-Medien kaum verbreitet oder verlinkt werden. Daher braucht es harmlosere Beispiele. Das Opfer ist schnell gefunden: Der US-Schauspieler Nicolas Cage, der ohnehin ein beliebtes Internetmem ist.

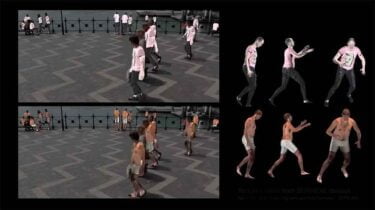

Der Nutzer Derpfakes berechnete Cage in zahlreiche gefälschte Videos und zeigt so, dass der Algorithmus neben Pornos auch jedes andere Video glaubhaft manipulieren kann. Plötzlich taucht Cage in Filmen auf, in denen er nie mitgespielt hat: Er ersetzt Sean Connery in James Bond, Harrison Ford in Indiana Jones, rennt als Forrest Cage so schnell wie er kann oder spricht mit sich selbst in einer Late-Night-Show.

Auch der Geschlechtertausch ist möglich: Im Superhelden-Epos Batman v Superman sitzt Cages Gesicht auf dem zierlichen Körper der Schauspielerin Amy Adams - und sieht dabei irgendwie dennoch glaubhaft aus.