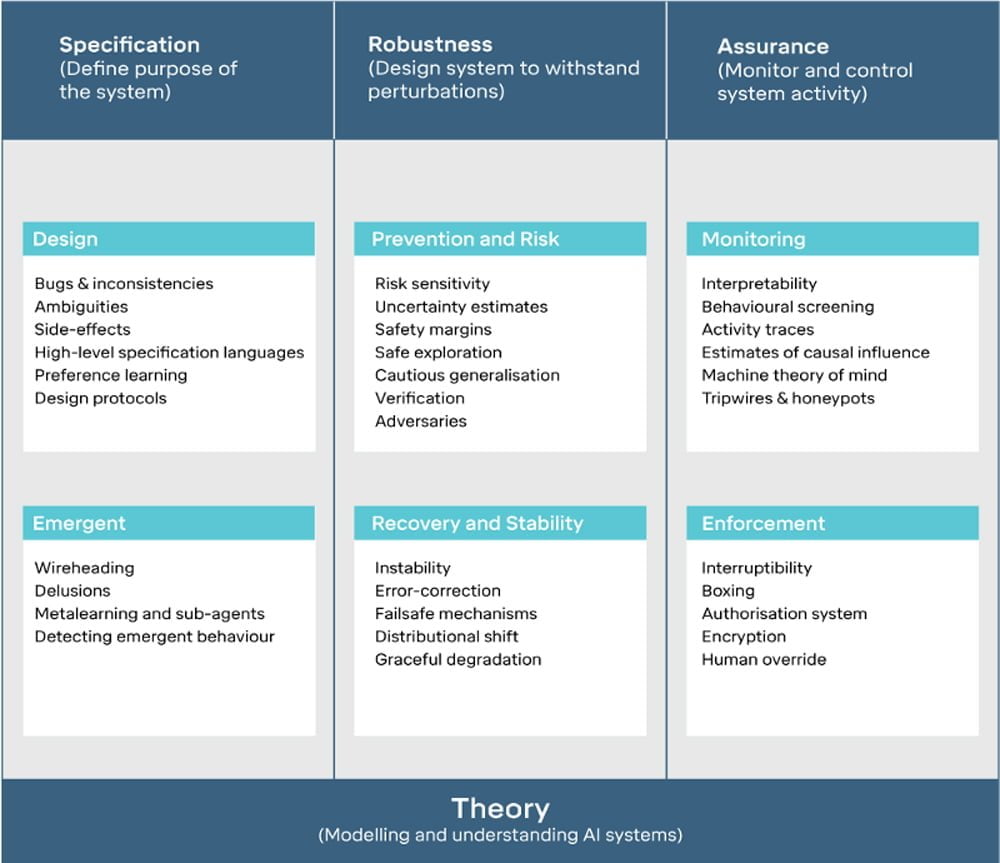

Forscher der Google-Schwester DeepMind veröffentlichten kürzlich einen Artikel zur KI-Sicherheit. In dem Artikel stellen sie drei Grundprinzipien einer sichereren KI-Architektur vor: Spezifikation, Robustheit und Versicherung.

Nur entlang dieser drei Parameter könne sichergestellt werden, dass eine KI kein unerwünschtes Verhalten entwickelt, schreiben die Deepmind-Forscher. Das gewünschte Verhalten der KI müsse eindeutig spezifiziert werden und auch in ungewohnten Umgebungen robust funktionieren. Sollte etwas schieflaufen, müsse die KI im Notfall überschrieben oder ausgeschaltet werden können.

Ich stelle die drei Prinzipien kurz vor und erläutere sie.

Spezifikation

Die Aufgabenbeschreibung einer KI ist kompliziert, da sie sehr präzise sein und viele mögliche Konsequenzen berücksichtigen muss. Es muss sichergestellt werden, dass die KI die beabsichtigten Ziele verfolgt – und nur diese. Größte Gefahr: eine KI, die sich für ein ungenau formuliertes Ziel optimiert und plötzlich Dinge tut, die nie vorgesehen waren.

Beispiele für diese Situation gibt es viele: König Midas‘ Goldgier, der Besen des Zauberlehrlings oder der Paperclip Maximizer. Man könnte es das Dschinn-Problem nennen: Ein unklar formulierter Wunsch führt zu ungewollten Ergebnissen.

In ihrem Artikel geben die Deepmind-Autoren ein Beispiel: eine KI, die in einem Rennspiel ihr Boot immer im Kreis fährt, um die maximale Punktzahl zu erreichen. Dabei nimmt sie auch Kollateralschäden in Kauf. Das Rennen beendet sie jedoch nie.

Die KI optimiert sich auf das Ziel der Punktmaximierung. Das Problem: Eine Runde zu beenden, gibt wesentlich weniger Punkte, als die wiedererscheinenden Ziele immer wieder einzusammeln – ein Fehler im Spieldesign, der erst auffiel, als die KI ihn ausnutzte.

Robustheit

Ein robustes KI-System operiert unter unbekannten oder unerwarteten Umständen stets wie vom Entwickler gewünscht. Das ist besonders wichtig, wenn das System in der echten Welt zum Einsatz kommt.

Im Gegensatz zu einer Simulation existieren in der Realität beinahe unendlich viele Variablen, die ein KI-System aus dem Tritt bringen könnten. Ein Entwickler könnte diese niemals alle in seinem Code adressieren.

Schon kleine Veränderungen führen in manchen Fällen zum Totalausfall der KI.

Links: Die KI hat gelernt, die roten Lava-Punkte zu umgehen. Rechts: Dieselbe KI scheitert, sobald die Lava an einem neuen Ort erscheint. Sie reagiert nicht flexibel.

Die KI müsse außerdem vor gezielten Angriffen geschützt sein, schreiben die Deepmind-Forscher. Manche KI-Systeme könnten missbraucht werden. Ein Angriffsschutz müsse daher sowohl Systemschaden als auch Manipulation verhindern.

Keine leichte Aufgabe, wenn man bedenkt, wie leicht aktuelle Systeme durcheinanderkommen können – mitunter reicht ein bunter Sticker.

Versicherung

Sollte die Aufgabenstellung eskaliert sein oder das KI-System in der Realität versagen, sollen zusätzliche Sicherungsmechanismen helfen. Diese sollen die KI-Handlungen zunächst nachvollziehbar und dann kontrollierbar machen.

Die Versicherung besteht nach Deepmind aus zwei Bereichen: Überwachung und Vollstreckungsgewalt.

Bei der Überwachung ist die viel diskutierte Black Box das Problem: Umfassende neuronale Netze sind mathematisch so komplex, dass ihre Entscheidungen für Menschen nicht mehr nachvollziehbar sind.

Eine KI dürfe keine Black Box sein, schreiben die Deepmind-Forscher. Fortlaufende Überwachung und Analyse sollen die Vorhersage des KI-Verhaltens möglich und berechenbar machen.

Sollten alle Stricke reißen, greift das letzte Sicherheitsprinzip: Die KI muss im laufenden Betrieb überschrieben oder deaktiviert werden können.

Ausblick

Die Autoren sehen ihre Richtlinien als wichtige Sicherheitsmechanismen für zukünftige KI-Anwendungen. Angesichts einiger Skepsis aus der Branche, ob solche Mechanismen nötig sind, schließen sie mit einer Mahnung:

"Designentscheidungen, die zum Zeitpunkt der Entwicklung kein Risiko sind, könnten einen großen Einfluss haben, wenn die Technologie weit verbreitet ist. Jetzt sind sie vielleicht praktisch, aber in der Zukunft stellen sie uns vor fast unlösbare Probleme."