Künstliche Intelligenz kann digitale Welten verschönern bei einem geringeren Rechenaufwand im Vergleich zu herkömmlichen Renderverfahren. Voraussetzung: Die KI hat ausreichend Trainingsmaterial.

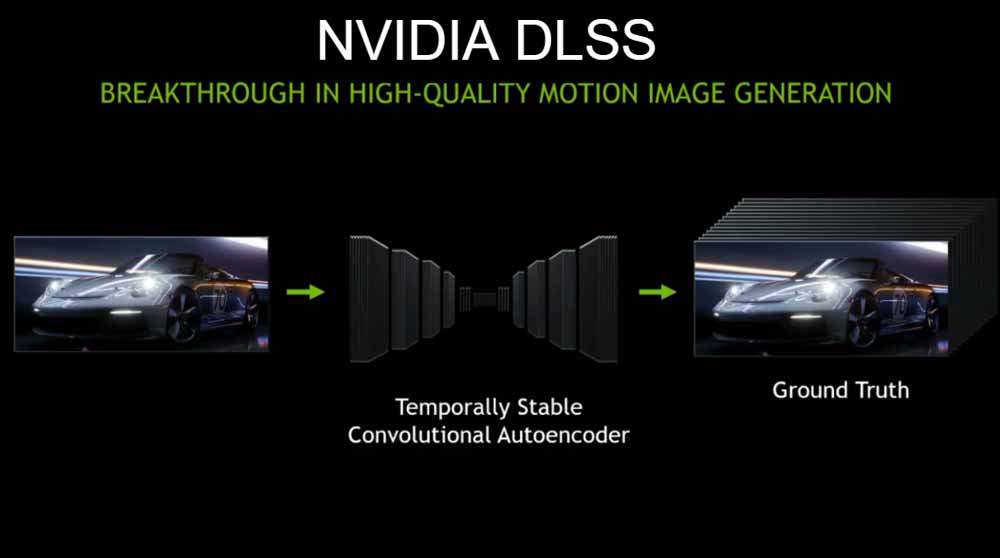

Bei Nvidias DLSS lernt eine KI anhand von Spielebildern mit niedrig aufgelöster, kantiger Grafik und deren bereinigter Idealversion den Unterschied kennen zwischen für Menschen hässlichen und schönen Pixelmustern. Dann trainiert die KI, zusätzliche Pixel so ins Bild einzublenden, dass unschöne Kanten und Treppchenffekte (Aliasing) verschwinden.

Trainiert wird das KI-Modell auf einem Supercomputer. Den Trainingsvorgang muss Nvidia spezifisch pro Spiel durchlaufen. Anschließend kann das Modell mit einem Bruchteil des Rechenaufwands lokal auf einer RTX-Grafikkarte ausgeführt werden.

Mit einem ähnlichen KI-Verfahren generierte Nvidia eine HD-Version des Spieleklassikers Zelda mit deutlich aufgewerteten Texturen.

Der Supercomputer schläft nie

So gut das KI-Rendering in der Theorie klingt, in der Praxis ist es noch nicht da, wo Spieler und Nvidia es gerne hätten.

Bei den wenigen unterstützten Spielen gibt es gerade bei niedrigeren Auflösungen in 1080p und 1440p Beschwerden, dass die von Künstlicher Intelligenz berechneten Bilder weniger scharf sind als die herkömmlich gerenderte Grafik.

Im Unternehmensblog verspricht Andrew Edelsten, Director of Deep Learning bei Nvidia, Verbesserungen bei der von DLSS erzeugten Bildqualität: Derzeit variiere sie, da jedes Spiel unterschiedliche Charakteristiken habe, basierend auf der Engine, der Komplexität der Szene und der Trainingsdauer der KI.

"Unser Supercomputer schläft nie und wir trainieren und verbessern unser neuronales Netzwerk weiter, nachdem ein Spiel schon erhältlich ist", schreibt Edelsten. Ausgeliefert werden diese Verbesserungen durch neue Treiber.

Trainiert für 4K

Dass sich viele Spieler über matschige KI-Grafik beschweren, liege daran, dass das aktuelle Modell hauptsächlich für eine 4K-Auflösung trainiert sei.

Bei niedriger aufgelöster Spielegrafik muss die KI beim Training mit deutlich weniger Pixeln auskommen. Weniger Trainingsdaten resultieren in ungenaueren Vorhersagen über zusätzliche Pixel - und somit in Unschärfe.

"Wir haben die Screenshots gesehen, hören uns das Feedback der Community zu DLSS in niedrigeren Auflösungen an und priorisieren die Entwicklung entsprechend", verspricht Edelsten. Die Bildqualität soll mit mehr Trainingsdaten und "einigen neuen Techniken" gesteigert werden.

DLSS ist laut Nvidia nur ein Beispiel für durch KI beschleunigte Grafikberechnung. Das Unternehmen zeigte Ende 2018 erstmals eine Computerstadt, deren Straßenzüge anhand von Videos realer Straßenzüge von einer KI erstellt wurden.

Speziell für VR sollen genaueres Körper- sowie Augentracking oder glaubwürdigere Animationen von digitalen Charakteren möglich sein.