Intel realisiert mit Deep Learning und Realsense-Tiefenkameras beeindruckendes Ganzkörpertracking für VR.

Es gibt einige Lösungen für die vollständige Körpererfassung in VR: den Holosuit, HTCs Vive Tracker oder Hybridlösungen mit Kinect-Kameras. Maschinenlernen ermöglicht, ganze Menschengruppen mit einer normalen Videoaufnahme zu erfassen oder einzelne Personen mit einem modifizierten WLAN-Sender durch Wände zu verfolgen.

Diese Lösungen sind jedoch entweder teuer oder rechenaufwendig. Der Holosuit zum Beispiel kostet etwa 1.350 Euro. Beim Maschinenlernen wiederum benötigt der Computer Tausende Bilder, um Skelett und Gelenke des Menschen zu erfassen und digital abzubilden – das generiert Aufwand und damit Kosten. Für den VR-Heimgebrauch ist es ungeeignet.

Existierende KI-Tracking-Lösungen wie Open Pose oder Hourglass Networks setzen auf tiefe neuronale Netzwerke. Die verlangen nach Leistung: Open Pose läuft selbst auf zwei GTX 1080 Ti Grafikkarten mit nur 18-24 Bildern pro Sekunden - für VR-Anwendungen ist das zu wenig und führt zu ungenauem Tracking. Die hohen Ansprüche an CPU und GPU sind außerdem für autarke VR-Brillen ein auf lange Sicht unüberwindbares Hindernis.

Intel stellt neue KI-Tracking-Methode vor

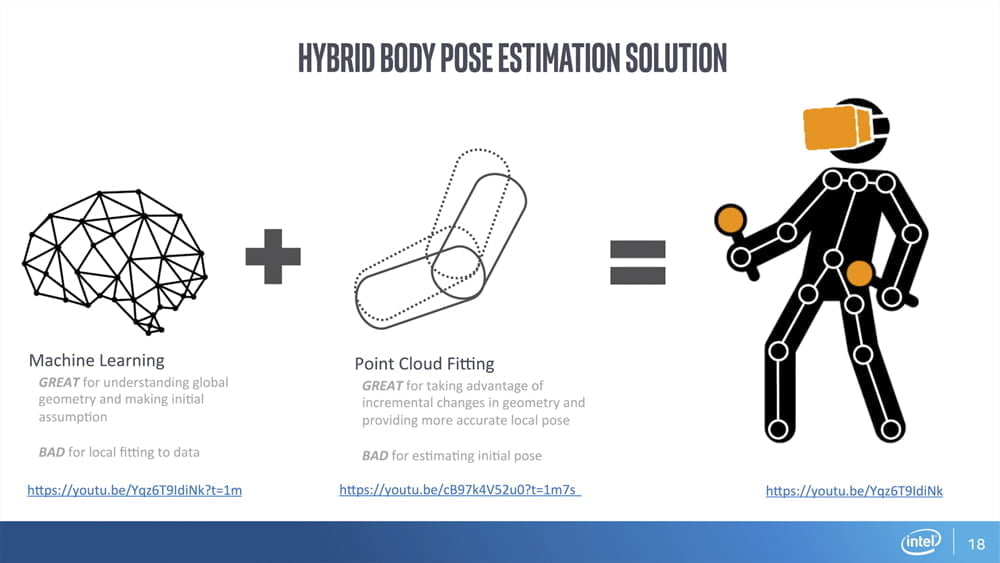

Philip Krejov aus Intels Realsense-Team stellte kürzlich eine rechnerfreundliche Lösung vor, die zwei Ansätze miteinander verbindet: Maschinenlernen aus Tiefenkamera-Daten und sogenannte Modellanpassung.

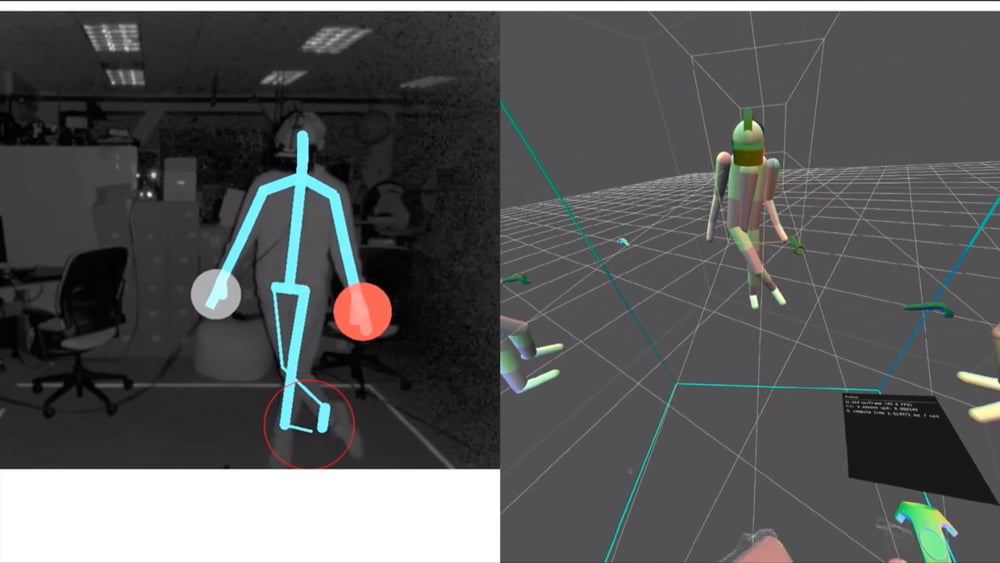

Maschinenlernen hilft, mit Hilfe der Tiefenkameras Geometrie und die aktuelle Pose eines Menschen zu erfassen. Mit der Modellanpassung wird ein digitaler Avatar über die Daten der Realsense-Sensoren gelegt.

Der digitale Avatar funktioniert wie ein hübscher Anzug: Durch ihn können kleine Veränderungen in der Geometrie der gefilmten Person kaschiert und die Pose des Charakters akkurater dargestellt werden – auch bei kurzen Ausfällen des Trackings.

Ein solcher Hybrid-Ansatz benötigt jedoch Millionen Trainingsbilder und viel Rechenleistung.

VR-Hardware erleichtert Maschinenlernen

An dieser Stelle, so Krejov, habe man „geschummelt“: Da sein Team das Tracking für VR entwickelte, konnten neben Kamerabildern auch Brillen- und Controller-Position für das Training genutzt werden. Das reduzierte die nötige Rechenleistung und den Zeitaufwand für das Training stark.

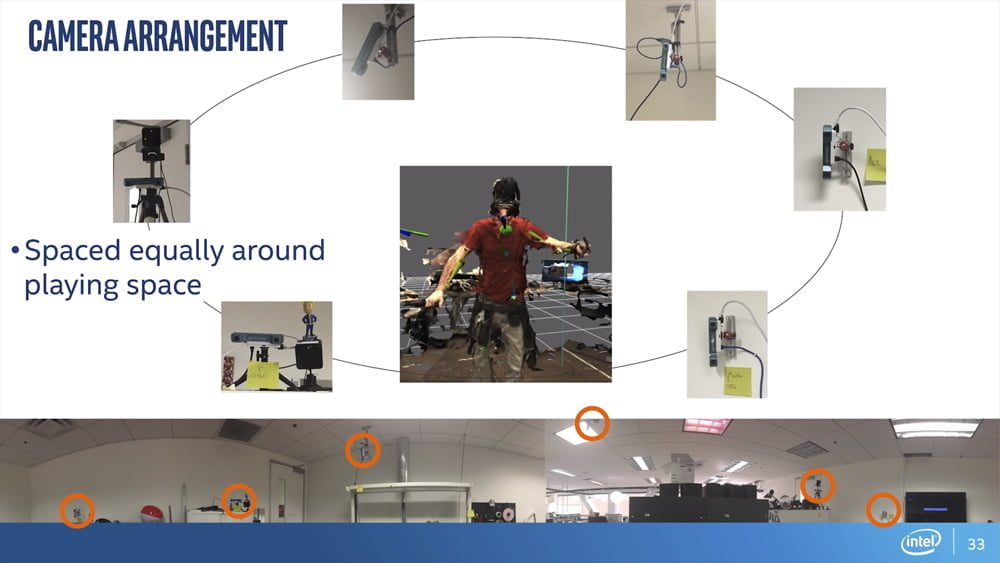

Das neuronale Netz wurde mit den Bewegungsdaten der Brille, der Controller und den Aufnahmen von sechs Realsense-Tiefenkameras trainiert. Diese Kameras nehmen neben Farb- auch Tiefendaten auf. So kann jedem Punkt im Bild eine genaue Position im Raum zugeordnet werden.

Das Kamera-Set erlaubte es Krejov und seinem Team, den sonst aufwendigen Trainingsprozess stark zu vereinfachen. Während bei anderen KI-Algorithmen einzelne, vorbereitete Bilder für das Training genutzt werden müssen, konnte das Team auf die Kombination der Tiefen- und VR-Trackingdaten zurückgreifen.

Die Realsense-Tiefenkameras lieferten in 30 Minuten rund 50.000 aufbereitete Trainingsbilder – ohne dass ein manuelles Vorbereiten notwendig war.

Das Netzwerk lernte anschließend, mit nur einer Tiefenkamera plus VR-Ausrüstung einen kompletten Menschen zu tracken.

Neuronales Netzwerk + Modell = Tracking-Wunder

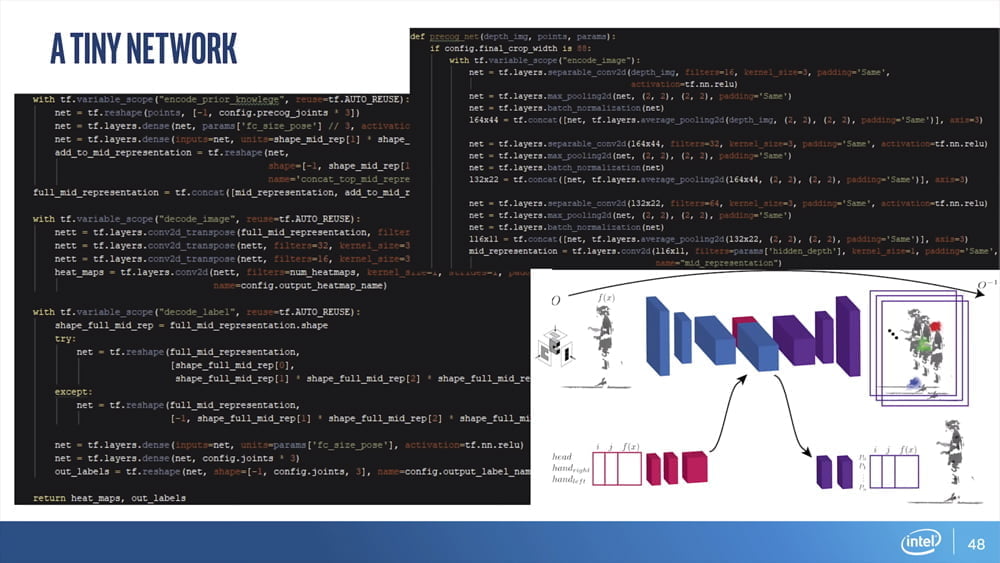

Das so entstandene neuronale Netzwerk hat nur sechs Schichten – Krejov bezeichnet es als „winzig“. Es trackt dennoch genau und läuft mit 200 Bildern pro Sekunde auf einer Intel i7 CPU mit einer GPU-Auslastung von 15 Prozent (Nvidia GTX 1070).

Nachdem das Netzwerk erfolgreich lief, wandte sich das Team dem zweiten Teil der Hybridlösung zu: der Modellanpassung.

Um das Tracking in VR glaubwürdiger zu gestalten, legte die Gruppe ein Modell über die Tracking-Daten des Netzwerks. So wird aus der wabernden Punktewolke ein Avatar, dessen Gelenke den programmierten Regeln gehorcht und der über Gliedmaßen mit der Welt interagieren kann.

![]()

Als Beispiel stellte Krejov ein Bällebad vor, in dem ein Spieler Bälle umhertreten kann.

Krejov betont, dass Intels Deep-Learning-Tracking noch kein fertiges Produkt ist. Informationen zu einer möglichen Veröffentlichung sind nicht bekannt.