Spiking Neural Networks könnten in Zukunft aktuelle Deep Learning Netze ersetzen. Forschende des Human Brain Project zeigen erste Ansätze.

Der große KI-Boom der letzten Dekade ist auf Fortschritte im maschinellen Lernen zurückzuführen, genauer gesagt auf das Deep Learning und die dort verwendeten künstlichen neuronalen Netze. Diese Netze brachten neue Bestleistungen in der Bilderkennung, der maschinellen Verarbeitung natürlicher Sprache oder dem Schachspiel. Wer also heute von Künstlicher Intelligenz spricht, meint meist Deep Learning mit künstlichen neuronalen Netzen.

Doch aktuelle KI-Systeme sind energiehungrig, aufwendig zu trainieren, statisch und oft verhältnismäßig langsam. Von der Flexibilität, Leistungsfähigkeit und Energieeffizienz ihres großen Vorbilds, dem biologischen Gehirn, sind sie weit entfernt.

Neuromorphe Netze: Die Zukunft hängt hinterher

Künstliche neuronale Netze könnten jedoch bald von sogenannten "Spiking Neural Networks" (SNNs / gepulste neuronale Netze) abgelöst werden. Diese sind stärker von ihrem biologischen Gegenstück inspiriert und versprechen schnellere Berechnungen bei deutlich geringerem Energiebedarf.

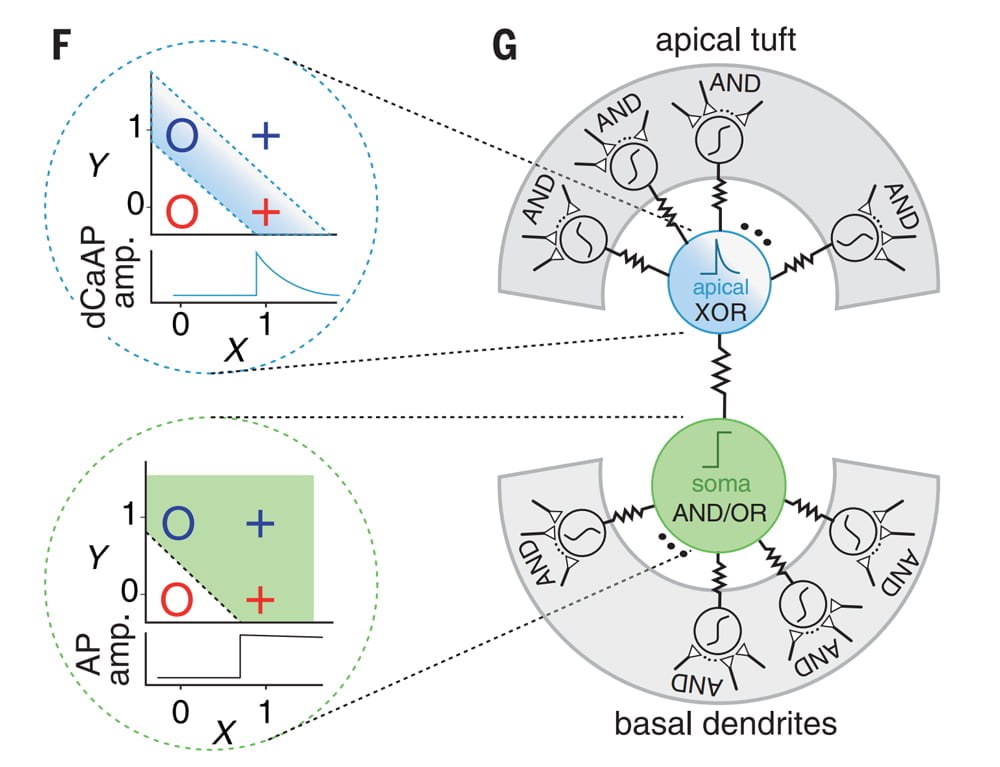

Die namensgebenden Spikes sind Pulse, die die künstlichen Neuronen abfeuern, sobald ein bestimmter Schwellenwert des sogenannten Membranpotenzials überschritten ist. Diese Pulse dienen als Signal, das an verknüpfte Neuronen weitergeben wird. Sie simulieren somit das Aktionspotenzial biologischer Netze.

Erste Modelle stammen bereits aus den 1950ern, doch Spiking Neural Networks konnten in der Praxis bisher nicht mit ihren abstrakten künstlichen Gegenstücken mithalten. Das hat zahlreiche Gründe, darunter die Tatsache, dass der mächtige Backpropagation-Algorithmus erst seit etwa 2018 mit SNNs kompatibel ist. Doch mittlerweile gibt es erste Fortschritte beim Einsatz von SNNs in klassischen Erkennungsaufgaben.

Time-to-first-spike und Backpropagation

Beim sogenannte Neural Coding versuchen Forschende, Kodierungsverfahren zu finden, mit denen das Gehirn Informationen repräsentiert und zwischen Neuronen austauscht. Die Zeit vom Input in ein Neuron oder eine neuronale Schicht zum ersten Puls wird hier TTFS (time-to-first-spike) abgekürzt. Sie gilt als vielversprechender Kandidat für ein Kodierungsverfahren, das besonders energieeffiziente Operationen in SNNs erlaubt.

In einer neuen Forschungsarbeit der Universitäten Heidelberg und Bern nutzen Forscher:innen dieses Kodierungsverfahren, um ein SNN mit bestärkendem Lernen für Erkennungsaufgaben zu trainieren. Ihr System testeten sie anschließend auf einem neuromorphen Chip. Die Arbeit entstand im Rahmen des europäischen Human Brain Projects, das über zehn Jahre das Verständnis des Gehirns vertiefen will, sowie Fortschritte in Neurowissenschaft, Computing und Medizin fördert.

Spiking Neural Network erkennt Yin, Yang und Zahlen

Die Forschenden trainieren ihr SNN mit einer Variante des Backpropagation-Algorithmus, der die Gewichtungen der Verbindungen so anpasst, dass das Timing der Output-Pulse dem gewünschten Muster entspricht.

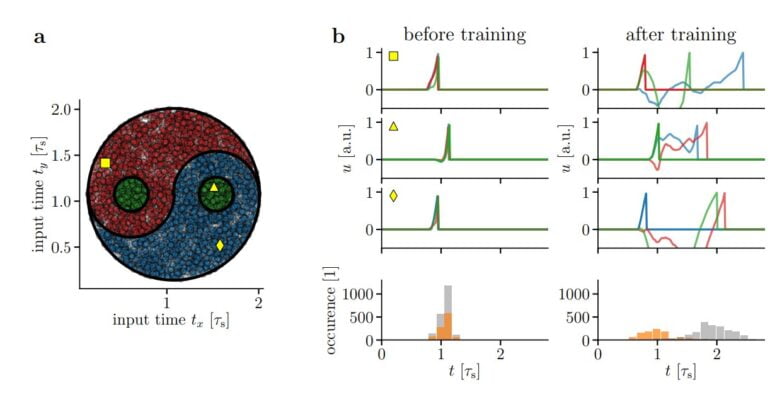

So muss das SNN in einem Beispiel Punkte aus drei Klassen in einem Yin-Yang-Datensatz lokalisieren: Yin, Yang und Kreis. Für jede Klasse gibt es ein Output-Neuron, das nach dem überwachten Trainingsprozess als Erstes feuert – sofern der Input-Punkt aus der entsprechenden Klasse stammt.

Nach dem Training erreicht das SNN bei der Punkt-Erkennung eine Genauigkeit von knapp 96 Prozent, ein künstliches neuronales Netz etwa 98 Prozent, ein linearer Klassifizierer ohne neuronales Netz lediglich 64 Prozent. In der MNIST-Klassifizierungsaufgabe, in der das System handgeschriebene Zahlen erkennen muss, erreicht das SNN 97,1 Prozent Genauigkeit.

Implementierung auf neuromorphe Hardware zeigt Potenzial

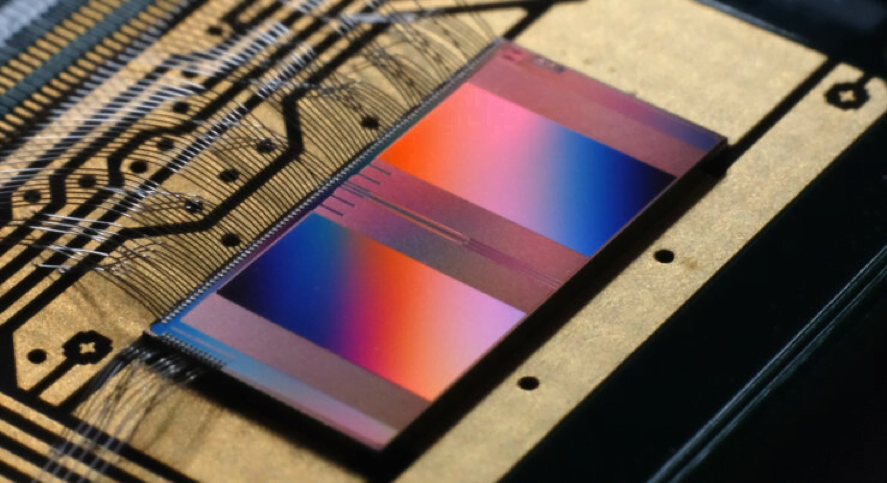

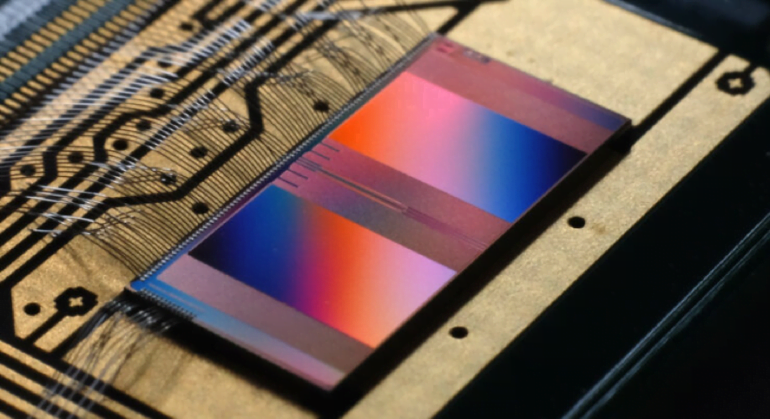

Die Forschenden gehen einen Schritt weiter und implementieren ihr SNN auf dem neuromorphen Chip BrainScaleS-2. Dieser und andere neuromorphe Chips wie das Spinnaker-System oder Intels Loihi-Chips erlauben Forschern und Forscherinnen, mit echten physikalischen Pulsen zu arbeiten, statt diese bloß auf einer Von-Neumann-Architektur zu simulieren. Ferner sind sie bis zu 1000-mal schneller als ihre biologischen Gegenstücke.

Die neuromorphen Chips stellen jedoch auch eine Herausforderung dar, da sich durch den Fertigungsprozess einzelne Neuronen unterscheiden können und es zusätzlich zu Pulsverlusten kommt.

Das SNN der Forscher:innen aus Heidelberg und Bern schlägt sich jedoch auch auf BrainScaleS-2 gut und erreicht eine Genauigkeit von etwa 95 Prozent beim Yin-Yang-Test und 96,9 Prozent beim MNIST-Test. Für die Forschenden ist das ein deutlicher Hinweis, dass der verwendete Algorithmus robust ist und mit den Imperfektionen physikalischer Hardware klarkommt.

100-mal geringerer Energieverbrauch pro Klassifikation

Die beste Nachricht: Das System funktioniert und ist noch dazu schnell und energieeffizient. Für 10.000 MNIST-Testsamples benötigt das SNN auf BrainScaleS-2 unter einer Sekunde, bei einer etwas niedrigeren Auflösung kann es bei gleichbleibender Genauigkeit sogar 20.000 Bilder verarbeiten. Dann sinkt der Energieverbrauch pro Klassifikation auf winzige 8.4 µJ.

Das ist laut der Forschungsarbeit knapp 100-mal weniger Energieaufwand pro Klassifikation als ein CNN auf einer Nvidia Tesla P100 für die Klassifikation benötigt.

Weitere Verbesserungen im SNN könnten die Klassifikationsrate außerdem vervierfachen und den Energieverbrauch um den Faktor drei senken, heißt es in der Arbeit. Die SNN-Lösung eigne sich daher gerade für Edge-Computing-Aufgaben, bei denen besonders wenig Energie aufgewendet werden soll.

Als Nächstes will sich das Forschungsteam Echtwelt-Szenarien zuwenden, in denen das SNN online von Daten etwa eines Roboters lernen soll.