Graphcore stellt für KI-Berechnungen spezialisierte Chips her. Nach internen Benchmarks wähnt sich das Start-up vor Marktführer Nvidia.

Graphcore greift den Chip-Giganten Nvidia an: Das 2016 gegründete KI-Chip Start-up stellte seine neuen KI-Computing-Lösungen IPU-M2000 und IPU-POD64 vor, die auf den von TSMC für Graphcore produzierten KI-Chip Colossus Mk2 GC200 IPU setzen.

Der Mk GC200-Chip wird im 7nm-Prozess hergestellt. Er trägt mehr als 59,4 Milliarden Transistoren auf einem 823mm² großen Chip mit 1.472 separaten IPU-Kernen.

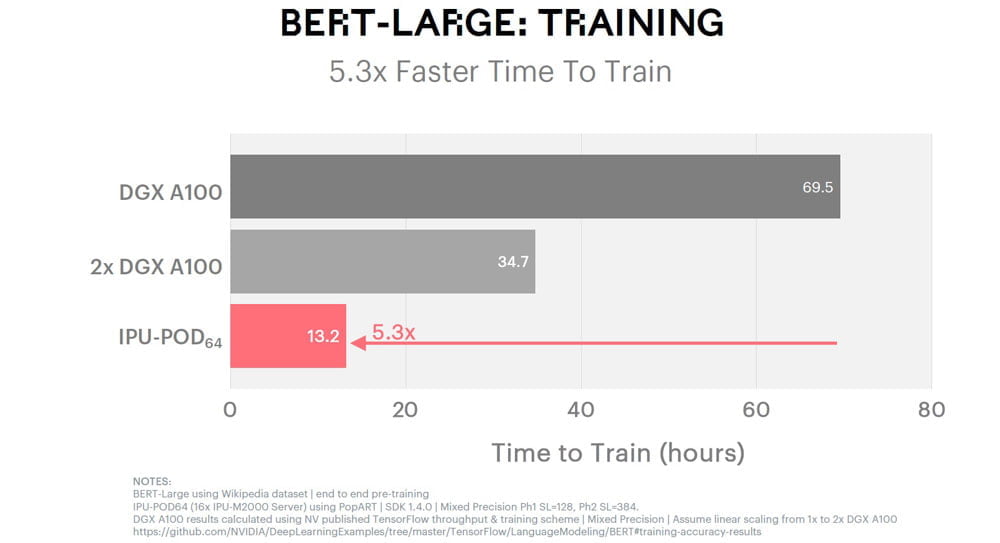

Zusammen mit der Bekanntgabe der weltweiten Verfügbarkeit veröffentlicht Graphcore interne Benchmarks, in denen die eigenen Computing-Lösungen mit Nvidias aktuell schnellstem KI-Chip A100 GPU verglichen werden.

So soll das IPU-POD64, bestehend aus 16 IPU-M2000-Servern mit jeweils vier Mk2 GC200-Chips, Googles großes KI-Sprachmodell BERT 5,3 Mal schneller trainieren als Nvidias DGX A100 mit acht Nvidia A100 GPUs.

Beim Training der Bildanalyse Resnet-50 sieht sich Graphcore bei der Menge verarbeiteter Daten pro Sekunde um den Faktor 2,6 vorne und bei der Ausführung von Resnet-50 um den Faktor 4,6.

Ähnliche Leistungsdaten gibt Graphcore auch für andere Bildanalyse-Systeme oder LSTM-Netze aus. Für Letztere gibt der Hersteller sogar einen 600-fachen Durchsatz an im Vergleich zu Nvidias schnellstem Chip.

Nvidia kritisiert Äpfel-mit-Birnen-Vergleich

Paresh Kharya, Senior-Produktmanager bei Nvidia für GPU-beschleunigtes Computing, kritisiert die Graphcore-Vergleiche. Das Start-up stelle Algorithmen und Systemkonfigurationen nebeneinander, die man nicht vergleichen könne.

Außerdem fehlten bei den Benchmark-Angaben wichtige Details wie die Genauigkeit, auf die die Modelle trainiert wurden. Bei einheitlicher Methodik biete eine Nvidia A100-GPU eine wesentlich höhere Leistung und Vielseitigkeit sowie ausgereifte Software, sagt Kharya.

Chris Tunsley, Marketing-Direktor bei Graphcore, verteidigt die eigenen Messungen: „Es gibt viele Variablen, für die man normalisieren kann, wenn man einen Produktvergleich macht, aber wir sehen nicht, dass die Anzahl der Chips die Kunden interessiert. Unsere Kunden bewerten die Leistung pro US-Dollar.“

Der naheliegendste Vergleich nach Preis und Energieverbrauch sei daher ein Graphcore IPU-M2000-Server gegen ein Nvidia DGX A100-Pod. Nvidias Pods kosten ab knapp 200.000 US-Dollar, ein Graphcore-Server dagegen 32.450 US-Dollar zuzüglich CPU-Server für einige Tausend US-Dollar.

Offene Graphcore-Benchmarks im ersten Quartal 2021

Kevin Krewell, Analyst beim US-Tech-Berater Tirias Research, nennt Graphcores Zahlen irreführend und warnt zur Skepsis: „Die Verwendung von Leistung pro US-Dollar ist kein gutes Maß für die Anschaffung von KI-Systemen, da es viele andere Faktoren für die Betriebskosten gibt.“ Oft sei etwa die Leistung im Verhältnis zum Platzverbrauch im Serverschrank wichtig.

Eine endgültige Antwort, was an Graphcores Benchmarks dran ist, wird es wohl im ersten Quartal 2021 geben. Das Start-up hat mit der Vorstellung seiner neuen KI-Hardware-Produkte die Mitgliedschaft bei MLCommons bekanntgegeben. Das offene Konsortium ist das Kontrollgremium der KI-Benchmarks MLPerf, die die Leistung verschiedener Chip-Architekturen unabhängig von Herstellermessungen transparent machen sollen.

Via: Graphcore, EETAsia