Im März 2017 bezwang Googles KI-Programm AlphaGo den Weltmeister im chinesischen Go-Spiel. Nun verlegen sich die KI-Entwickler auf das PC-Spiel Starcraft II. Deepmind und Blizzard veröffentlichten ein Toolkit, das zur Grundlage für Wettkämpfe zwischen Deepmind und menschlichen Spielern werden könnte.

Das Herzstück der Software ist eine Programmierschnittstelle, die KI-Agenten den gleichen Einschränkungen wie Menschen unterwirft. So bleiben unausgekundschaftete Gebiete der KI verborgen und sie kann nicht unendlich schnell klicken.

Lernen soll die KI mit Hilfe des Trial-and-Error-Prinzips, einer halben Million abgespeicherter, realer Spielmatches und einer Reihe von Minispielen, in der sie isolierte Spielmechaniken wie Erkundung und Ressourcenabbau einstudieren kann.

Ein Spiel wie Starcraft ist ein ideales Forschungsumfeld für künstliche Intelligenz, weil sich Spiele beliebig oft wiederholen lassen und viel Anschauungsmaterial vorhanden ist. Laut dem Deepmind-Forscher Oriol Vinyals kann die KI besonders viel vom "Nebel des Krieges" lernen, einer Spielmechanik, die unerforschte Gebiete in undurchdringliches Dunkel hüllt. Vinyals arbeitet an dem Projekt und spielte früher Starcraft auf professionellem Niveau.

Eine KI lernt, sich zu erinnern

"Es ist entscheidend, dass eine KI sich erinnert, wo sie eine feindliche Einheit sah, sodass sie das Gebiet basierend auf diesen Daten auskundschaftet", sagt Vinyals gegenüber The Verge. Um in Starcraft zu gewinnen, müssen Spieler berücksichtigen, was der Gegner nicht sieht und weiß. Das sei eine neue Herausforderung, die bei Schach und Go nicht existiert. Vinyals sagt, dass eine KI mit Erinnerungsvermögen viele sinnvolle Anwendungsszenarien hätte.

Deepmind und Blizzard haben noch kein Interesse daran bekundet, offizielle Wettkämpfe zwischen der KI und menschlichen Spielern durchzuführen. Professionelle Starcraft-Spiel wie Byun Hun Woo können es jedoch kaum erwarten, Deepmind herauszufordern. "Ich glaube nicht, dass eine KI einen professionellen Spieler besiegen kann, zumindest nicht während meiner Lebenszeit," sagt Woo gegenüber Technology Review.

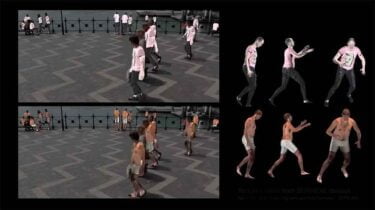

Doch Deepmind könnte die Starcraft-Spieler ebenso überraschen wie den Go-Meister Lee Sedol, als die KI ungereimte Spielzüge machte, die sich später als spielentscheidend erwiesen. Laut Vinyals gibt es bereits Beispiele für Spielmethoden, die von der KI entwickelt wurden, um Abläufe wie das Auskundschaften und den Ressourcenabbau zu optimieren.