Wenn Computer informieren, dann ist die Information immer neutral und objektiv. Oder nicht? Ein Irrglaube, sagt Google, und erklärt, wie Computer Vorurteile entwickeln.

Die Künstliche Intelligenz lernt nicht eigenständig und losgelöst vom Menschen, sondern basierend auf dessen Vorgaben und Daten. Beim maschinellen Lernen suchen Computer Muster in tausenden von Menschen klassifizierten Datensätzen. Stecken in diesen Datensätzen Vorurteile, werden sie vom Computer übernommen.

Laut Google gibt es drei wesentliche Arten an Vorurteilen, die Maschinen von Menschen überliefert bekommen. Beim Interaktionsvorurteil wird der Algorithmus unmittelbar durch eine eingeschränkte menschliche Vorgabe in einem ansonsten komplexen Umfeld beeinflusst.

Fragt der Computer beispielsweise nach einem Schuh, zeigt der Nutzer ihm die Art von Schuh, die er selbst bevorzugt - womöglich einen Herrenschuh. Für den Computer ist in diesem Moment nicht offensichtlich, dass Damenschuhe oder ein Turnschuh ebenfalls Schuhe sind. Er bevorzugt daher zukünftig den Herrenschuh.

Laut Google ist das ein typisches Beispiel dafür, wie bei maschinellen Lernverfahren Vorurteile entstehen. Nur weil Information auf Daten basiere, so Google, sei sie nicht automatisch neutral. Selbst bei guten Absichten sei es "unmöglich, dass Menschen sich von ihren Vorurteilen lösen".

Computer können rassistisch oder sexistisch sein

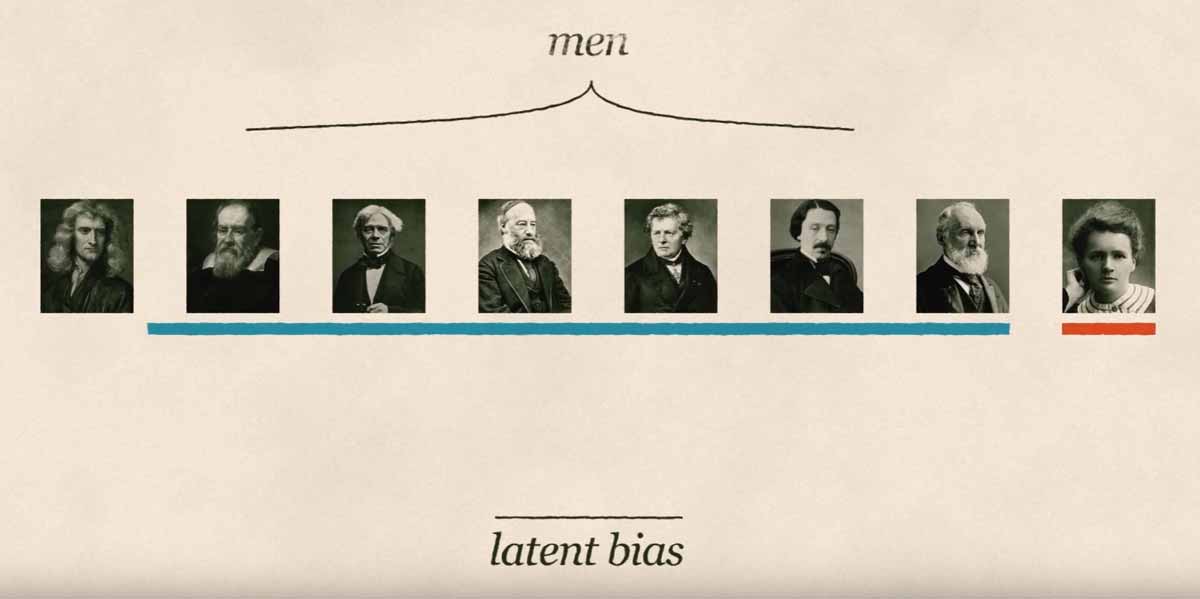

Beim sogenannten latenten Vorurteil verknüpft der Computer Ideen mit äußerlichen oder sozialen Merkmalen wie Rasse, Geschlecht oder Gehalt. Bringt man dem Computer anhand von Bildern historischer Physiker bei, wie Physiker aussehen, wird er den Beruf anschließend eher mit Männern als mit Frauen verknüpfen.

Eine weitere Ursache für maschinelle Vorurteile ist die Stichprobenverzerrung. Das Wort "Doktor" könnte häufiger mit Männern verbunden werden, weil in Fotodatenbanken mehr entsprechend verschlagwortete Bilder von männlichen Ärzten liegen.

Laut Google ist das Computer-Vorurteil ein "komplexes Problem, für das es keine magische Lösung gibt". Als möglichen Lösungsansatz fragt das Unternehmen ergänzendes Nutzer-Feedback im Kontext von Informationen ab - zum Beispiel bei der Anzeige von Suchergebnissen - um Vorurteile im Algorithmus aufzudecken.

Da dabei wiederum das menschliche Urteilsvermögen berücksichtigt wird, besteht allerdings die Gefahr, dass sich der Prozess im Kreis dreht.