Google und die Universität Berkeley zeigen, dass effizienteres Training von riesigen KI-Modellen möglich ist.

Laut einer Studie von OpenAI von 2018 verdoppelt sich die Leistung von KI-Systemen alle dreieinhalb Monate. Möglich wird das durch immer mehr Rechenleistung und spezialisierte Hardware.

Diese Entwicklung geht nicht spurlos am CO2-Fußabdruck der KI-Forschung vorbei: 2019 zeigte eine Studie, dass die Klimabelastung durch die damals häufigsten KI-Modelle für Sprachverarbeitung bis zu fünfmal größer als der eines Autos über dessen komplette Lebensspanne ist, nämlich knapp 284 Tonnen CO2.

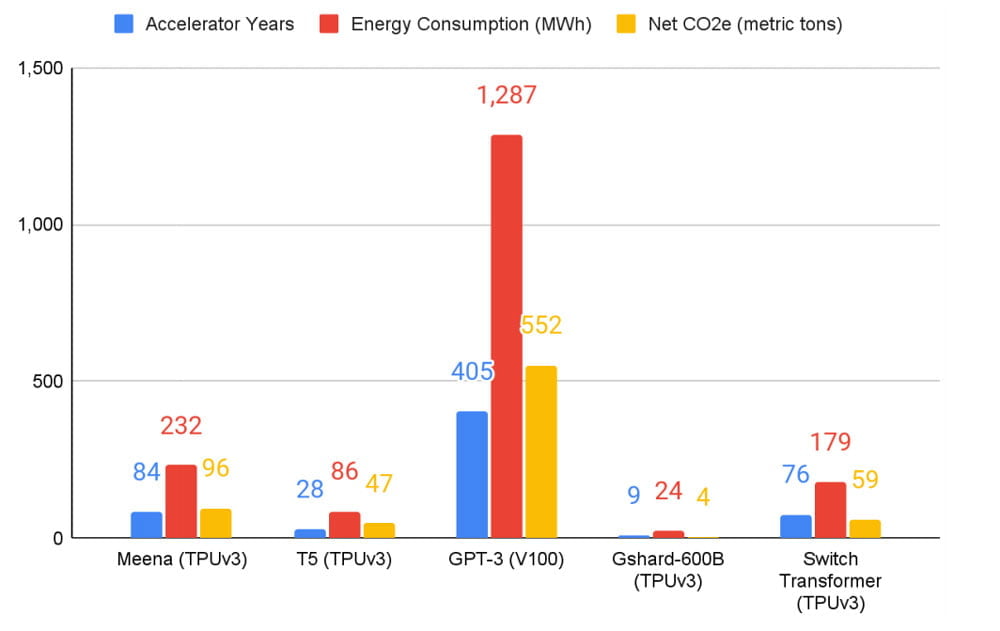

In einer neuen Forschungsarbeit untersuchten jetzt Forscher von Google und der Berkeley-Universität Kalifornien den Fußabdruck der fünf großen Text-KIs T5, Meena, GShard, Switch Transformer und GPT-3. Sie wollen Wege aufzeigen, die CO2e-Emissionen (CO2-Äquivalente) von KI-Training zu reduzieren.

Bis zu 1000-fache Einsparungen möglich

Die Forscher kommen zu dem Schluss, dass KI-Training deutlich weniger Emissionen erzeugt, als es in der zuvor zitierten Studie beschrieben steht. So seien etwa die für das KI-Training genutzten Cloud-Datenzentren etwa zweimal energieeffizienter als klassische Datenzentren.

Eine Forschungsarbeit in Science zeige außerdem, dass der globale Energiebedarf von allen Datenzentren seit 2010 nur sechs Prozent und die verfügbare Rechenleistung um 550 Prozent gestiegen sei.

Je nach Trainings- oder Inferenzmethode könne der Energieverbrauch von neuronalen Netzen um den Faktor zehn schwanken. Die geografische Lage der Rechenzentren könne außerdem die CO2e-Emissionen um den Faktor fünf bis zehn reduzieren, je nach Verfügbarkeit erneuerbarer Energien. KI-spezialisierte Hardware wie Googles TPUs seien außerdem zwei- bis fünfmal effizienter als generische Hardware.

Über die Wahl des neuronalen Netzes, des Datencenters und der Prozessoren könne der Fußabdruck so 100- bis 1000-fach reduziert werden, schreiben die Forscher.

Schmutzfink GPT-3

Sauber sind die KI-Modelle dennoch nicht: Googles Modelle produzierten laut den Forschern zusammen 200 Tonnen CO2e-Emissionen, OpenAIs GPT-3 allein 552 Tonnen.

Wie solche Zahlen zu bewerten sind, ist eine der vielen ethischen Diskussionen in der KI-Forschung. Denn die Menschen, die am meisten unter den Folgen des Klimawandels leiden, profitieren umgekehrt nicht von englischsprachigen Text-KIs, betonte etwa die von Google gefeuerte KI-Forscherin Timnit Gebru in ihrer Forschungsarbeit über große Sprachmodelle.

Die Forscher hoffen, Emissionen durch KI-Training in Zukunft weiter reduzieren zu können. Sie liefern dafür Vorschläge: In Zukunft solle der Energieverbrauch und die CO2e-Emission in allen KI-Forschungsarbeiten veröffentlicht werden und KI-Konferenzen sollten Arbeiten auszeichnen, die Effizienzgewinne erzielen.

Titelbild: Google | Via: Arxiv