Falls Künstliche Intelligenz zukünftig tatsächlich Wirtschaft und Gesellschaft umkrempelt, dann wird den Daten für das KI-Training ein besonderer Wert zuteil. Wie schützen wir uns vor schlechten Trainingsdaten oder bewahren die Rechte der Ersteller guter Trainingsdaten?

Zwar sind viele vortrainierte KI-Modelle und Trainingsdatensätze frei verfügbar. Aber je spezifischer die zu entwickelnde KI sein soll, desto genauer müssen auch die Trainingsdaten zusammengestellt werden.

Menschen müssen definieren, welche Inhalte im Datensatz stecken sollen. Dieser Schritt ist für das KI-Training ausschlaggebend, denn auf Basis dieser Daten wird die KI später ihre Entscheidungen fällen.

Ein gut zusammengestellter Datensatz mit seltenen Trainingsdaten könnte demnach einen hohen Wert haben.

Ist der Datensatz hingegen schlecht zusammengestellt, verfehlt die KI ihre Ziele, oder, schlimmer noch, sie produziert Ergebnisse, die zwar oberflächlich korrekt erscheinen, in denen aber Vorurteile stecken.

KI-Trainingsdatentracking gegen Diebstahl und Vorurteil

KI-Forscher von Facebook entwickeln jetzt eine Methode, mit der nachgewiesen werden kann, mit welchen Trainingsdaten eine Künstliche Intelligenz trainiert wurde.

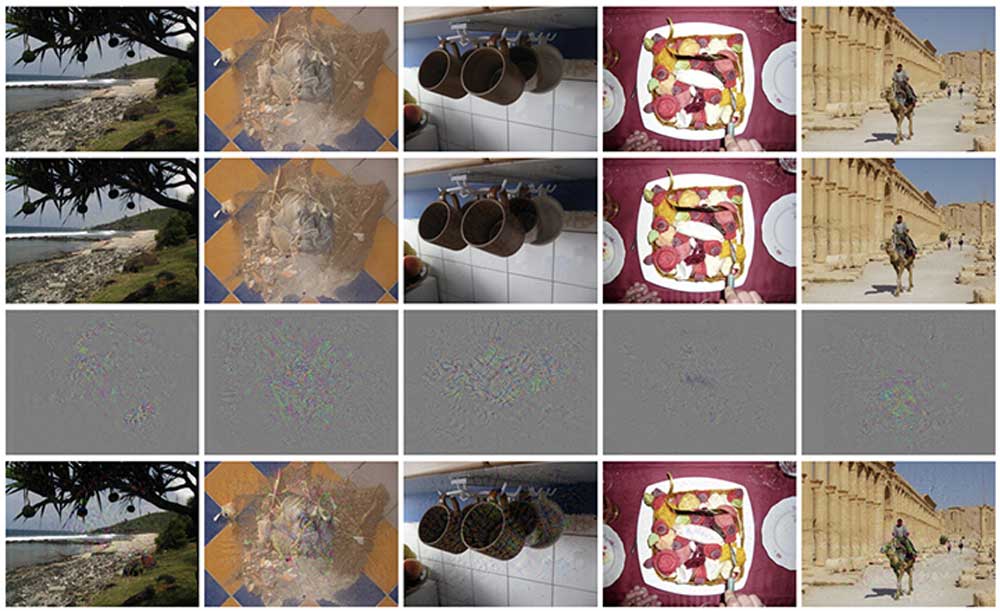

Das Prinzip folgt dem eines Wasserzeichens: In ein Bild oder Video werden minimale Veränderungen eingefügt, die für das bloße Auge nicht sichtbar sind und die Genauigkeit einer Bildanalyse-KI nicht beeinflussen sollen.

Ist dieses Wasserzeichen in einen Datensatz implementiert, kann es "mit hoher Wahrscheinlichkeit" im fertig trainierten KI-Modell nachgewiesen werden. So wäre offensichtlich, ob ein KI-Modell beispielsweise mit gestohlenen oder vorurteilsbehafteten Daten trainiert wurde. Die Blackbox KI würde dadurch ein stückweit transparenter.

Die Forscher sprechen bei ihrer Markierung auch von "radioaktiven Daten", analog zu entsprechenden Markern in der Medizin, die erst unter Röntgenstrahlung sichtbar werden. Laut der Forscher reicht es, wenn nur ein Prozent der gesamten Trainingsdaten markiert ist. Es sei "extrem schwierig", zu erkennen, ob ein Datensatz markiert ist oder übertragene Markierungen von einem trainierten KI-Modell zu entfernen.