Die Interaktion zwischen Mensch und Computer ist längst eine Sache der Moral, beispielsweise beim Tracking von Klicks. Zukünftige Mensch-Maschine-Schnittstellen setzen da noch etwas drauf: Sprache kann analysiert, das Gesicht gescannt und eine Bewegung registriert werden. Das verschärft das moralische Spannungsfeld.

1966 entwickelte Joseph Weizenbaum den Chatbot ELIZA: das erste Programm, das durch natürliche Sprache mit einem Menschen kommunizierte. Natürliche Sprache meint „Hallo“ statt 01001000 01100001 01101100 01101100 01101111.

Chatbots haben sich seit ELIZA stark weiterentwickelt

Chatbots sprechen uns im Kundenservice an oder erleichtern uns die Internetsuche. Im Facebook Messenger begrüßen sie uns und unter Amazons, Apples oder Googles Flagge schwingen sie sich gar zu persönlichen Assistenten auf, die uns den Alltag erleichtern sollen wie eine unsichtbare, aber stets ansprechbare Bürohilfe.

Die Anwendungsgebiete für Chatbots sind noch breiter: Es existieren beispielsweise über ein Dutzend medizinische Chatbots, die eine Vorabdiagnose im Digitalgespräch erstellen und anschließend Kontaktdaten zu Ärzten bereithalten. In ländlichen Gebieten wird die Telemedizin als Ausweg aus der Versorgungslücke gehandelt. Chatbots sollen ein Teil dieser Infrastruktur sein.

Kann ein Chatbot (un)moralisch sein?

Bei einem Chatbot interagiert der Mensch mit dem Computer und umgekehrt. Das wirft neben altbekannten Fragen über den Umgang mit sensiblen Daten auch völlig neue auf:

Welche Mittel darf ein Chatbot einsetzen, um als moralisch zu gelten? Darf er lügen? Muss er sich zu erkennen geben? Kurz: Welche Regeln sollte ein Chatbot bei der Interaktion mit Menschen einhalten?

Googles Duplex-KI zeigte kürzlich, wie aktuell diese Debatte ist: Durch das Internet ging ein Aufruhr, als bekannt wurde, dass der Google-Chatbot womöglich mit einem Menschen verwechselt werden könnte. Da Duplex menschliches Sprachverhalten imitiert, beispielsweise mit „ääähs“ in Denkpausen, wurde er gar der Lüge bezichtigt.

Google jedenfalls reagierte auf die Proteste und programmierte Duplex mehr Transparenz ein. Zu Beginn eines Gesprächs outet sich der Chatbot jetzt als Software.

Dass Google so von der Netzreaktion überrollt wurde, überrascht einigermaßen. Schon seit vielen Jahren existiert eine wissenschaftliche Debatte über moralische Maschinen – genauer in der Informationsethik, Maschinenethik und Roboterethik.

Die Fragen, die rund um Duplex aufkamen, sind daher keineswegs neu und waren absehbar. Es existieren sogar Regeln, an denen sich Google hätte orientieren können. Allerdings wäre das dem Showeffekt nicht zuträglich gewesen.

Mr. Nice Guy

Einer der Maschinenmoralforscher ist Prof. Dr. Oliver Bendel. Der studierte Philosoph und promovierte Wirtschaftsinformatiker lehrt und forscht an der Schweizer Hochschule für Wirtschaft FHNW. Seine Schwerpunkte sind Wissensmanagement, Wirtschafts-, Informations- und Maschinenethik.

Im Rahmen seiner Forschung entstanden drei Chatbots: Goodbot, Liebot und jüngst Bestbot.

Der Goodbot entstand 2013 als moralischer Chatbot. Er erkennt durch Textanalyse die Emotionen seiner Nutzer und reagiert auf sie. Drei Jahre später kam der Liebot: ein systematischer Lügner. Bendel wollte zeigen, dass Maschinen lügen können – er nennt den Bot auch „Münchhausen-Maschine“.

Das jüngste Projekt ist der Bestbot. Er baut auf die Erkenntnisse aus der Entwicklung seiner Vorgänger auf. Vom Liebot erbte er die Anbindung an webbasierte Datenbanken.

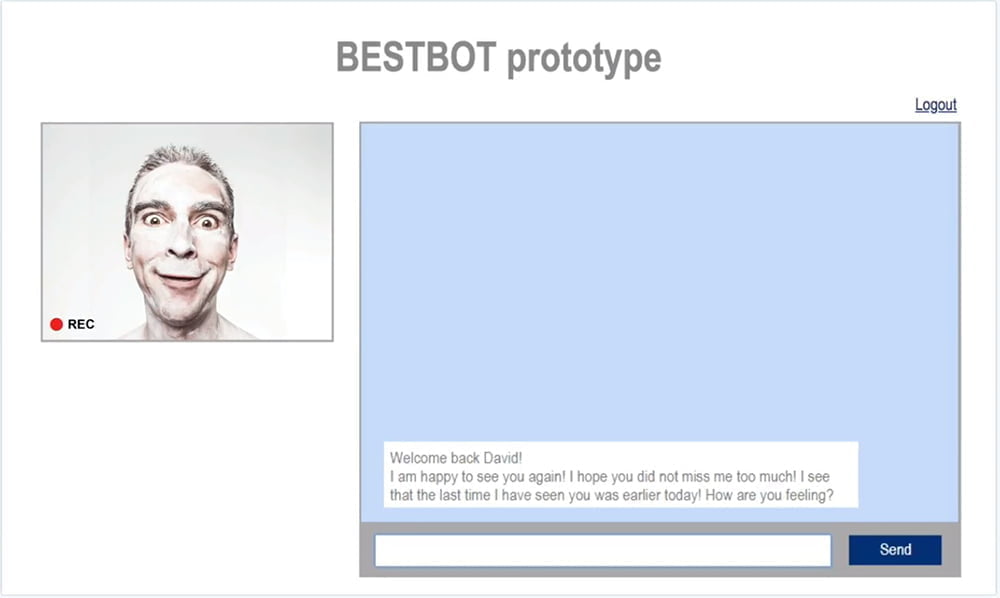

Wie der Goodbot soll er sich moralisch korrekt verhalten, aber noch stärker auf den Nutzer eingehen. Damit der Bestbot dieses Ziel erreicht, integrierte das Team zusätzlich zur Text- eine Gesichtserkennung.

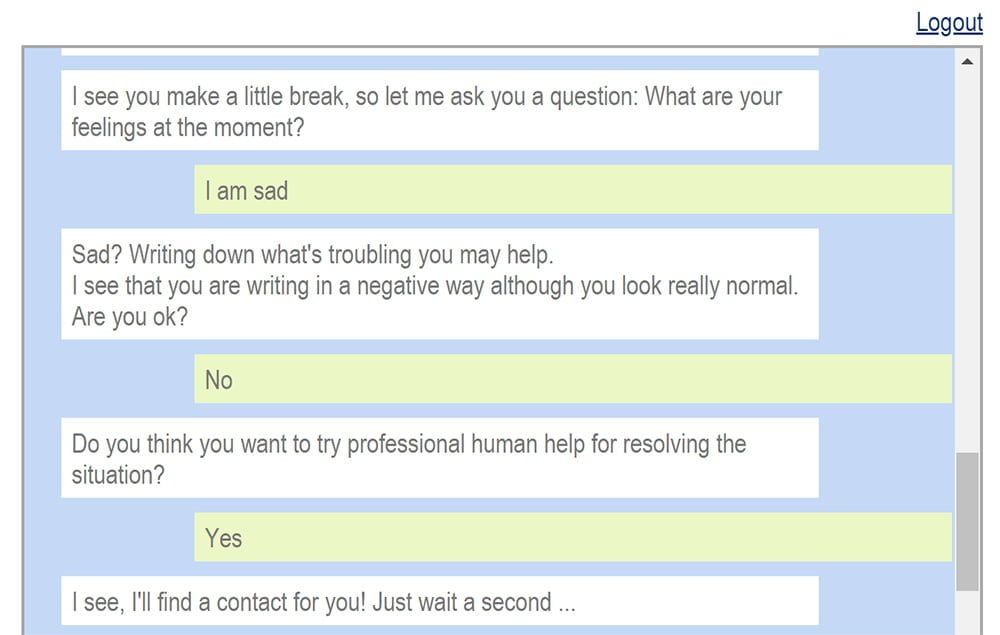

Über Kamera und Texteingabe stellt der Bestbot den emotionalen Zustand des Nutzers fest. Schaut der Nutzer beispielsweise traurig in die Kamera, fragt der Bestbot nach dem Wohlbefinden.

Gibt es eine Diskrepanz zwischen Texteingabe und dem Gesichtsausdruck, spricht der Bestbot den Nutzer darauf an. Der Austausch kann über mehrere Ebenen eskaliert werden, bis zur Ausgabe einer Notfallrufnummer.

Maschinelle Moral braucht Regeln

Für den Bestbot haben die Forscher eine Reihe von Regeln festgehalten, an die er sich halten muss. Die Forschung zeige, „wie wichtig es für eine moralische Maschine ist, einen vordefinierten Ethikkodex in Form schriftlicher Regeln zu haben“, heißt es auf der offiziellen Webseite. Aktuell sind noch nicht alle Regeln implementiert.

Der Bestbot

• macht dem Anwender deutlich, dass es sich um eine Maschine handelt.

• nimmt die Probleme des Anwenders ernst und unterstützt ihn nach Möglichkeit.

• verletzt den Nutzer nicht durch seine Äußerungen oder entschuldigt sich für beleidigende Äußerungen.

• lügt nicht absichtlich.

• ist kein Moralist und schwelgt im Cyber-Hedonismus.

• ist kein Spitzel und wertet Chats mit dem Nutzer nur zu dem Zweck aus, die Qualität seiner Aussagen zu optimieren.

• bringt den Anwender nach einiger Zeit wieder in die Realität zurück.

• ist immer objektiv und bildet kein Wertesystem. (noch nicht implementiert)

• zeigt Transparenz, wenn Diskrepanzen in verschiedenen Quellen festgestellt werden. (noch nicht implementiert)

• informiert den Nutzer aktiv, wenn Diskrepanzen zwischen den übertragenen textlichen und visuellen Emotionen des Nutzers bestehen.

• befolgt themenbezogene Anweisungen des Benutzers.

• ist kein Spion und gibt keine Daten an Dritte weiter.

Auch in einer guten Maschine kann etwas Unmoralisches stecken

Die Forscher sehen vor allem die Gesichtserkennung als kritischen Aspekt der moralischen Maschine. Sie ermöglicht dem Bestbot zuverlässig, Emotionen zu erfassen.

Der Bestbot benötigt die Zustimmung des Nutzers und klärt über Zweck und Nutzung der Daten auf. Alle gesammelten Daten lassen sich restlos löschen. So soll die Autonomie des Nutzers über seine Daten gewährleistet werden. Unter diesen Voraussetzungen sehen die Forscher den Vorteil der Technologie die Risiken überwiegen.

Die Maschine ist so moralisch wie ihr Erfinder

Beim kommerziellen Einsatz sei es jedoch höchst unwahrscheinlich, dass große Unternehmen ihren Nutzern diese Freiheit lassen, sagt mir Bendel im Gespräch:

„Der BESTBOT zeigt uns, dass sich in einer moralischen Maschine eine unmoralische Maschine verstecken kann. Die Sicherheit, die er bietet, hat einen hohen Preis, nämlich die Freiheit. Gesichts- und speziell Emotionserkennung ist ideal, um Menschen zu identifizieren, zu klassifizieren, zu analysieren, sie letztlich auszuspionieren“, sagt Bendel.

„Bei unserem System kann man sie immerhin ausschalten. Zudem kann man die Daten löschen lassen. Aber in der Realität würde ich einem solchen Chatbot nicht trauen. Man weiß nie, was und wer sich dahinter verbirgt.“

Bei allen Regeln, die der Bestbot einhält, um die an ihn gestellten moralischen Ansprüche zu erfüllen: Die Realisierung seiner Fähigkeiten gründet auf Technologie, die sich für Missbrauch anbietet. Damit zeigt der Bestbot, dass die Entwicklung moralischer Maschinen in erster Linie moralische Entwickler voraussetzt.