Googles neues Robotersystem setzt auf ein Sprachmodell zur Steuerung. Dank innerer Monologe kann das System flexibler mit seiner Umgebung interagieren.

Flexible Roboter, die einmal mehrere Aufgaben in der echten Welt erfüllen sollen, müssen ein großes Repertoire an grundlegenden Fähigkeiten besitzen und deren Einsatz planen können. Dazu gehört auch, dass sie erkennen, wann sie ihr Vorgehen ändern müssen, weil eine bestimmte Handlung oder ein Plan nicht erfolgreich sind.

Diese Planung, konstantes Wahrnehmungsfeedback und die Steuerung des Systems auf allen Ebenen sind einige der Teilaufgaben, die ein verkörperter Agent nahtlos miteinander kombinieren muss, um intelligent in seiner Umwelt zu handeln.

KI-Forschende versuchen diese Herausforderungen mit verschiedenen Ansätzen zu lösen. Viele setzen auf das bestärkende Lernen, um Robotern die Fortbewegung beizubringen - doch für Planung und Flexibilität braucht es mehr.

Metas KI-Chef Yann LeCun stellte etwa im März seine Pläne für eine autonome Künstliche Intelligenz vor. Die soll zwar vorerst nicht in einem Roboter verortet sein, hat aber sonst alle Bausteine für einen flexiblen Agenten, der die Fähigkeit zur Planung besitzt.

Große Sprachmodelle für verkörperte Agenten

Zentral in LeCuns Modell ist ein Weltmodell, in dem innerhalb des KI-Systems ein grundlegendes Verständnis der Welt verortet sein soll. Diese Weltmodelle existieren bisher nicht.

Ein Grund davon auszugehen, dass sie technisch möglich sein werden, lieferten in den letzten Jahren große Sprachmodelle. Diese Modelle können Text generieren und verarbeiten. Durch das Training mit gigantischen Mengen Text verfügen sie über ein reichhaltiges Wissen über die Welt. In einigen Beispielen zeigen sie zudem eine rudimentäre - wenn auch nicht stabile - Fähigkeit zur Schlussfolgerung, etwa in Googles PaLM-Experimenten.

KI-Forschende unter anderem von Googles Robotik-Abteilung stellen daher die Frage: Können Sprachmodelle als Argumentationsmodelle dienen, die mehrere Feedback-Quellen kombinieren und zu interaktiven Problemlösern für verkörperte KI-Aufgaben etwa in Robotern werden?

Andere Arbeiten zeigten bereits, dass Sprachmodelle für die Planung von Handlungen in Robotern eingesetzt werden können. Das Google-Team stellt sich jetzt die Frage, ob die Fähigkeiten von Sprachmodellen auch genutzt werden können, um umzuplanen, wenn etwas schiefläuft.

Google zeigt innere Robotermonologe

Als Vorbild dient, was als "Denken in Sprache" bezeichnet wird. Als Beispiel nennt das Team einen inneren Monolog, der sich abspielen könnte, wenn eine Person versucht, eine Tür aufzuschließen: "Ich muss die Tür aufschließen; ich versuche, diesen Schlüssel zu nehmen und ihn ins Schloss zu stecken ... nein, warte, er passt nicht, ich versuche einen anderen ... der hat funktioniert, jetzt kann ich den Schlüssel drehen."

Dieser Denkprozess umfasse Entscheidungen über unmittelbare Handlungen zur Lösung der übergeordneten Aufgabe (Schlüssel aufheben, Tür aufschließen), Beobachtungen über die Ergebnisse der versuchten Handlungen (Schlüssel passt nicht) und Korrekturmaßnahmen als Reaktion auf diese Beobachtungen (anderen Schlüssel probieren). Ein solcher innerer Monolog sei daher ein natürlicher Rahmen für die Integration von Feedback für große Sprachmodelle, so die Forschenden. Den Ansatz nennen sie "Inner Monologue" (innerer Monolog).

Video: Google

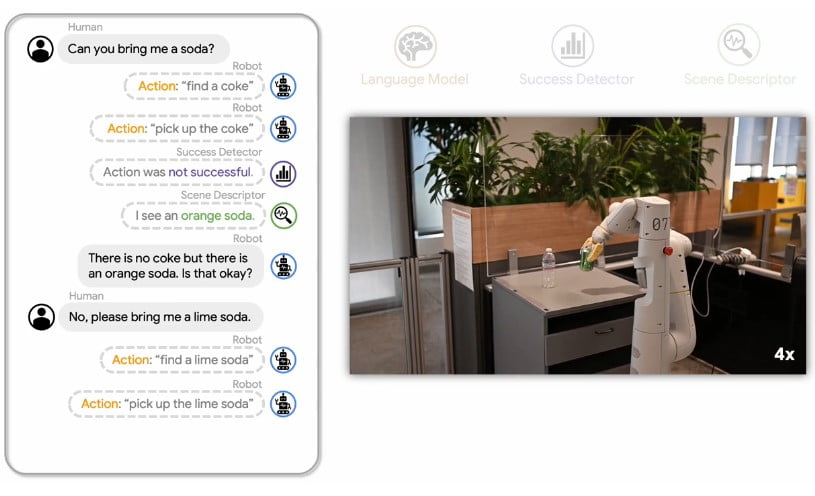

Während ältere Ansätze direkt einen komplexen Plan für ein Ziel von einem Sprachmodell generieren und so keine Möglichkeit für Korrekturen haben, füttert das Google-Team das Sprachmodell kontinuierlich mit weiteren Informationen, während der Roboter mit der Umgebung interagiert.

Diese Informationen umfassen etwa eine Beschreibung der in einer Szene sichtbaren Objekte oder eine Rückmeldung, ob eine Aktion erfolgreich war oder nicht. Ausgehend von diesen Informationen kann das Sprachmodell zudem Nachfragen an den Menschen stellen, wenn eine Anweisung unklar oder nicht mehr ausführbar ist.

Google Inner Monologue steuert Roboter in der Simulation und Realität

Googles Team testet Inner Monologue in der Simulation und der Realität. Das Sprachmodell generiert dabei auch Befehle, die den Roboter steuern. Das Modell wurde dafür lediglich mit einigen Beispielen vorbereitet (few-shot-learning).

In der Simulation sortiert ein virtueller Roboterarm so virtuelle Objekte, in der Realität ein echter Roboterarm Plastikbananen und Ketchupflaschen. Ist eine Aktion ohne Erfolg, gibt das Sprachmodell den gleichen Befehl erneut aus.

Video: Google

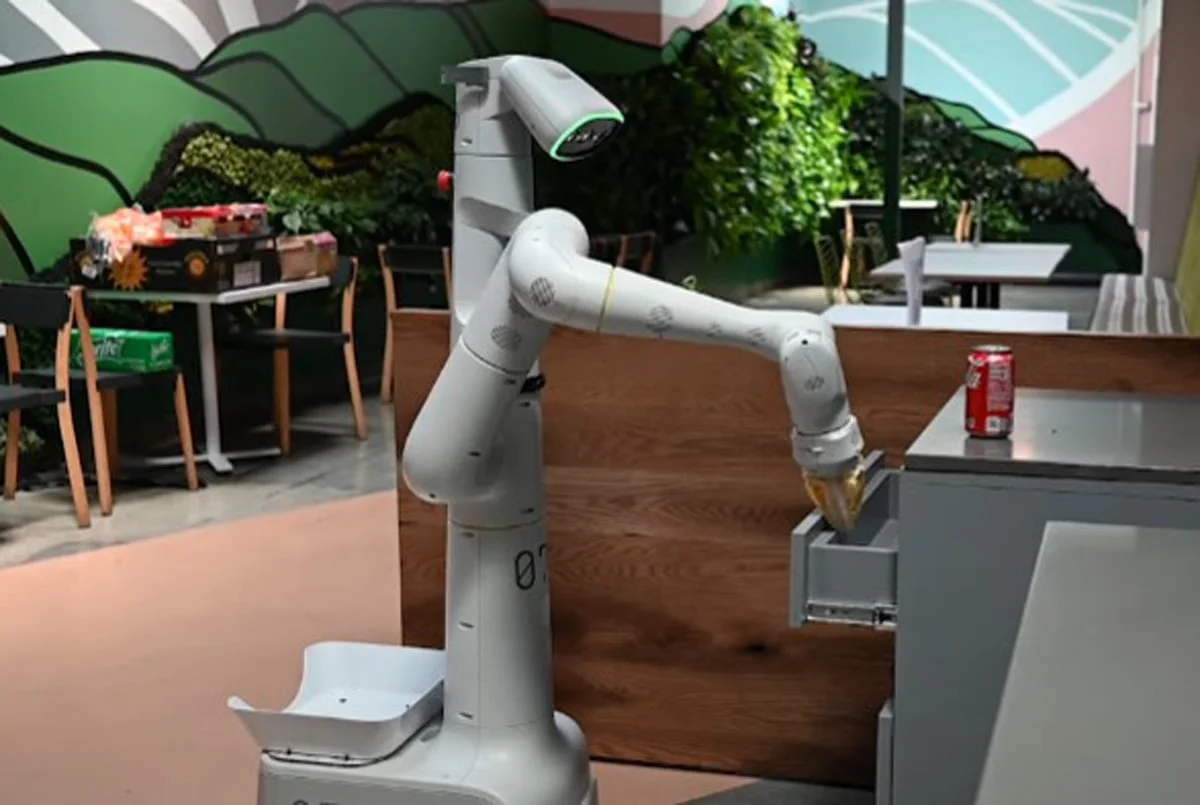

Beeindruckend ist Googles Robotereinsatz in einer echten Testumgebung, in der ein fahrender Roboterarm Getränkedosen oder Snacks aufheben, verstauen oder wegwerfen und sich dabei mit menschlichen Interventionen herumschlagen muss. Er wiederholt fehlgeschlagene Aktionen, beschreibt Szenen und stellt passende Nachfragen.

Video: Google

Dank der Sprachfähigkeiten kann sich das System kontinuierlich an neue Anweisungen anpassen und sich neue Ziele stecken, wenn alte nicht erreichbar sind. Es versteht zudem mehrere Sprachen, kann vergangene Aktionen und Umgebungsfeedback nutzen, um eine Szene besser zu verstehen und kann mit Tippfehlern umgehen. Videobeispiele dafür gibt es auf der Projektseite von Inner Monologue.

In Zukunft will das Team die Abhängigkeit des Modells von menschlichem Feedback verringern, etwa mit dem Einsatz fortschrittlicher Bild-/Videountertitlung und der Beantwortung visueller Fragen.