OpenAIs Bild-KI DALL-E 2 generiert glaubwürdige Fotos und Zeichnungen, aber schreiben kann sie nicht - oder doch? Eine Untersuchung zeigt, dass von DALL-E 2 auf Bildern generierte Wörter kein zufälliger Buchstabensalat sind, sondern eine Bedeutung haben können.

Im April veröffentlichte das KI-Unternehmen OpenAI erste Details zu DALL-E 2, einem KI-System, das beeindruckende Bilder generiert. Die Ergebnisse lagen weit über dem, was Künstliche Intelligenz bis dahin leisten konnte.

Wie schon beim Sprachmodell GPT-3 startete DALL-E 2 in einer geschlossenen Beta-Phase. Mittlerweile generierten zugelassene Nutzer:innen über drei Millionen Bilder mit DALL-E 2. Pro Woche sollen nun weiter etwa 1.000 neue Zugänge freigeschaltet werden.

DALL-E 2 hat Probleme mit Text

OpenAIs Bild-System erzeugt teilweise fotorealistische Szenen, etwa von Fake-Urlaubsbildern, Teddy-Bären im Picasso-Stil oder einer antiken Statue eines Mannes, der über eine Katze stolpert. Der Kreativität scheinen kaum Grenzen gesetzt.

Doch DALL-E 2 hat auch Schwächen, etwa wenn das System farbige Würfel auf einem Bild entgegen der Anweisung falsch anordnet, Konzepte wie Supermarkt und Renaissance vermischt oder "operated" als "operiert" und nicht "bedient" versteht.

Überdies hat DALL-E 2 Probleme, Text auf ein Bild zu bringen. Etwas, das Googles neue Bild-KI Imagen OpenAIs Produkt voraus hat. Ein Beispiel aus OpenAIs zugehöriger Forschungsarbeit: Statt in einem generierten Bild "Deep Learning" auf ein Schild zu schreiben, textet die KI "Deinp Lerpt" oder "Diep Deep".

Auch in zahlreichen anderen Versuchen produzierte DALL-E 2 lediglich Fantasiewörter. Die Ursache liegt wohl im von OpenAI verwendetem statischen multimodalen CLIP-Modell, das Teil der DALL-E-2-Architektur ist. Googles Imagen setzt dagegen auf ein großes Sprachmodell mit einem besseren Verständnis für Sprache.

Hat DALL-E 2 ein verborgenes Vokabular?

Nun zeigen Forscher der University of Texas, dass die seltsamen Zeichenfolgen von DALL-E 2 wohl doch nicht so zufällig sind, wie bisher angenommen. In zahlreichen Experimenten konnten sie zeigen, dass DALL-E 2 ein verstecktes Vokabular entwickelt hat, das in Bildern mit Text auftaucht. Diese vermeintlichen Fantasiewörter wiederum können für die Steuerung des KI-Systems eingesetzt werden.

So generiere etwa die Eingabe "Two farmers talking about vegetables, with subtitles" ein Bild mit scheinbar nichtssagendem Text.

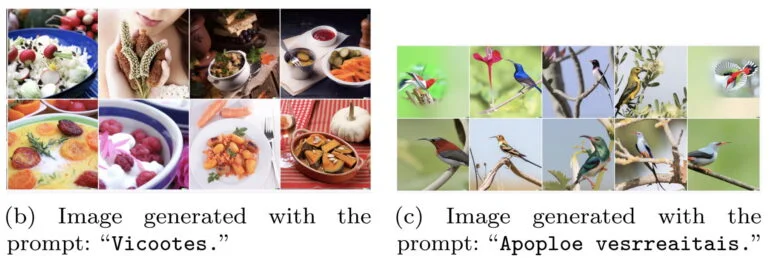

Doch wenn der Text "Vicootes" als Eingabe für DALL-E 2 genutzt wird, generiert das System Bilder von Gemüse. Der Text "Apoploe vesrreaitars" erzeugt dagegen Bilder von Vögeln.

"Es scheint, dass die Landwirte von Vögeln sprechen, die sich an ihrem Gemüse zu schaffen machen", so Mit-Autor Giannis Daras auf Twitter.

Mit der gleichen Methode finden die Forscher weitere Beispiele des DALL-E-spezifischen Vokabulars: “Wa ch zod ahaakes rea" erzeugt Bilder von Meeresfrüchten, "Apoploe vesrreaitais" je nach Stil nicht nur von Vögeln, sondern auch Insekten - der Begriff scheint also fliegende Objekte zu umfassen.

"Contarra ccetnxniams luryca tanniounons" meint - meistens - Insekten. Zusammengenommen erzeugt so die Eingabe “Apoploe vesrreaitais eating Contarra ccetnxniams luryca tanniounons” Bilder von Vögeln, die Insekten fressen.

Es sei jedoch schwer, solche robusten Beispiele zu finden, schreiben die Autoren. In vielen Fällen erzeuge das gleiche Wort zahlreiche unterschiedliche Bilder, ohne auf den ersten Blick zu erkennende Gemeinsamkeiten.

Dennoch schaffe die Entdeckung eines DALL-E-Vokabulars neue und interessante Herausforderungen bezüglich Sicherheit und Interpretierbarkeit des Modells. Aktuell filtern Sprach-Systeme die Texteingaben für DALL-E 2 und erkennen solche, die gegen OpenAIs Richtlinien verstoßen. Die scheinbar unsinnigen Eingaben mit DALL-E-Vokabular könnten genutzt werden, um diese Filter zu umgehen, so die Autoren.

Die Forscher wollen im nächsten Schritt mehr über das verborgene Vokabular von DALL-E 2 herausfinden.