Deepminds Gato löst viele Aufgaben, aber keine richtig gut. Weist das neue KI-System dennoch den Weg zu genereller Künstlicher Intelligenz?

Kurz nach OpenAIs DALL-E 2, Googles PaLM und LaMDA 2 sowie Deepminds Chinchilla und Flamingo zeigt das Londoner KI-Unternehmen ein weiteres großes KI-Modell, das bestehende Systeme übertrifft.

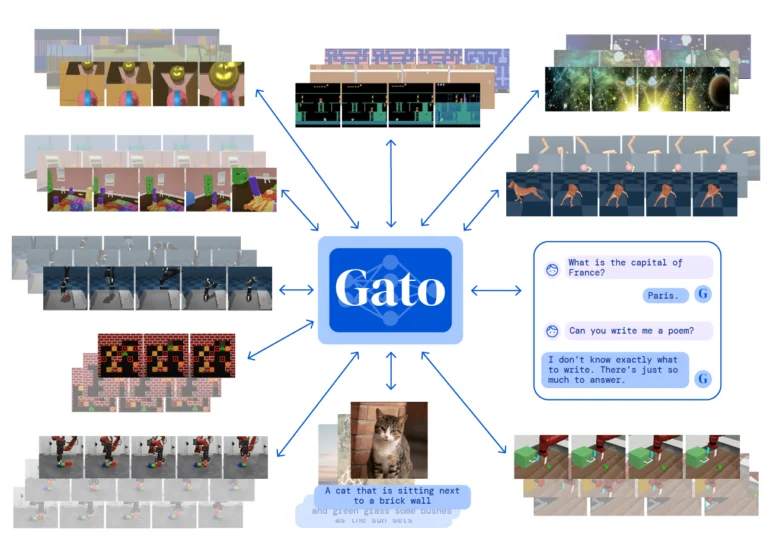

Doch Deepminds Gato ist anders: Das Modell kann nicht besser texten, nicht besser Bilder beschreiben, nicht besser Atari spielen, nicht besser Roboterarme steuern oder sich nicht besser in 3D-Räumen orientieren als andere KI-Systeme. Gato kann dafür alles ein wenig.

Video: Deepmind

Deepminds Gato nimmt, was es kriegt

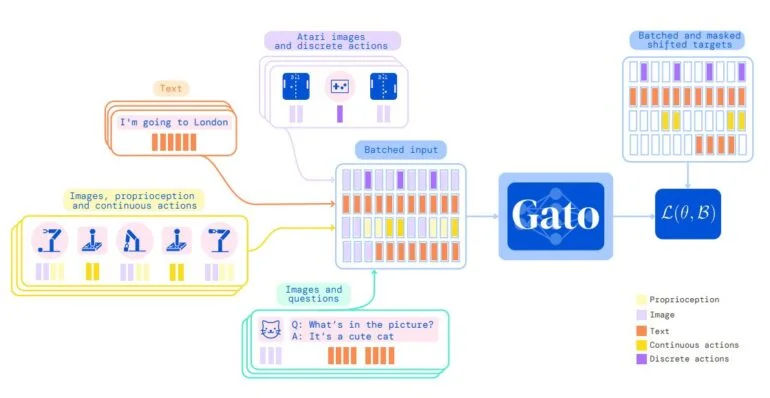

Deepmind trainierte das auf der Transformer-Architektur basierende Multitalent mit Bildern, Text, Propriozeption (eigene Körperwahrnehmung), Gelenkmomenten, Tasteneingaben und anderen "diskreten und kontinuierliche Beobachtungen und Handlungen". In der Trainingsphase werden dafür alle Daten in einer Token-Folge vom Transformer-Netz ähnlich wie in einem großen Sprachmodell verarbeitet.

Das Team testete Gato anschließend an 604 verschiedenen Aufgaben. In über 450 davon erreicht das KI-Modell etwa 50 Prozent der Leistung anderer Expertensysteme im Benchmark. Doch das ist weit hinter spezialisierten KI-Modellen, die Experten-Niveau erreichen können.

Gato und die Gesetze der Skalierung

Gato ist mit lediglich 1,18 Milliarden Parametern winzig im Vergleich zu dem 175 Milliarden Parameter großen GPT-3, dem riesigen 540-Milliarden-Parameter-Modell PaLM oder dem 70 Milliarden Parameter "kleinen" Chinchilla.

Laut des Teams liegt das vorwiegend an der Reaktionszeit des verwendeten Sawyer-Robotarms - ein größeres Modell wäre auf aktueller Hardware und mit der momentanen Architektur zu langsam, um die Roboteraufgaben durchzuführen.

Doch diese Beschränkungen seien mit neuer Hardware und Architektur leicht zu lösen, so das Team. Ein größeres Gato-Modell könnte mit mehr Daten trainieren und die zahlreichen Aufgaben voraussichtlich besser erfüllen.

Am Ende könne so ein generalistisches KI-Modell entstehen, das spezialisierte Modelle ablöse - das zeige auch die Geschichte der KI-Forschung. Das Team bezieht sich hier auch auf den KI-Forscher Richard Sutton, der als "bittere Lektion" seiner Forschungstätigkeit festhielt: "In der Vergangenheit haben sich allgemeine Modelle, die die Rechenleistung besser ausnutzen, gegenüber spezielleren, bereichsspezifischen Ansätzen durchgesetzt."

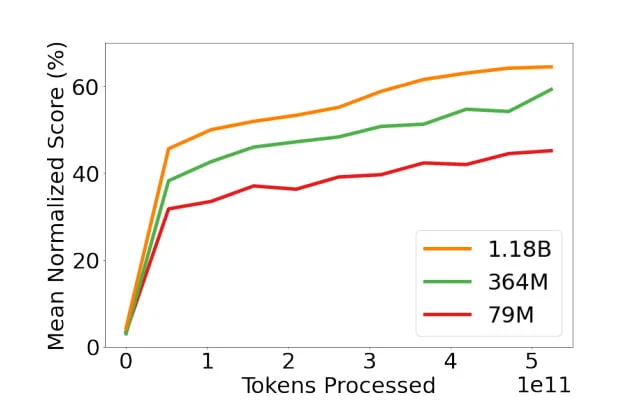

Deepmind liefert zudem eine nachweisbare Leistungssteigerung Gatos bei zunehmender Parameterzahl: Das Team trainierte neben dem großen Modell auch zwei kleinere mit 79 Millionen und 364 Millionen Parametern. Mit zunehmender Größe skaliert die durchschnittliche Leistung in den getesteten Benchmarks linear.

Dieses Phänomen ist bereits von großen Sprachmodellen bekannt und wurde Anfang 2020 in der Forschungsarbeit "Scaling Laws for Neural Language Models" ausführlich untersucht.

Zu diesen Gesetzen der Skalierung fügte Deepmind mit dem Chinchilla-Paper kürzlich noch die Bedeutung von größeren Datenmengen für die Skalierung der Leistung hinzu. Mehr Daten führen zu besserer Leistung.

Game over oder die nächste Stufe maschineller Intelligenz?

Ermöglicht die Skalierung eines Systems wie Gato eines Tages generelle Künstliche Intelligenz? Die Hoffnung in das Prinzip der Skalierung teilen nicht alle: Kognitionswissenschaftler und KI-Forscher Gary Marcus spricht in einem neuen Beitrag auf Substack zu Gato von einem verfehlten"Scaling-Über-Alles"-Ansatz. Alle aktuellen großen KI-Modelle wie GPT-3, PaLM, Flamingo oder auch Gato würden Momente der Brillianz mit absoluter Verständnislosigkeit verbinden.

Zwar seien auch Menschen fehleranfällig, doch "jeder, der ehrlich ist, wird erkennen, dass diese Art von Fehlern zeigt, dass im Moment etwas ganz und gar nicht in Ordnung ist. Wenn eines meiner Kinder regelmäßig solche Fehler machen würde, würde ich, ohne zu übertreiben, alles andere, was ich tue, fallen lassen und sie sofort zum Neurologen bringen", so Marcus.

Marcus bezeichnet diese Forschungsrichtung als Alt Intelligence: "Bei Alt Intelligence geht es nicht darum, Maschinen zu bauen, die Probleme auf eine Weise lösen, die mit menschlicher Intelligenz zu tun hat. Es geht darum, riesige Datenmengen - oft aus dem menschlichen Verhalten abgeleitet - als Ersatz für Intelligenz zu nutzen."

Dieser Ansatz sei an sich nicht neu, wohl aber die damit verbundene Hybris, allein durch Skalierung dieser Methode generelle Künstliche Intelligenz zu erreichen.

Marcus reagiert damit auch auf einen Twitter-Beitrag von Nando de Freitas, Forschungsdirektor bei Deepmind: "Jetzt geht es nur noch um den Maßstab! Das Spiel ist vorbei", so de Freitas im Kontext von Gato. "Es geht darum, diese Modelle größer, sicherer, recheneffizienter, schneller beim Sampling, intelligenter im Speicher, mehr Modalitäten, INNOVATIVE DATEN, on/offline zu machen."

De Freitas sieht Deepmind auf dem Weg zu genereller KI, wenn die beschriebenen Herausforderungen bei der Skalierung gelöst würden. Suttons Lektion sei keine bittere, sondern eine eher süße, so der Deepmind-Forscher. De Freitas drücke hier aus, was viele in der Branche denke, schreibt Marcus.

Doch seitens Deepmind kommen auch vorsichtigere Töne: "Vielleicht ist Skalierung genug. Vielleicht", schreibt der leitende Wissenschaftler Murray Shanahan. Er sehe in Gato jedoch sehr wenig, was darauf hindeute, dass Skalierung allein zu einer Generalisierung auf menschlichen Niveau führen werde. Deepmind forsche jedoch in mehrere Richtungen.