Die riesige Text-KI PanGU soll laut Huawei die Leistung von OpenAIs GPT-3 erreichen.

OpenAIs Text-KI GPT-3 vervollständigt Sätze oder Tabellen, fasst Texte zusammen oder schreibt Gedichte. Seit Juni 2020 verkauft OpenAI Zugänge zur GPT-3-API und mittlerweile gibt es mehr als 300 Apps, die auf die Text-KI setzen. GPT-3 wurde jedoch mit einem westlichen Textkorpus trainiert und kommt daher am besten mit der englischen Sprache zurecht.

Der chinesische Tech-Riese Huawei hat jetzt ein GPT-3-Äquivalent mit chinesischsprachigen Texten trainiert. Das 750 GB große KI-System PanGU-Alpha umfasst 200 Milliarden Parameter und wurde mit 1,1 Terabyte chinesischsprachigen E-Books, Enzyklopädien, News, Social-Media-Posts und Webseiten trainiert. GPT-3 ist dagegen 175 Milliarden Parameter groß und wurde mit 570 Gigabyte Text trainiert.

Die zugrundeliegende Architektur gleicht GPT-3 und setzt auf Transformer-Blöcke. Für den Datensatz sammelten die Forscher 80 Terabyte rohen Text mit chinesischen Kurzzeichen, einer vereinfachten Form der chinesischen Schrift. Anschließend entfernten die Forscher doppelte Texte, Dokumente mit weniger als 60 Prozent chinesischen Zeichen, Werbung, Spam und Texte, die mehr als drei von 724 vorher festgelegten sensitiven Wörtern enthalten.

PanGU-Alpha ist erst der Anfang

Laut Huaweis Forschern zeigt PanGU-Alpha wie GPT-3 zahlreiche Fähigkeiten bei der Textverarbeitung. Sie soll Texte zusammenfassen, Fragen beantworten oder Dialoge generieren können. Ein direkter Vergleich der Leistungsfähigkeit ist aufgrund der Sprachunterschiede nicht möglich.

Huaweis Text-KI zeigt ansonsten die GPT-typischen Schwächen: Die Forscher beobachteten irrelevante, sich wiederholende, widersprüchliche oder unlogische Sätze in generierten Texten. Auf Vorurteile in ihrem System gehen die Forscher nicht ein. Kürzlich zeigte eine Gruppe Forscher, dass GPT-3 etwa starke Vorurteile gegen Muslime in sich trägt.

Huaweis Arbeit zeigt, dass auch in China riesige Transformer-Systeme entstehen. Als Nächstes wollen die Forscher größere Modelle mit Billionen Parametern erforschen sowie multimodale Modelle, die Sprache und Bilddaten miteinander verbinden. OpenAI hat mit CLIP und DALL-E bereits Anfang 2021 zwei dieser Modelle vorgestellt.

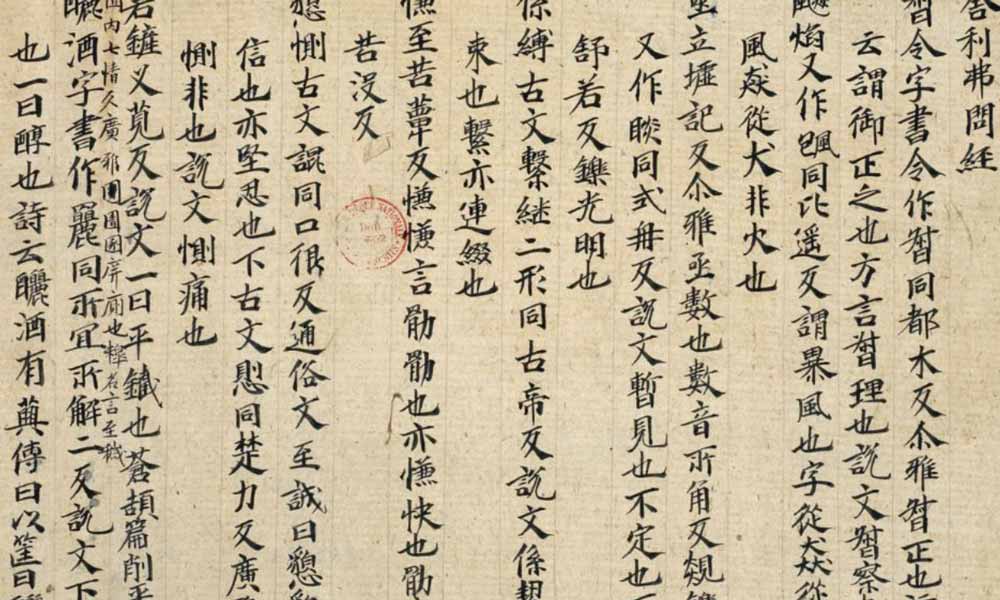

Via: Arxiv | Titelbild: By Xuanying (fl. 626-649), Public Domain, Link