Die Chipexperten von Cerebras Systems veröffentlichen neue Details zur "Wafer Scale Engine 2" mit 850.000 KI-Kernen.

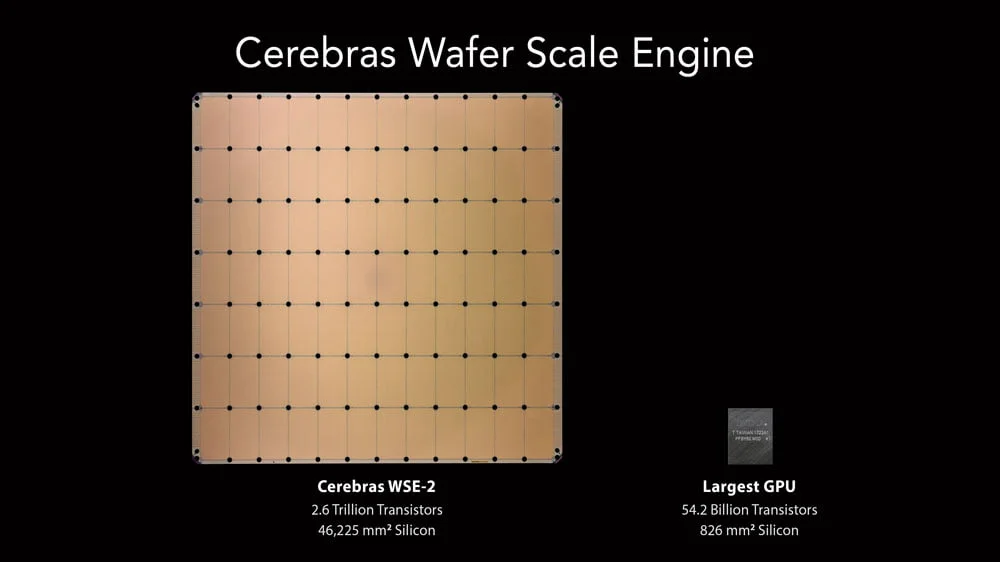

Cerebras kündigte die neue Wafer Scale Eninge 2 (WSE-2) das erste Mal auf der „Hot Chips 2020“-Konferenz an. Der neue Chip setzt auf den 7nm-Prozess des Tech-Giganten Taiwan Semiconductor Manufacturing Company (TSMC) und kommt auf 850.000 für Künstliche Intelligenz optimierte Kerne und insgesamt 2,6 Billionen Transistoren. Der Vorgänger WSE-1 setzte noch auf den 16nm-Prozess und hatte 400.000 KI-Kerne und insgesamt 1,2 Billionen Transistoren.

Die Wafer von Cerebras sind deutlich energiesparender als vergleichbare Nvidia-Systeme, in denen hunderte oder tausende GPUs in einem Server miteinander kommunizieren müssen. Da Cerebras die Kerne nicht voneinander löst, sondern im WSE-Wafer miteinander verbindet, können die einzelnen Kerne direkt über Verbindungen im Silizium kommunizieren.

Cerebras verrät mehr Details zur Ausstattung und Verfügbarkeit

Jetzt hat Cerebras mehr Details verraten: Der 46.225 mm² große WSE-2-Chip bietet neben 850.000 Kernen 40 Gigabyte On-Chip-Speicher bei einer Bandbreite von 20 Petabyte pro Sekunde. Nvidias A100-Chip ist dagegen ein Winzling: 826 mm² groß, knapp 7.350 Kerne, 40 Megabyte On-Chip-Speicher mit einer Bandbreite von 155 Gigabyte pro Sekunde.

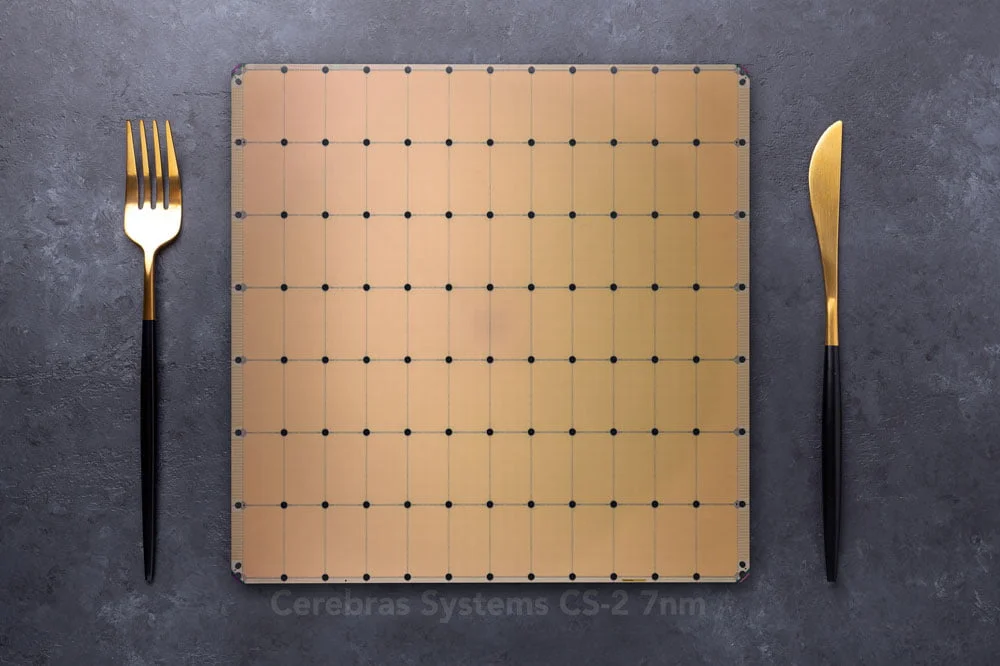

Cerebras bietet außerdem wie beim Vorgänger ein eigenes Rechensystem mit WSE-Chip an. Der WSE-2-Chip wird im CS-2-System verbaut, das wie schon das CS-1 in bestehende Rechenzentren integriert werden kann.

Laut Cerebras ersetzt ein einzelnes CS-2 ganze Cluster mit Hunderten oder Tausenden Grafikprozessoren (GPUs), die Dutzende von Server-Racks beanspruchen und Monate für die Konfiguration und Programmierung benötigen. Das CS-2 nimmt etwa ein Drittel eines Server-Racks ein.

Das CS-2-System soll im dritten Quartal 2021 verfügbar sein. Der Vorgänger kommt bereits in einigen Forschungseinrichtungen und Unternehmen zum Einsatz, etwa im Argonne National Laboratory, im Pittsburgh Supercomputing Center (PSC) oder im britischen Pharmaunternehmen GlaxoSmithKline.

Nvidia-Konkurrenz oder Nischenprodukt?

Ist das CS-2-System also die Lösung für alle KI-Probleme? Wird Cerebras das neue Nvidia?

Tech-Analysten sind skeptisch: „Cerebras scheint es mit Nvidia aufnehmen zu können, läuft aber nicht mit nativem CUDA. Das ist mittlerweile so etwas wie ein De-facto-Standard. Nvidia-Lösungen sind außerdem flexibler, da sie in fast jedes Servergehäuse passen“, sagt Tech-Analyst Patrick Moorhead über die CS-Systeme.

Auch Jim McGregor, Analyst bei Tirias Research, sieht Nvidia nicht in Gefahr. „Offensichtlich gibt es Unternehmen und Einrichtungen, die an Cerebras WSE-Lösung für große Datensätze interessiert sind“, so McGregor in einer E-Mail an Venturebeat.

Doch es gebe zahlreiche weitere Möglichkeiten auf Unternehmensebene für Millionen von anderen KI-Anwendungen, darunter auch viele, die über das hinausgingen, was Cerebras bewältigen könne. Nvidia ziele dagegen mit den eigenen Produkten auf so ziemlich alles - von Robotik bis zu Supercomputern. Cerebras sei aktuell eine Nischenplattform, so der Analyst.

Auf der diesjährigen GTC stellte Nvidia die erste eigene CPU „Grace“ vor, die zukünftig in Supercomputern wie „Alps“ verbaut wird. Der Supercomputer des Schweizer Hochleistungsrechenzentrums soll große KI-Modelle wie OpenAIs GPT-3 in zwei Tagen trainieren können. Solche großen Modelle übersteigen schnell die Speicherkapazitäten von einzelnen Karten oder auch des WSE-2-Chips.